Flink这个是需要手动创建的吗?

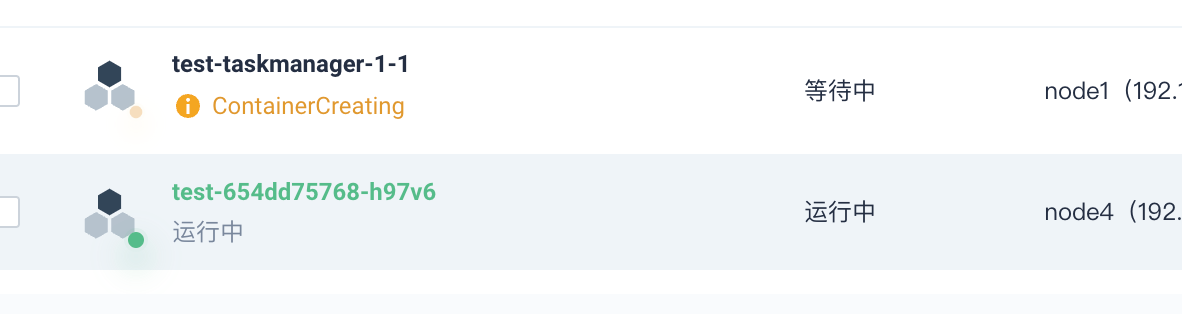

我这边想用hdfs来做checkpoint和savepoint的文件终端,现在已经把相应的jar包和core-site.xml、hdfs-site.xml配置打进镜像里了,现在jobmanager已经启动,但是拉起taskmanager的时候,

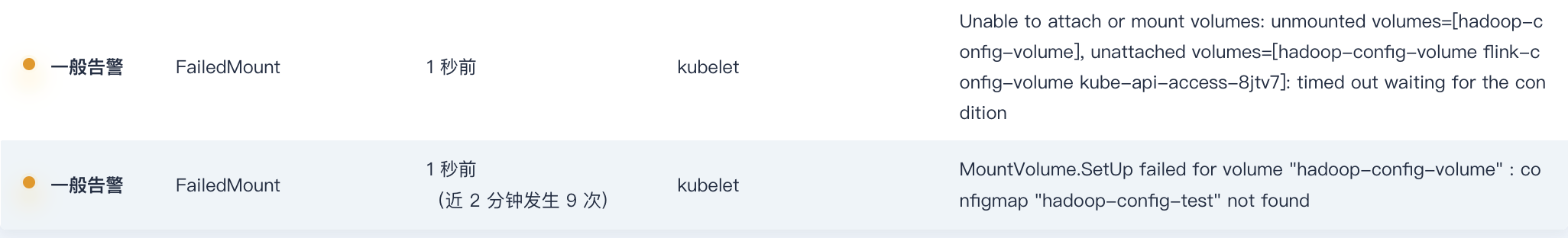

提示找不到hadoop-config-volumeFlink这个是需要手动创建的吗?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

-

根据您提供的信息,看起来是找不到hadoop-config-volumeFlink这个卷。

在Kubernetes中,卷(Volume)是一种可以由多个Pod共享的存储资源。当您在Pod定义中引用一个卷时,Kubernetes会在该Pod运行的节点上创建一个持久化的存储空间,并将它挂载到Pod中的指定路径下。

根据您的描述,您已经将相应的jar包和配置文件打进镜像里了,并且JobManager已经启动。但是当TaskManager启动时,提示找不到hadoop-config-volumeFlink这个卷。这可能是因为您没有在TaskManager的Pod定义中引用这个卷。

要解决这个问题,您可以按照以下步骤操作:

确认您的TaskManager的Pod定义中是否引用了hadoop-config-volumeFlink这个卷。可以在TaskManager的Pod定义中找到类似于以下的卷引用部分:

volumes: - name: hadoop-config-volumeFlink hostPath: path: /path/to/hadoop/config确保这个卷引用部分存在于TaskManager的Pod定义中。

如果上述卷引用部分不存在于TaskManager的Pod定义中,您需要手动添加它。可以将上述示例代码添加到TaskManager的Pod定义中的

volumes部分。请确保将/path/to/hadoop/config替换为实际的Hadoop配置文件所在的路径。保存并应用TaskManager的Pod定义后,重新启动TaskManager。现在,TaskManager应该能够找到hadoop-config-volumeFlink这个卷,并且可以正常启动。

2023-11-30 09:19:57赞同 展开评论 -

面对过去,不要迷离;面对未来,不必彷徨;活在今天,你只要把自己完全展示给别人看。

我猜测您可能正在尝试使用HDFS作为Flink的Checkpoint和Savepoint文件存储终端。如果您在启动TaskManager时遇到问题,请尝试以下步骤:

- 确保您的JobManager已经成功启动,并且可以与TaskManager通信。

- 检查您的Hadoop配置文件(core-site.xml和hdfs-site.xml)是否正确地配置了HDFS的地址、端口号和其他相关参数。

- 确保您的Hadoop集群已经启动并运行正常,可以通过执行hdfs dfs -ls命令来检查HDFS的状态。

- 如果您使用的是Kubernetes部署Flink,则需要确保您的Pod中有足够的权限来访问HDFS文件系统。

- 在启动TaskManager之前,请确保您的镜像中包含了Flink的Hadoop-Flink connector jar包以及其他必要的依赖库。

2023-11-16 13:55:30赞同 1 展开评论

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。