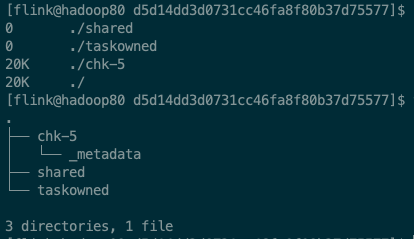

Flink双流join任务使用checkpoint恢复失败,怎么处理?现象:找不到文件错误:Caused by: java.io.FileNotFoundException: /data1/flink/checkpoint/xxx/checkpoint2/d5d14dd3d0731cc46fa8f80b37d75577/chk-5/2c17a70a-b189-40c3-8c5d-e95816517709 (No such file or directory)过程:类似的set配置,在单表实时任务中测试,chk恢复成功但是在双流join任务中恢复失败会找chk-x文件夹下的一个不存在的文件(所以报错了),但是我看了好多任务,chk-x文件夹下都是只有一个_metadata文件

版本flink1.12相关set配置

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

针对Flink双流join任务使用checkpoint恢复失败的问题,可以尝试以下方法进行处理:

env.setCheckpointingMode(CheckpointingMode.EXACTLY_ONCE);

env.setCheckpointDir("/data1/flink/checkpoint");

检查checkpoint文件是否存在。如果存在,请尝试删除该文件,然后重新启动Flink任务。如果不存在,可能是由于其他原因导致的错误,需要进一步排查。

检查Flink版本是否与配置文件中的设置一致。如果不一致,请更新Flink版本或修改配置文件以匹配当前版本。

如果以上方法都无法解决问题,可以尝试在启动Flink任务时添加以下参数,以便查看更详细的错误信息:

-Dlog.file=/path/to/your/logfile.log

将/path/to/your/logfile.log替换为实际的日志文件路径。这样,当任务出现错误时,可以在日志文件中查找更多关于错误的详细信息。

这种问题是由于检查点路径不对所引起的,请检查以下几点:

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。