Flink CDC同步开源的那个postgresql数据库有碰到这个情况的不?

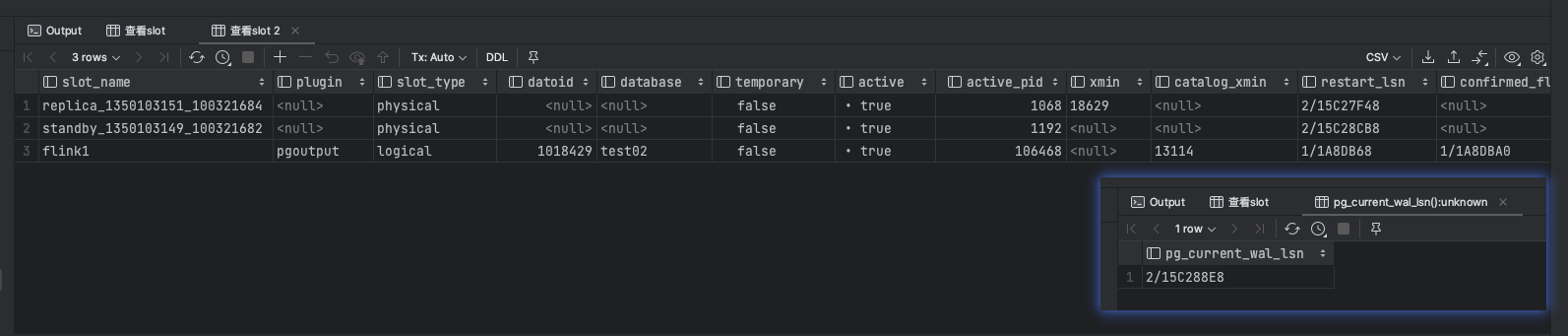

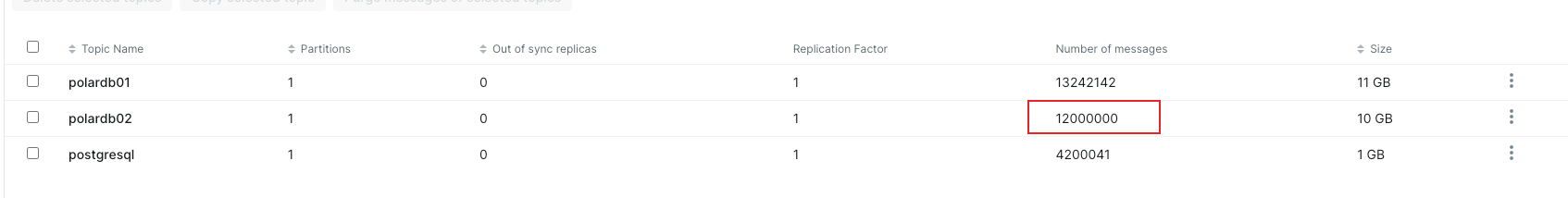

Flink CDC阿里云基于postgresql做的polardb我用flink 2.2 postgresql 连接器做同步。查询polardb的slot显示没有消费,但是我kafka显示收到了数据。这导致wal日志持续增加且不删除。同步开源的那个postgresql数据库有碰到这个情况的不?

-

面对过去,不要迷离;面对未来,不必彷徨;活在今天,你只要把自己完全展示给别人看。

Flink CDC连接Polardb进行实时同步时,可能会出现Wal Log持续增加且不删除的现象。这是因为WAL Log是记录数据变动的重要信息,在不断发生数据变动的情况下,自然会有新的 WAL Log生成。

针对这种情况,可以考虑以下解决方案:- 优化处理能力。您可以检查现有的配置,并增加计算资源以提高处理能力,避免出现数据积压现象;

- 及时归档和清理 WAL Log。可以在Polardb中设置定时任务,定期清理历史 WAL Log;

- 检查代码逻辑。看看是否有误操作或者其他异常导致 WAL Log不断增加,如有必要,及时修复代码漏洞或者设置适当的恢复策略。

2023-11-15 14:39:43赞同 1 展开评论 打赏 -

从你的描述来看,你的Flink CDC任务似乎无法正常消费Kafka中的数据,导致PostgreSQL的WAL日志持续增加且不删除。这可能是由于以下原因导致的:

Flink CDC任务配置问题:请检查你的Flink CDC任务的配置,包括任务名称、任务类型(例如,Source、Sink等)以及任务的连接信息(例如,JobManager地址、端口、用户名、密码等)。

Flink CDC任务运行问题:请检查你的Flink CDC任务是否正常运行。你可以通过查看任务的日志来判断。如果任务没有正常运行,可能是因为任务崩溃或者任务被终止。

Kafka数据消费问题:请检查你的Kafka数据是否被正确消费。你可以通过查看Kafka的主题的偏移量来判断。如果偏移量没有变化,可能是因为Flink CDC任务没有正确消费Kafka中的数据。

PostgreSQL WAL日志清理问题:请检查你的PostgreSQL的WAL日志清理机制是否正常工作。你可以通过查看PostgreSQL的日志来判断。如果WAL日志没有被正确清理,可能是因为PostgreSQL的WAL日志清理机制出现问题。

2023-11-15 08:59:59赞同 展开评论 打赏

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。