Flink CDC代码得sink 怎么与这种catalog结合啊?

Flink CDC代码得sink 怎么与这种catalog结合啊?

展开

收起

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

1

条回答

写回答

-

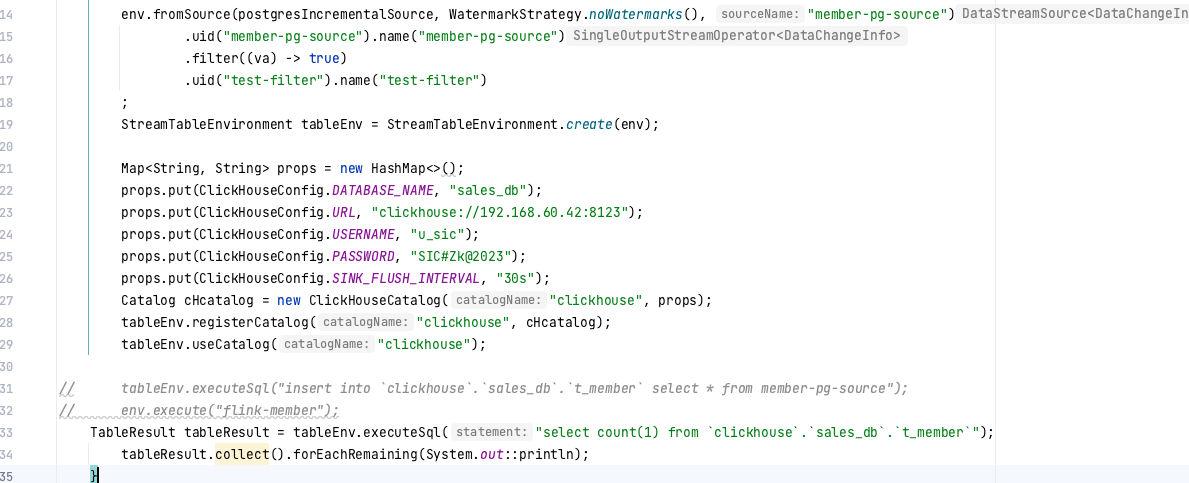

要将Flink CDC代码的sink与Catalog结合,您需要按照以下步骤操作:

首先,确保您的Flink集群已经安装了Catalog支持。例如,如果您使用的是Apache Flink 1.13或更高版本,那么默认情况下已经包含了Catalog支持。

在Flink配置文件(如flink-conf.yaml)中,启用Catalog功能。添加以下配置项:

execution.catalog.default-database: your_database_name execution.catalog.default-schema: your_schema_name将

your_database_name和your_schema_name替换为您要使用的数据库和模式名称。- 创建一个Catalog实例,用于连接到您的数据源。例如,如果您使用的是MySQL数据库,可以创建一个如下的Catalog实例:

import org.apache.flink.table.catalog.mysql.MySqlCatalog; String hostname = "localhost"; Integer port = 3306; String username = "root"; String password = "password"; String databaseName = "your_database_name"; MySqlCatalog mySqlCatalog = new MySqlCatalog(hostname, port, username, password, databaseName); mySqlCatalog.setDefaultDatabase(databaseName); mySqlCatalog.setDefaultSchema(databaseName);- 使用Catalog实例创建一个表,用于存储Flink CDC捕获的数据。例如,如果您使用的是MySQL数据库,可以创建一个如下的表:

import org.apache.flink.table.api.TableEnvironment; import org.apache.flink.table.catalog.CatalogBaseTable; import org.apache.flink.table.catalog.ObjectIdentifier; TableEnvironment tableEnv = TableEnvironment.create(environment); ObjectIdentifier tableIdentifier = new ObjectIdentifier("your_table_name", "your_database_name"); CatalogBaseTable table = mySqlCatalog.getTable(tableIdentifier); tableEnv.registerTable("your_table_name", table);- 编写Flink CDC代码,将数据写入到刚刚创建的表中。例如:

import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment; import org.apache.flink.table.api.bridge.java.StreamTableEnvironment; StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment(); StreamTableEnvironment tableEnv = StreamTableEnvironment.create(env); // 注册MySQL表作为源表 tableEnv.executeSql("CREATE TABLE source_table (...) WITH (...)"); // 使用Flink CDC从源表捕获数据,并将数据写入到目标表中 tableEnv.executeSql(""" INSERT INTO target_table SELECT * FROM source_table """); env.execute("Flink CDC Example");通过以上步骤,您可以将Flink CDC代码的sink与Catalog结合,实现对数据的捕获、存储和管理。

2023-11-02 15:08:01赞同 1 展开评论

问答分类:

问答地址:

开发者社区

>

大数据与机器学习

>

实时计算 Flink

>

问答

相关问答

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。

相关文章

热门讨论

热门文章

展开全部

还有其他疑问?

咨询AI助理