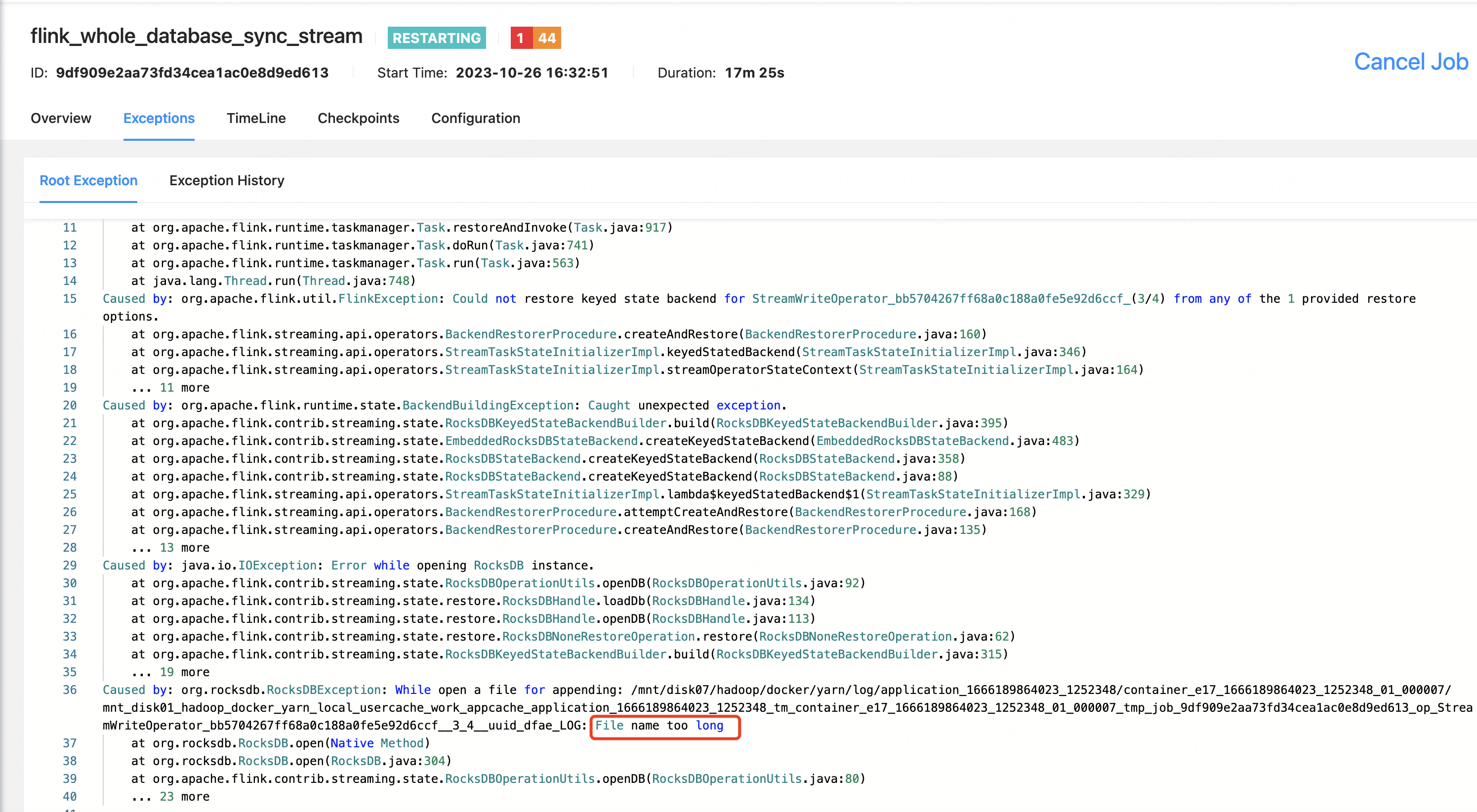

在Flink中checkpoint产生的文件名太长报错,各位大佬有遇到的吗?

代码实现mongo数据整库写hudi,采用RocksDBStateBackend状态后端,在Flink中checkpoint产生的文件名太长报错,各位大佬有遇到的吗?

展开

收起

4

条回答

写回答

写回答

-

确实有遇到这种情况的可能。当使用Flink的RocksDBStateBackend时,由于RocksDB的特性,可能会在磁盘上生成大量的文件。特别是在使用checkpoint的时候,可能会产生大量的文件。如果文件名过长,可能会超过操作系统允许的文件名长度限制,从而产生错误。

这个问题可以通过以下几种方式解决:

- 缩短作业名称或任务名称:由于文件名是包含作业或任务名称的,因此缩短作业或任务名称可以减少文件名长度。

- 调整RocksDB的配置:可以通过调整RocksDB的配置来减少产生的文件数量。例如,可以增加

state.backend.rocksdb.local-db-dirs的数量,让数据分布在更多的目录中。 - 调整checkpoint的频率和大小:可以通过调整checkpoint的频率和大小来减少产生的文件数量。例如,可以增加checkpoint的间隔时间,或者减少每次checkpoint的数据量。

- 使用其他的状态后端:如果这个问题始终无法解决,可能需要考虑使用其他的状态后端。例如,可以使用Flink的内置KVState后端,或者使用其他的持久化存储作为状态后端。

2023-11-02 15:36:54赞同 展开评论 打赏 -

在使用 RocksDBStateBackend 过程中,确实可能会遇到 checkpoint 文件名过长而导致的错误。由于 Linux 系统限制了文件路径的最大长度为 255 字节,当 checkpoint 文件名称太长时就会发生错误。

解决这个问题的方法有两种:- 增加任务 manager 的数量:通过增加任务 manager 的数量,可以将更多的 checkpoint 分散到多个目录中,从而减少单个文件路径的长度。具体做法是在 Flink 配置文件中增加 taskmanager.numberOfTaskSlots 参数,使其大于当前的任务数量。

- 修改 RocksDBStateBackend 的配置:可以修改 RocksDB 的相关配置项,将 checkpoint 文件保存到其他位置,或者改变文件命名规则以减少长度。具体做法是在 Flink 配置文件中增加 rocksdb.local.dir 和 state.checkpoints.dir 参数,将 checkpoint 文件保存到其他位置;或者添加 rocksdb.write-ahead-log.filename 表示法,使其只包含时间戳而不包含任务 ID 等冗余信息。

2023-11-01 21:37:57赞同 展开评论 打赏 -

面对过去,不要迷离;面对未来,不必彷徨;活在今天,你只要把自己完全展示给别人看。

当采用 RocksDBStateBackend 作为状态后端时,在 Flink 中可能出现文件名过长的问题,请采取如下措施:

- 在执行 checkpoint 时,请检查和调整文件名长度限制参数;

- 适当减小命名规则或精简存储名称;

- 使用通配符形式的命名规则,比如

*.json或*.txt等; - 删除不需要的历史 checkpoint 文件,以降低存储成本。

2023-11-01 14:11:04赞同 展开评论 打赏 -

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

相关问答

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。

热门讨论

热门文章

FFA 2024 大会门票免费送!AI时代下大数据技术未来路在何方?

1638

flink1.20.0 部署后发布报错,是怎么回事,各种配置都配置了

252

在建行,数据通常来源于哪些?

538

Caused by: org.apache.kafka.common.errors.TimeoutE

3328

FlinkCDC MySQL 中 scan.startup.mode 用的是什么模式啊?

3591

Flink sql将数组炸开,实现hive的explode函数的效果,还有什么其他好的方式?

1565

请问flink-connector-jdbc在sink时,如何设置批量写入?

3166

Flink 集群重启后,所有的Jobs任务全都没有了。如果快速恢复所有的任务

1268

Apache Flink未授权访问上传导致的RCE漏洞,这个漏洞目前方案解决吗?

604

Flink如何配置Task Manager?

680

展开全部

OPPO数据中台之基石:基于Flink SQL构建实数据仓库

21922

Flink SQL 功能解密系列 —— 维表 JOIN 与异步优化

27953

阿里云实时计算产品案例&解决方案汇总

27878

基于实时计算(Flink)打造一个简单的实时推荐系统

14408

Flink Checkpoint 问题排查实用指南

13206

广告场景下的实时计算

11052

Flink SQL 功能解密系列 —— 数据去重的技巧和思考

10881

Apache Flink 漫谈系列(15) - DataStream Connectors之Kafka

8903

Flink SQL 功能解密系列 —— 阿里云流计算/Blink支持的connectors

7027

咱们从头到尾讲一次 Flink 网络流控和反压剖析

6075

展开全部