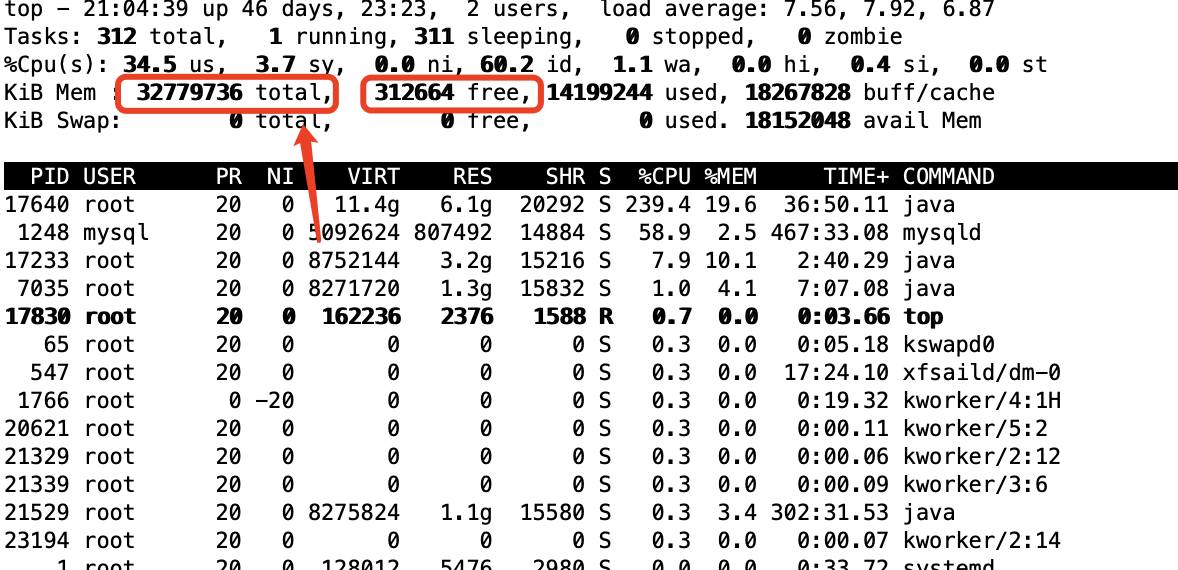

Flink CDC做大表全量+增量同步时,发现内存使用飙升而且不下降,表数据似乎直接缓存在内存,太占内存空间了。这问题如何解决?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

Flink CDC 做大表全量+增量同步时,如果内存使用飙升且不下降,有可能是以下几个原因:

数据量太大,导致 Flink 集群的内存不足。

Flink 集群配置不合理,导致内存使用过高。

使用的 Flink CDC 版本较低,存在内存泄漏问题。

要解决这个问题,可以尝试以下方法:

减少数据量。如果数据量过大,可以考虑使用分区表的方式,将数据分散到多个表中,这样可以减少每个表的数据量,并降低 Flink 集群的内存压力。

调整 Flink 集群的配置。可以根据集群的实际情况,调整 Flink 集群的配置,例如调整 taskmanager.memory.size 和 jobmanager.memory.size 的值。

使用较新的 Flink CDC 版本。Flink CDC 的较新版本修复了内存泄漏问题,可以有效降低 Flink 集群的内存使用。

如果通过上述方法还无法解决问题,可以联系 Flink 官方支持。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。