大数据计算MaxCompute如果我把这个参数变小,那不是内存使用率更小了吗?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在MaxCompute中,调整参数的大小确实会影响内存使用率,但具体效果取决于参数的作用范围和场景。以下是对您问题的详细解答:

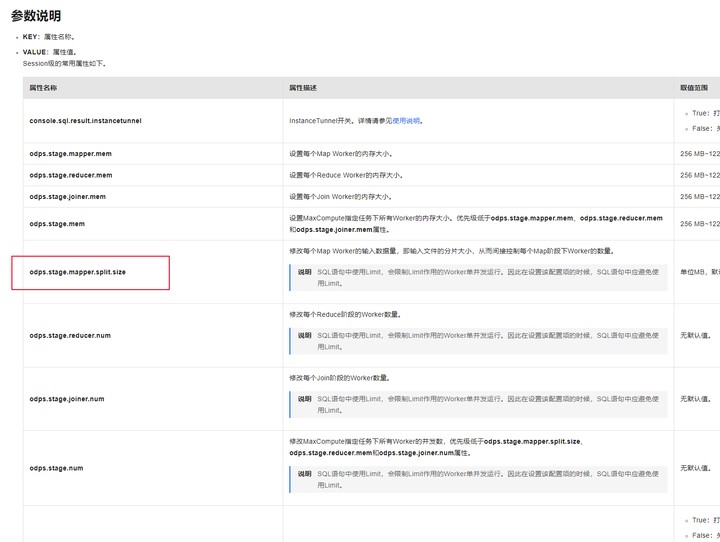

在MaxCompute中,许多参数直接或间接影响内存的分配和使用。例如: - spark.driver.memory 和 spark.driver.memoryOverhead:这些参数控制Driver的内存大小和额外内存。如果将这些值调小,Driver可用的内存会减少,可能会导致内存不足的问题(如java.lang.OutOfMemoryError或Cannot allocate memory)。 - odps.stage.mapper.split.size 和 odps.stage.joiner.mem:这些参数分别控制Map Worker的输入数据量和Join Worker的内存大小。如果将这些值调小,可能会降低单个任务的内存需求,但也可能导致任务频繁失败或性能下降。

因此,调小参数并不总是意味着内存使用率更低,而是需要根据具体的作业需求和资源限制进行权衡。

调小某些参数虽然可以减少单次任务的内存占用,但也可能引发以下问题: - 任务失败:如果内存不足以处理当前任务的数据量,可能会导致任务失败。例如,当Driver需要Collect较大数据量时,调小spark.driver.memory可能导致OutOfMemoryError。 - 性能下降:调小odps.stage.mapper.split.size可能会导致每个Map任务处理的数据量过小,从而增加任务调度开销,降低整体性能。 - 误判率增加:对于布隆过滤器(Bloom Filter),如果调小capacity或增大error_rate,虽然可以减少内存使用,但会显著增加误判率,影响查询效率。

为了在内存使用率和性能之间取得平衡,建议采取以下措施: 1. 分析作业需求: - 如果作业涉及大量数据的聚合或Join操作,建议适当增加odps.stage.joiner.mem或odps.stage.reducer.num,以避免内存不足。 - 对于布隆过滤器,根据实际数据量和误判容忍度,合理设置capacity和error_rate,避免过度调小导致误判率过高。

监控资源使用:

1级配额CPU使用率和1级配额MEM使用率)来评估当前资源的使用情况,并根据实际需求调整参数。分阶段优化:

set odps.sql.udf.jvm.memory=xxx;单独调整Java UDF的内存大小,观察是否解决了内存不足问题。调小参数确实可以在一定程度上降低内存使用率,但需要结合具体场景和作业需求进行调整。盲目调小参数可能导致任务失败或性能下降,因此建议: - 优先分析作业瓶颈:通过日志和监控指标定位内存不足的具体原因。 - 合理配置参数:根据数据量、任务复杂度和资源限制,选择合适的参数值。 - 测试与验证:在小规模环境中验证参数调整的效果,确保不会对生产环境造成负面影响。

如果您能提供具体的参数名称或使用场景,我可以为您提供更详细的优化建议!

MaxCompute(原ODPS)是一项面向分析的大数据计算服务,它以Serverless架构提供快速、全托管的在线数据仓库服务,消除传统数据平台在资源扩展性和弹性方面的限制,最小化用户运维投入,使您经济并高效的分析处理海量数据。