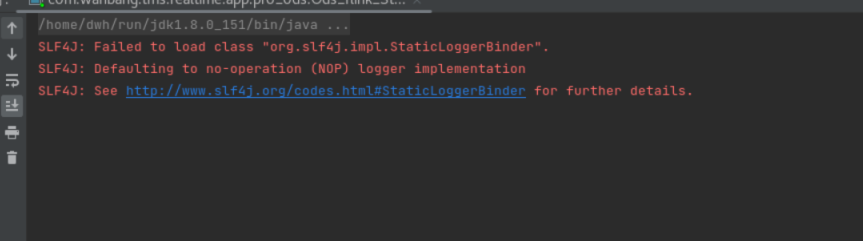

Flink CDC连接postgres数据库,没报错一切正常,slot也创建了就是没数据有大佬遇到过吗?日志都没加载出来

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在使用Flink CDC连接PostgreSQL数据库时,如果一切配置正常且没有报错,但仍然没有数据加载出来,可能是由于以下几个原因导致的。以下是详细的排查步骤和解决方案:

确保PostgreSQL数据库的逻辑复制功能已正确启用,并满足以下条件: - wal_level 参数:必须设置为 logical,以支持逻辑解码。 - max_wal_senders 和 max_replication_slots 参数:确保这些参数的值大于当前数据库中已使用的复制槽数量与Flink作业所需的slot数量。 - 表的 REPLICA IDENTITY 设置:同步表的 REPLICA IDENTITY 必须设置为 FULL,以确保逻辑解码插件能够捕获完整的变更数据(包括旧值)。

验证方法:

SHOW wal_level;

SELECT relname, relreplident FROM pg_class WHERE relkind = 'r';

检查Flink CDC Source的配置是否正确,尤其是以下关键参数: - slot.name:确保每个表都设置了唯一的 slot.name 参数,避免出现冲突或重复的slot。 - scan.startup.mode:默认值为 initial,表示先扫描全量数据再读取增量数据。如果只想读取增量数据,可以将其设置为 latest-offset。 - decoding.plugin.name:确保逻辑解码插件名称正确,默认为 decoderbufs 或 pgoutput。如果使用 pgoutput,需要高权限账号支持。

示例配置:

CREATE TABLE postgrescdc_source (

shipment_id INT,

order_id INT,

origin STRING,

destination STRING,

is_arrived BOOLEAN

) WITH (

'connector' = 'postgres-cdc',

'hostname' = '<yourHostname>',

'port' = '5432',

'username' = '<yourUserName>',

'password' = '<yourPassWord>',

'database-name' = '<yourDatabaseName>',

'schema-name' = '<yourSchemaName>',

'table-name' = '<yourTableName>',

'slot.name' = 'unique_slot_name',

'scan.startup.mode' = 'initial'

);

Postgres CDC连接器依赖Flink的Checkpoint机制来更新Postgres slot中的LSN(Log Sequence Number)。如果Checkpoint未开启或配置不当,可能导致数据无法正常加载。

解决方法: - 确保Flink作业启用了Checkpoint,并设置合理的间隔时间。例如:

env.enableCheckpointing(5000); // 每5秒触发一次Checkpoint

Postgres CDC连接器只能捕获表中的变更数据(INSERT、UPDATE、DELETE)。如果表中没有发生任何变更操作,则不会产生WAL日志,CDC也无法读取到数据。

验证方法: - 在PostgreSQL中手动插入或更新数据,观察Flink作业是否能捕获到变更。 - 如果表中已有历史数据,但未发生变更,可以通过设置 scan.startup.mode 为 initial 来读取全量数据。

通过查看Flink作业的日志和监控指标,进一步定位问题: - 日志信息:检查Flink作业日志中是否有异常或警告信息。 - 监控指标: - currentFetchEventTimeLag 和 currentEmitEventTimeLag:仅在增量阶段有效,用于衡量数据从产生到被处理的时间延迟。 - sourceIdleTime:如果该值持续增加,说明Source长时间未接收到新数据。

SUPERUSER 或 REPLICATION 权限,并对目标表具有 SELECT 权限。heartbeat.interval.ms 参数,以定期发送心跳包推进Slot偏移量。示例配置:

'heartbeat.interval.ms' = '30000' -- 每30秒发送一次心跳包

如果以上步骤均无误,但仍无法加载数据,建议逐步排查以下内容: 1. 确认PostgreSQL逻辑复制配置是否正确。 2. 检查Flink CDC Source的参数配置,尤其是 slot.name 和 scan.startup.mode。 3. 确保Flink作业启用了Checkpoint。 4. 验证表中是否存在数据变更。 5. 查看日志和监控指标,定位潜在问题。

通过以上方法,您应该能够找到问题的根本原因并解决数据加载失败的问题。您可以复制页面截图提供更多信息,我可以进一步帮您分析问题原因。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。