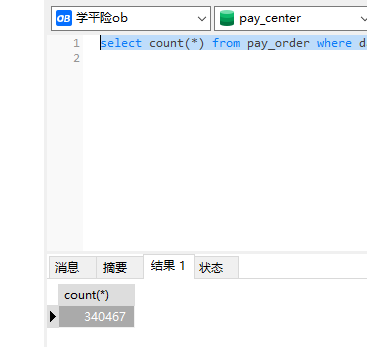

Flink CDC我任务正常 但是数据一直不消费是什么情况?

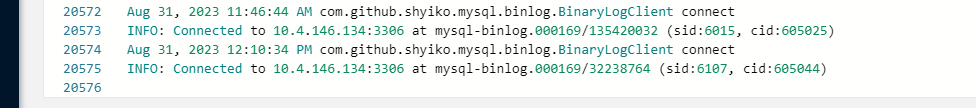

而且日志也就停留在了 12.10 但是没报错

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

根据您描述的情况,Flink CDC任务正常运行但数据一直不消费,并且日志停留在某个时间点(如12:10)而没有报错,可能是由以下几个原因导致的。以下是详细的排查步骤和解决方案:

WITH参数中增加connect.timeout的值(默认为30秒),例如设置为60秒。SHOW VARIABLES LIKE 'expire_logs_days';

如果保留时间过短(如默认1天),可能会导致Binlog被清理。

SET GLOBAL expire_logs_days=7;

pipeline.operator-chaining: 'false'

execution.checkpointing.interval: 300000

consumerGroup),并检查消费组的Checkpoint是否正常保存。consumeFromCheckpoint参数:

consumeFromCheckpoint: 'true'

ALTER TABLE yourTableName REPLICA IDENTITY FULL;

根据上述分析,您可以按照以下步骤逐步排查问题: 1. 检查网络连通性和Binlog保留时间。 2. 确认Checkpoint配置是否合理。 3. 排查是否存在反压问题。 4. 检查MySQL实例类型和权限配置。 5. 确认日志消费进度是否正常更新。

如果问题仍未解决,建议启用算子探查功能,进一步分析具体算子的运行状态和日志输出。您可以复制页面截图提供更多信息,我可以进一步帮您分析问题原因。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。