Flink启动能同步全量数据,后续新插入数据不能增量同步,请问是什么问题?checkpoint也开启了

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

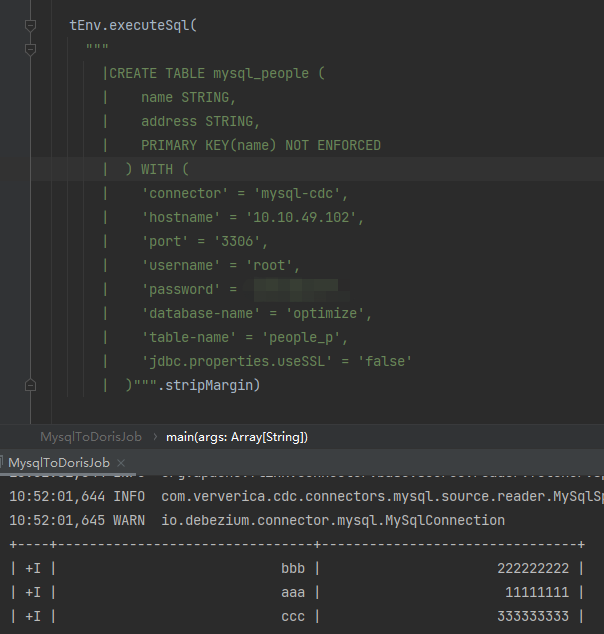

这个问题的原因可能有以下几种:

Kafka 的 offset 没有正确更新。

Flink 的 consumer 没有正确配置。

Kafka 的 topic 权限不正确。

Flink 的任务没有启动。

你可以尝试检查以下几点:

确认 Kafka 的 offset 已经被正确更新。你可以使用 Kafka 客户端 或者 Kakfa CLI 查看 Kafka topic 的 offset。

检查 Flink 的 consumer 配置,确保配置正确。你可以使用 Flink 配置文档 查看 Flink 消费 Kafka 的配置。

检查 Kafka 的 topic 权限,确保 Flink 的 consumer 有权限读取 Kafka topic。你可以使用 Kafka 管理界面 或者 Kafka CLI 查看 Kafka topic 的权限。

检查 Flink 的任务是否已经启动。你可以使用 Flink Web UI 查看 Flink 任务的状态。

如果以上检查都没有问题,那么你可以提交 Issue 或者通过 邮件列表 反馈给我们。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。