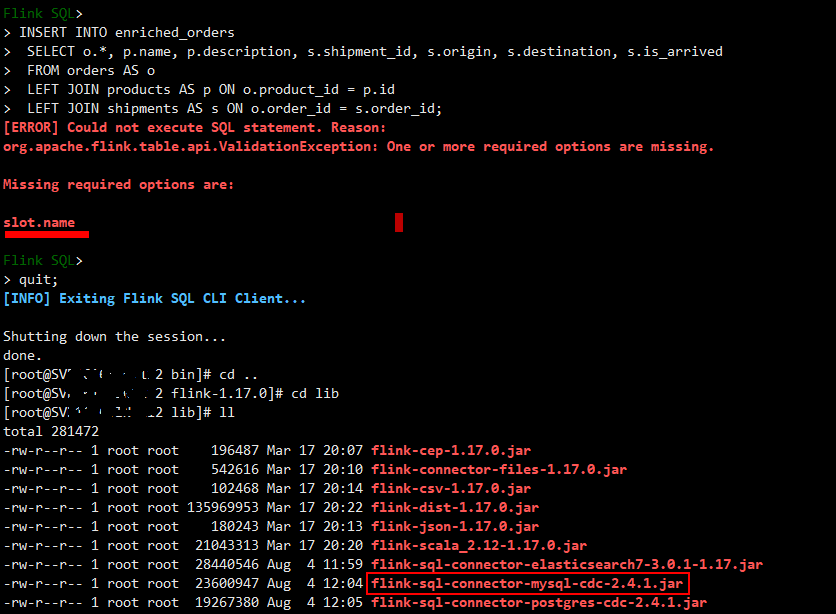

"问题1:Flink CDC是jar包版本不对吗?

问题2:https://ververica.github.io/flink-cdc-connectors/master/content/%E5%BF%AB%E9%80%9F%E4%B8%8A%E6%89%8B/mysql-postgres-tutorial-zh.html@李奕辰我是用的快速上手,文档没有写slot.name相关内容。是不是我必须手动编译2.5的jar包,不能使用现有2.4的jar包?"

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

这个错误表明Flink SQL没有正确配置数据源,导致无法执行INSERT INTO语句。

主要原因可能是:

没有添加支持数据库表的Catalog和TableSource。

Catalog/TableSource的jar版本与Flink不兼容。

Catalog配置中缺少table.name等重要选项。

建议操作:

检查是否注册过Catalog及相关TableSource

确认Catalog/TableSource jar版本与Flink一致

额外配置catalog.default-database等选项

重启Session刷新元数据

尝试降级Catalog版本进行测试

通过代码形式注册Catalog避免xml配置问题

查看日志详细定位错误原因

一般来说,Flink SQL执行Insert需要保证数据源注册完整。

版本兼容也很重要,需要一致性实现。

"回答1:slot.name 应该是必须的参数,你看下PG的参数里有写。

回答2:https://ververica.github.io/flink-cdc-connectors/release-2.4/content/connectors/postgres-cdc.html?highlight=slot

此回答整理至钉群“Flink CDC 社区”。"

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。