两位大佬,Flink按你们给的思路,已经把数据流转为table了,然后接下来还应该怎么写啊?DataStream dataStream = source

.flatMap(baseFlatMap)

.name("数据转换")

.uid("flatmap");

StreamTableEnvironment tableEnv = StreamTableEnvironment.create(environment);

String createTableDDL = "CREATE TEMPORARY TABLE ams_datasync_test (\n" +

" id INT,\n" +

" name STRING,\n" +

" PRIMARY KEY (id) NOT ENFORCED\n" +

") WITH (\n" +

" 'connector' = 'jdbc',\n" +

" 'url' = 'jdbc:mysql://10.16.26.82:3306/yondif-ams-pcrw-online',\n" +

" 'username' = 'root',\n" +

" 'password' = 'Ufgov@12345',\n" +

" 'table-name' = 'ams_datasync_test',\n" +

" 'driver' = 'com.mysql.cj.jdbc.Driver',\n" +

" 'sink.insert-only' = 'false',\n" +

" 'sink.pk-mode' = 'upsert'\n" +

")";

tableEnv.executeSql(createTableDDL);

//读取源

Table inputTable = tableEnv.fromDataStream(dataStream);

tableEnv.createTemporaryView("InputTable", inputTable);

String insertIntoDDL = "INSERT INTO ams_datasync_test SELECT * FROM InputTable";

TableResult tableResult = tableEnv.executeSql(insertIntoDDL);

//这就完成了么?接下来还做什么?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

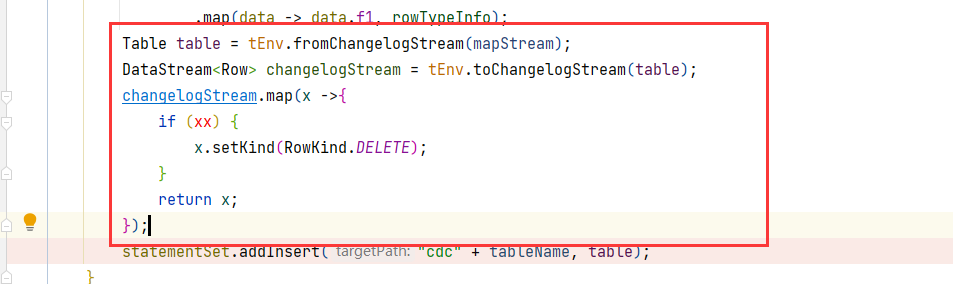

使用 DataStream 转化为 Table 之后,可以使用 Table API 和 SQL 对数据进行处理。

以下是一个简单的示例:

// 创建一个 DataStream 对象

DataStream dataStream = ...;

// 转换为 Table 对象

Table table = dataStream.toTable();

// 使用 Table API 对数据进行处理

Table result = table

.select("word")

.groupBy("word")

.count();

// 使用 SQL 对数据进行处理

result.execute().print();

更详细的用法可以参考 Flink 官方文档。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。