DataWorks开启消息订阅操作步骤是什么?

{

"requestId": "0a06dfe616905130471828366ecbc4",

"data": "RUN",

"errMsg": "success",

"errCode": 0

} 大概看下是返回成功的

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在DataWorks中,开启消息订阅需要进行如下操作:

创建数据源:在DataWorks数据集成模块中,创建一个支持消息订阅的数据源,例如Kafka或DataHub数据源。

配置数据源属性:在创建数据源时,需要填写数据源的相关属性,包括数据源类型、数据源名称、Endpoint、AccessKey、SecretKey等信息。其中,Endpoint、AccessKey、SecretKey等信息需要根据具体的消息队列服务商进行配置。

创建数据同步任务:在创建数据源之后,需要创建一个数据同步任务,用于订阅消息队列中的数据并将数据同步到目标数据存储中。在创建数据同步任务时,需要选择订阅模式,并配置相关的订阅参数,包括Topic、分组ID、消息类型、批处理大小等。

配置同步任务属性:在创建数据同步任务时,需要设置同步任务的相关属性,包括同步源、同步目标、同步方式、同步周期等。其中,同步源为之前创建的数据源,同步目标可以是数据存储、数据表或者其他数据源,同步方式可以是全量同步或增量同步,同步周期可以是一次性同步或定时同步。

要在 DataWorks 中开启消息订阅操作,您可以按照以下步骤进行:

打开 DataWorks 控制台,并进入相应的项目空间。

在左侧菜单中选择「数据集成」模块。

在数据集成模块中,选择「消息订阅」。

在消息订阅页面,点击「创建订阅任务」按钮。

在创建订阅任务页面,选择您要使用的消息队列服务(如 Kafka 或 DataHub)。

根据消息队列服务的要求填写相关配置信息,包括连接信息、主题名称、分区信息等。

配置订阅目标,例如选择将消息写入文件系统、数据库或其他数据存储方案。根据您的需求,选择合适的目标类型并配置相关参数。

确认配置无误后,点击「保存并启动」按钮。

以上是大致的步骤来开启消息订阅操作。根据具体的情况和要求,可能还需要进行其他的配置和调整。

关于返回成功的情况,如果您按照以上步骤正确配置并启动订阅任务,DataWorks 会返回一个成功的提示,通常会显示订阅任务的状态为「运行中」或类似信息。

请注意,确保您具有正确的权限和配置来连接到消息队列服务,并且 DataWorks 环境可以与消息队列服务进行通信。

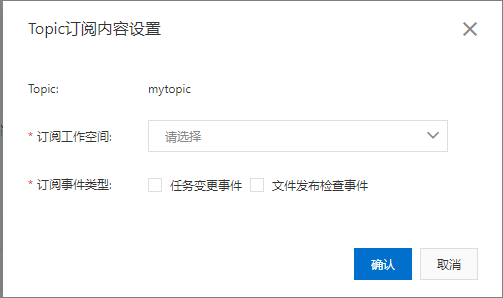

使用开放消息前,需要按照如下指导在DataWorks上先开启消息订阅功能并配置好消息队列Kafka版的相关配置信息,方便后续使用消息队列Kafka版开发消息订阅。登录DataWorks控制台。在左侧导航栏,单击开放平台。选择开放消息,打开启动消息订阅开关,即可开启消息订阅服务。说明 开启消息订阅服务后,DataWorks将会把指定事件类型的消息推送到您创建的Topic中,若关闭启动消息订阅开关,则会停止所有Topic的消息推送。单击新建Topic,填写Topic名称和描述,单击确定。说明 该Topic主要描述消息的主题,用于消息分类。Topic名称一旦创建,无法修改。在所创建的Topic右侧,单击订阅设置,在Topic订阅内容设置窗口,为当前Topic选择需要订阅的工作空间和事件类型。

说明一个Topic最多可以订阅5个工作空间。目前,订阅事件类型仅支持任务变更事件、文件发布检查事件和表变更事件,不同地域支持的消息类型有所不同,具体请以产品界面为准(更多事件类型逐步丰富中,敬请期待)。单击新建用户,在Topic下拉列表,选择需要订阅的Topic,填写Consumer Group名称、用户名、密码、描述信息,单击确定,即可创建一个用户。说明Consumer表示从消息队列Kafka版接收消息的应用。Consumer Group代表一组具有相同Group ID的Consumer。此处创建的用户及密码用于消息队列Kafka版的PLAIN机制的安全校验。Consumer Group和用户名一旦创建,无法修改。如果需要修改Consumer Group和用户名,则需要删除该用户,重新创建即可。目前密码不支持修改,如需更改,可在用户列表区域进行重置即可。

https://help.aliyun.com/document_detail/215365.html

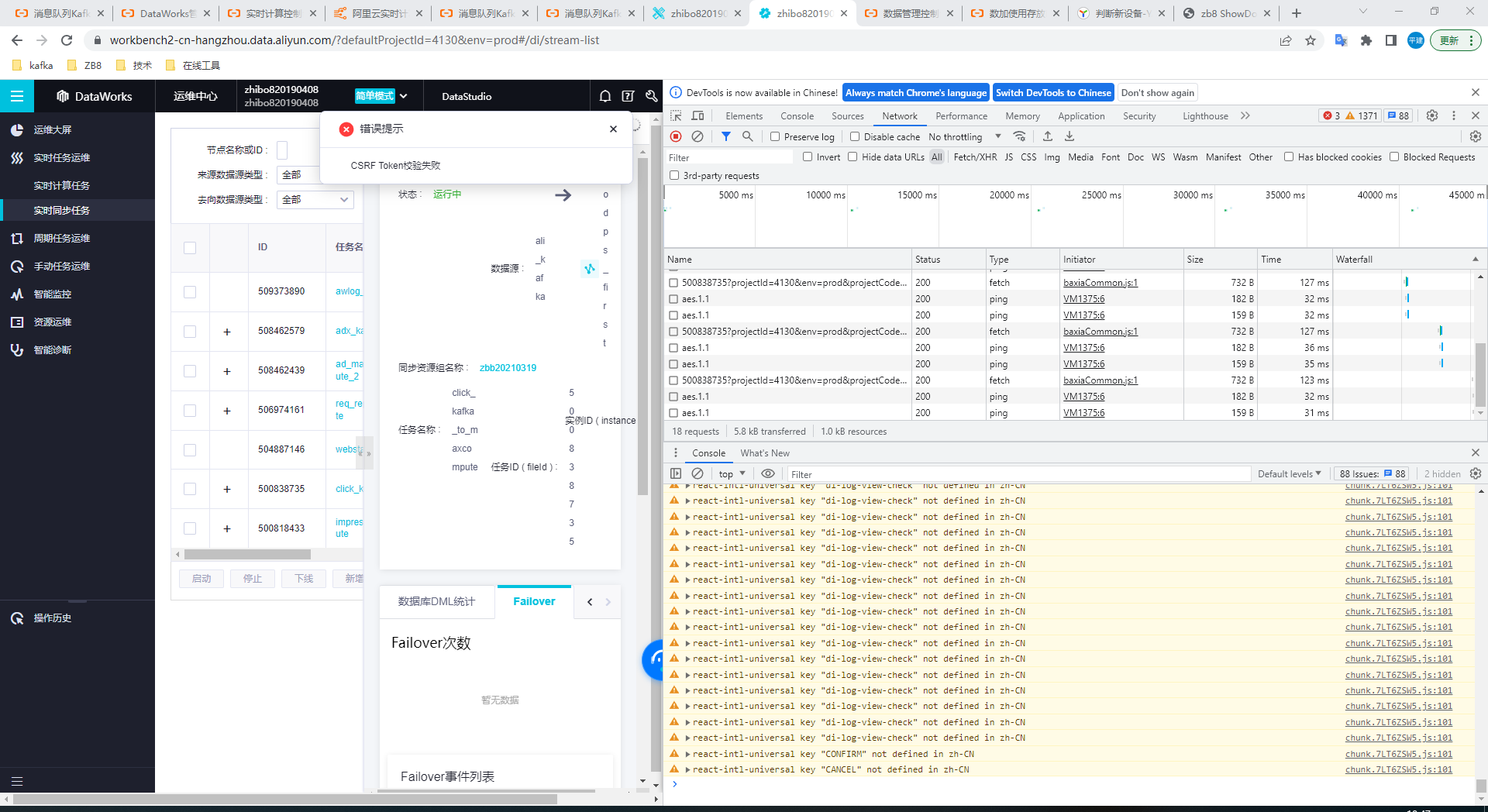

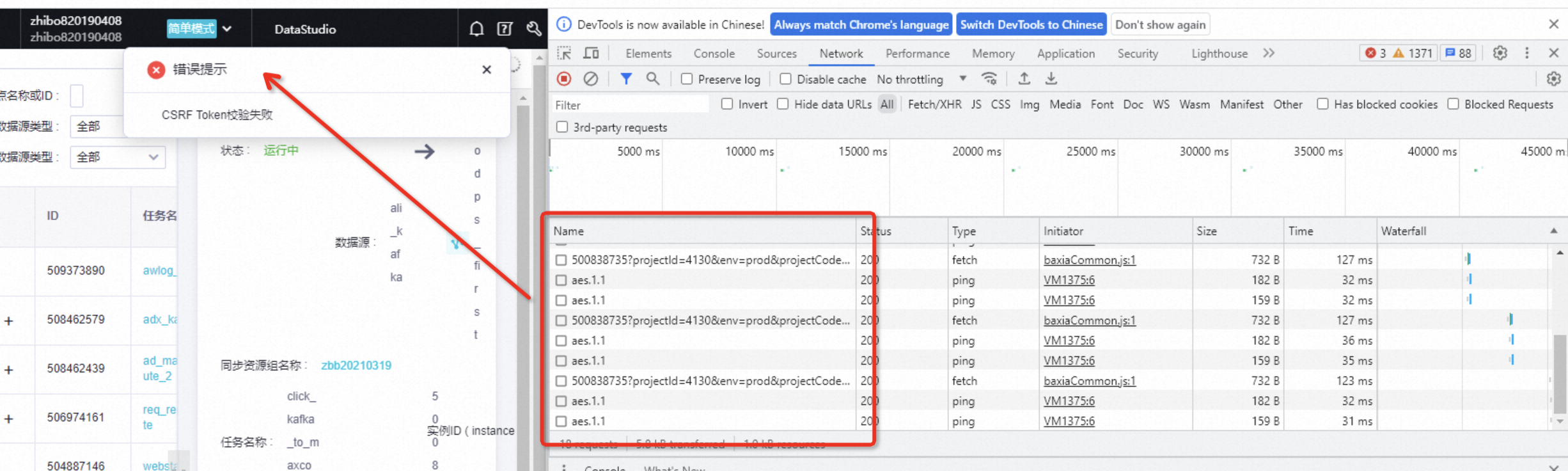

您点一下这里的请求 看下是否有这个错误相关的返回 然后辛苦复制一下文本

,此回答整理自钉群“DataWorks交流群(答疑@机器人)”

DataWorks基于MaxCompute/Hologres/EMR/CDP等大数据引擎,为数据仓库/数据湖/湖仓一体等解决方案提供统一的全链路大数据开发治理平台。