Flink CDC中dinky界面如何配置?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

Flink CDC(Change Data Capture)是 Flink 提供的一种用于捕获和处理数据变更的功能。而 Dinky 是 Flink CDC 的 Web 界面,可以用于监控和管理 CDC 任务。以下是配置 Dinky 界面的步骤:

下载 Dinky:首先,你需要从 Flink 官方仓库中下载 Dinky 的源代码或已构建的二进制文件。Dinky 的源代码位于 flink/flink-runtime-web 仓库中。

构建和打包 Dinky:如果你下载的是 Dinky 的源代码,你需要使用 Maven 或 Gradle 将其构建为可执行的 JAR 文件。如果你已经下载了编译好的二进制文件,则可以跳过此步骤。

配置 Flink Web Dashboard:在 Flink 的 flink-conf.yaml 配置文件中,找到并修改以下参数:

web.upload.dir: /path/to/dinky/files # 指定上传目录,将 Dinky 的构建文件放在这个目录下

web.tmpdir: /path/to/tmp/dir # 指定临时目录,Dinky 运行时会使用该目录

配置日志路径:在 Flink 的 log4j.properties 或 logback.xml 配置文件中,添加以下配置来指定 Dinky 的日志输出路径:

log4j.logger.org.apache.flink.dinky=INFO, file

log4j.appender.file=org.apache.log4j.FileAppender

log4j.appender.file.File=/path/to/dinky.log

log4j.appender.file.layout=org.apache.log4j.PatternLayout

log4j.appender.file.layout.ConversionPattern=%d{yyyy-MM-dd HH:mm:ss,SSS} %-5p %c{1} - %m%n

将 /path/to/dinky.log 替换为你希望存储 Dinky 日志的路径。

启动 Dinky:在命令行中运行以下命令来启动 Dinky:

./bin/flink run -c org.apache.flink.dinky.server.WebServer /path/to/dinky.jar

将 /path/to/dinky.jar 替换为 Dinky 的可执行 JAR 文件路径。

访问 Dinky 界面:在浏览器中访问 http://<flink_web_dashboard_host>:<flink_web_dashboard_port>,其中 <flink_web_dashboard_host> 是 Flink Web Dashboard 的主机名或 IP 地址,<flink_web_dashboard_port> 是 Flink Web Dashboard 的端口号,默认为 8081。

通过以上步骤,你应该能够成功配置和启动 Dinky 界面,并在浏览器中访问监控和管理 CDC 任务。

需要注意的是,Dinky 界面是作为一个单独的服务运行的,并与 Flink 运行时独立。因此,确保你已经正确安装和配置了 Flink,并且可以正常访问 Flink Web Dashboard 才能使用 Dinky 界面。

如果您要在Flink CDC中使用Dinky界面进行数据同步,可以按照以下步骤进行配置:

下载Dinky工具:您可以从Flink官网上下载最新版本的Dinky工具,解压后即可使用。

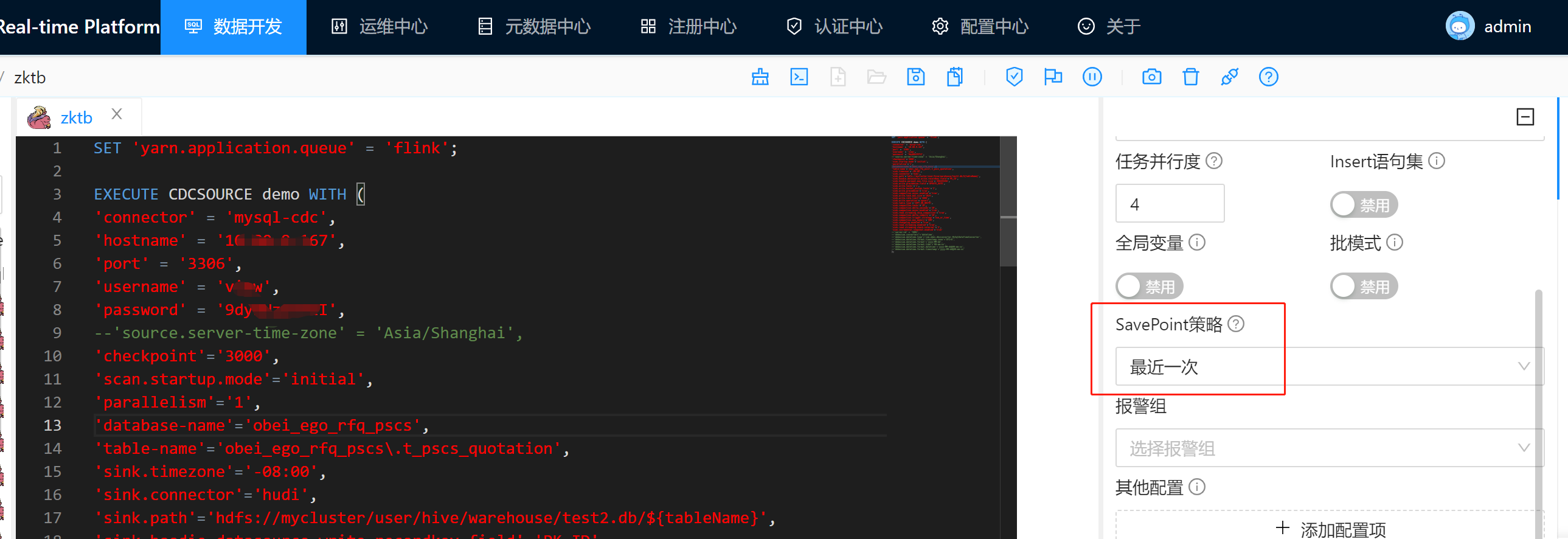

配置Dinky参数:在使用Dinky进行数据同步之前,需要配置一些必要的参数,例如源数据库地址、目标数据库地址、用户名、密码等。您可以通过在命令行中添加参数的方式进行配置。以下是一个Dinky命令的示例:

jboss-cli

Copy

dinky --config dinky.yaml --source-type mysql --source-uri jdbc:mysql://localhost:3306/test --source-username root --source-password 123456 --target-type mysql --target-uri jdbc:mysql://localhost:3306/test --target-username root --target-password 123456 --table-list test.user

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。