Flink CDC中,我是flink1.17.1+mysql cdc2.4.0+mysql5.7(source端),当前是启动任务全量数据可以同步,增量数据不同步,checkpoint开启了,也没见什么异常信息。怎么排查?

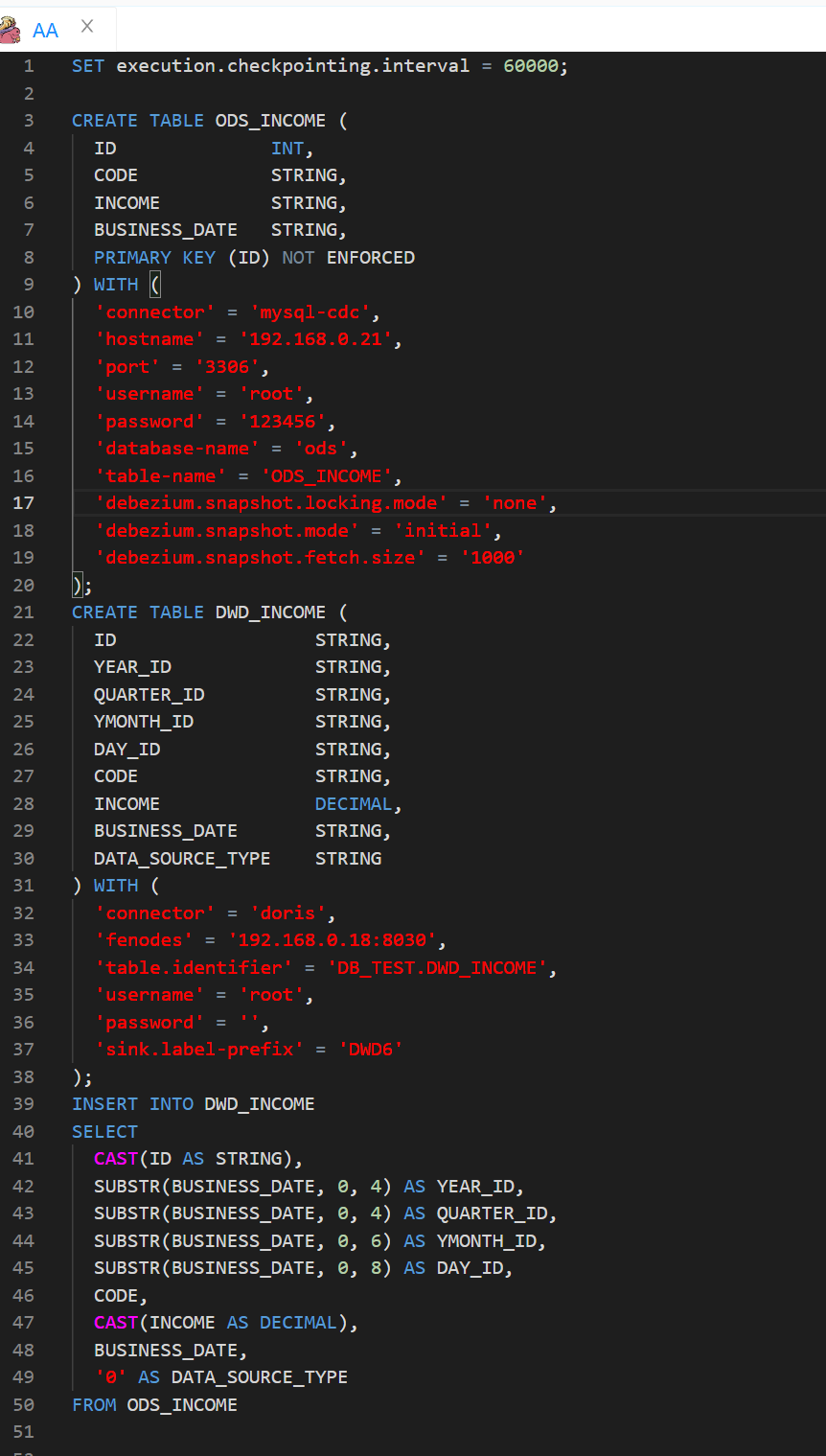

我这边使用的Dinky,通过SQL的方式做的,如下是SQL配置部分

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

如果在 Flink CDC 中启动任务后,发现全量数据可以同步,但增量数据无法同步,请尝试以下排查步骤:

检查 CDC Source 配置:确保你正确配置了 CDC Source。验证 CDC Source 的数据库连接信息、表名和其他相关配置是否正确。特别注意检查是否选择了正确的数据库类型和版本。

确认数据库变更日志是否正常:检查数据库的变更日志是否正常生成并写入到 CDC Source 监听的位置。确保数据库正常记录了增删改操作,并且 CDC Source 可以正确获取这些变更日志。

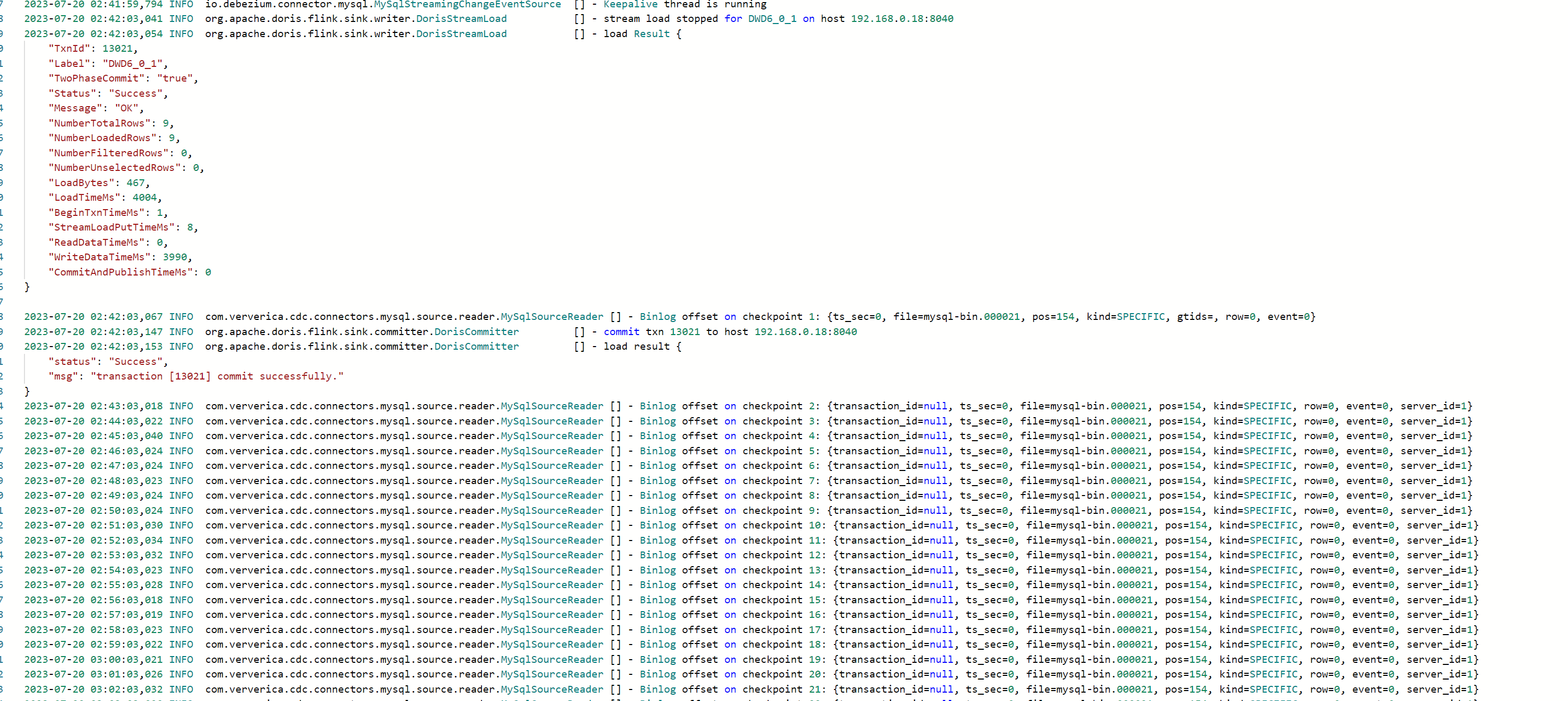

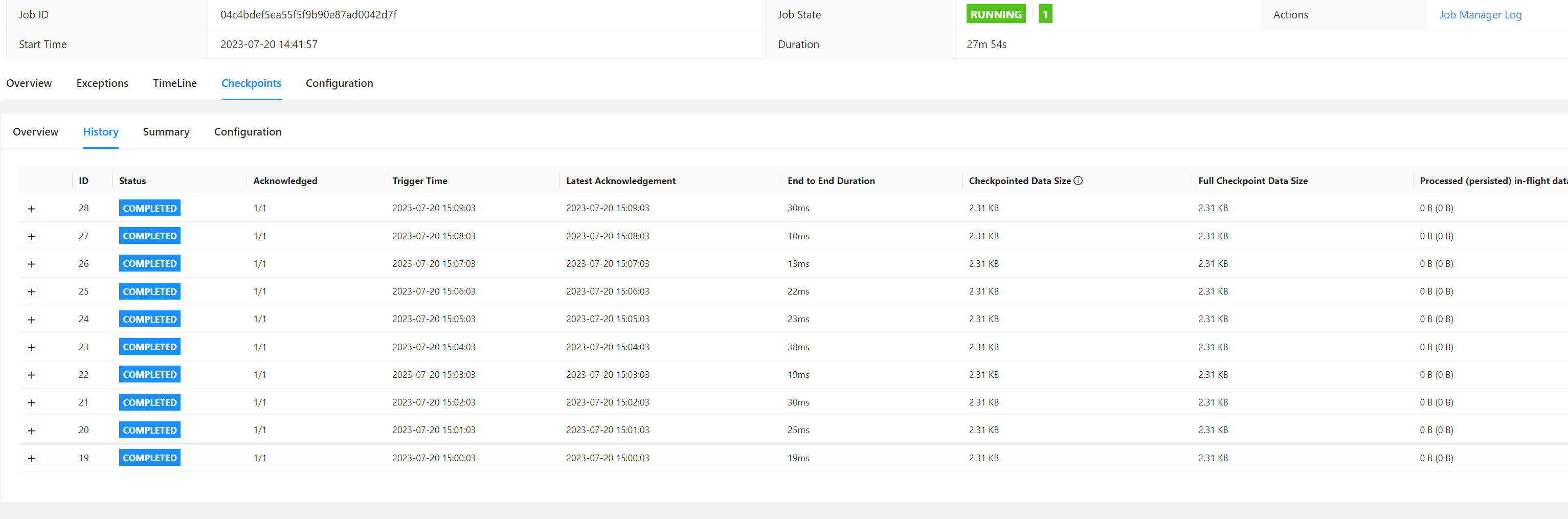

检查 CDC Source 是否能够捕获增量数据:在 Flink 应用程序中添加日志输出或调试信息,以确认 CDC Source 是否能够成功捕获到增量数据。观察日志或调试信息中是否有关于增量数据的输出。

查看任务日志:检查 Flink 作业的日志,特别是与 CDC 相关的日志信息。查找任何与增量数据同步相关的错误消息、异常堆栈等。

检查目标 Sink 配置:确保你正确配置了目标 Sink(如 Elasticsearch)。验证 Sink 的地址、索引名称、类型映射等配置是否正确,并与目标系统的实际配置匹配。

检查网络连接和权限:确保 Flink 作业所在的环境能够正常访问目标 Sink(如 Elasticsearch),并具有合适的网络连接和访问权限。

确认版本兼容性:检查 Flink CDC 和目标 Sink 的版本兼容性。确保你使用的 Flink CDC 版本与目标 Sink 版本兼容,并查阅相关文档以了解任何已知的兼容性问题。

通过仔细排查以上步骤,你应该能够定位到增量数据无法同步的具体原因并解决问题。如果问题仍然存在,请提供详细的错误信息、配置和日志,以便我们更准确地帮助你诊断和解决问题。

如果 Flink CDC 中启动任务时可以同步全量数据,但无法同步增量数据,可能是以下原因导致:

CDC 源表配置错误:检查 CDC 源表的配置是否正确,包括表名、字段名、主键等是否正确。如果配置错误,可能会导致 CDC 无法正确识别增量数据。

CDC 源表数据变化太快:如果 CDC 源表的数据变化太快,可能会导致 Flink CDC 无法及时处理数据,从而无法同步增量数据。可以尝试调整 Flink CDC 的算子并行度、窗口时间等参数,以提高数据处理能力。

数据库连接问题:检查数据库连接是否正常,包括连接字符串、用户名和密码是否正确,数据库是否可达等。

CDC 源表数据格式问题:检查 CDC 源表的数据格式是否符合 Flink CDC 的要求,包括数据类型、数据格式、数据编码等。如果数据格式不符合要求,可能会导致 Flink CDC 无法正确解析数据。

Flink CDC 配置问题:检查 Flink CDC 的配置是否正确,包括 CDC 源表的配置、CDC 目标表的配置、CDC 任务的配置等。

可以先调试print看看有没有增量信息。增量数据不够,大数据场景基本是微批sink数据,你的数据还没达到sink的条件,还在缓存里。此回答整理至钉群“Flink CDC 社区”。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。