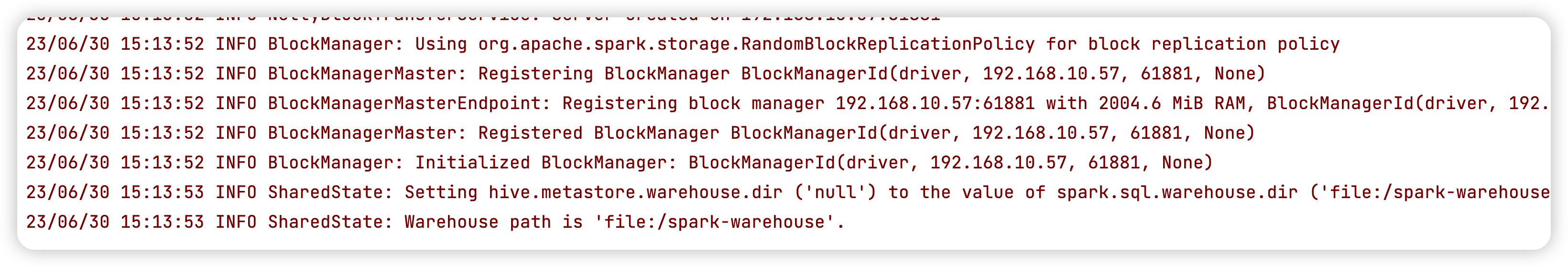

问题1:我这边运行 maxcompute spark 任务,如果使用了 sparksql 就会卡在这里,我使用的是官方 github 上面的案例 spark 3.1.1 ,大佬能帮忙看一下嘛? 使用的是 local 模式 问题2:

使用的是 local 模式 问题2: 还是卡在那里

还是卡在那里

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

使用MaxCompute Spark任务时遇到了问题,建议您检查以下几点:

确认您的代码是否正确。请检查代码中是否存在语法错误、逻辑错误、依赖库缺失等问题。

确认您的环境是否正确。请检查您使用的Spark版本、Python版本、MaxCompute SDK版本等是否符合要求。

检查日志。如果任务执行出现问题,可以查看Spark任务的日志,以了解任务执行的过程和出现问题的原因。您可以在MaxCompute控制台上查看日志,或者在本地运行任务时,查看任务输出的日志。

联系阿里云技术支持。如果您无法解决问题,可以联系阿里云技术支持,以获得更详细的帮助和支持。

当您在运行MaxCompute Spark任务时,使用Spark SQL出现卡顿的情况,可能是由于以下原因导致的:

资源限制:请确保您的MaxCompute集群有足够的资源供应,包括CPU、内存和存储等。如果资源不足,可能会导致Spark任务运行缓慢或卡顿。

数据量过大:如果您的数据量非常大,可能会导致Spark SQL查询操作耗费较长时间。建议您检查数据规模,并考虑是否可以通过数据分区、筛选或其他优化方式来提高查询性能。

数据倾斜:某些特定的数据分布情况可能导致数据倾斜,即部分数据分布不均匀,导致某些节点负载过重。这可能会导致Spark任务中一些阶段的执行速度变慢。考虑针对数据倾斜问题进行数据预处理或使用Spark SQL的优化技术(如动态分桶)来解决。

代码逻辑问题:请仔细检查您的Spark任务代码,确保没有逻辑错误、死循环或其他可能导致卡顿的问题。确认SQL语句、计算逻辑和数据操作是否正确无误。

版本兼容性:请确保您使用的Spark版本与MaxCompute兼容,并且根据MaxCompute文档推荐的方式正确配置和使用Spark。

如果您可以提供更详细的信息,例如具体的Spark任务代码、错误日志或其他相关的上下文信息,我将能够更准确地帮助您分析和解决问题。另外,也建议您咨询阿里云的技术支持团队,以获取针对您特定情况的专业支持

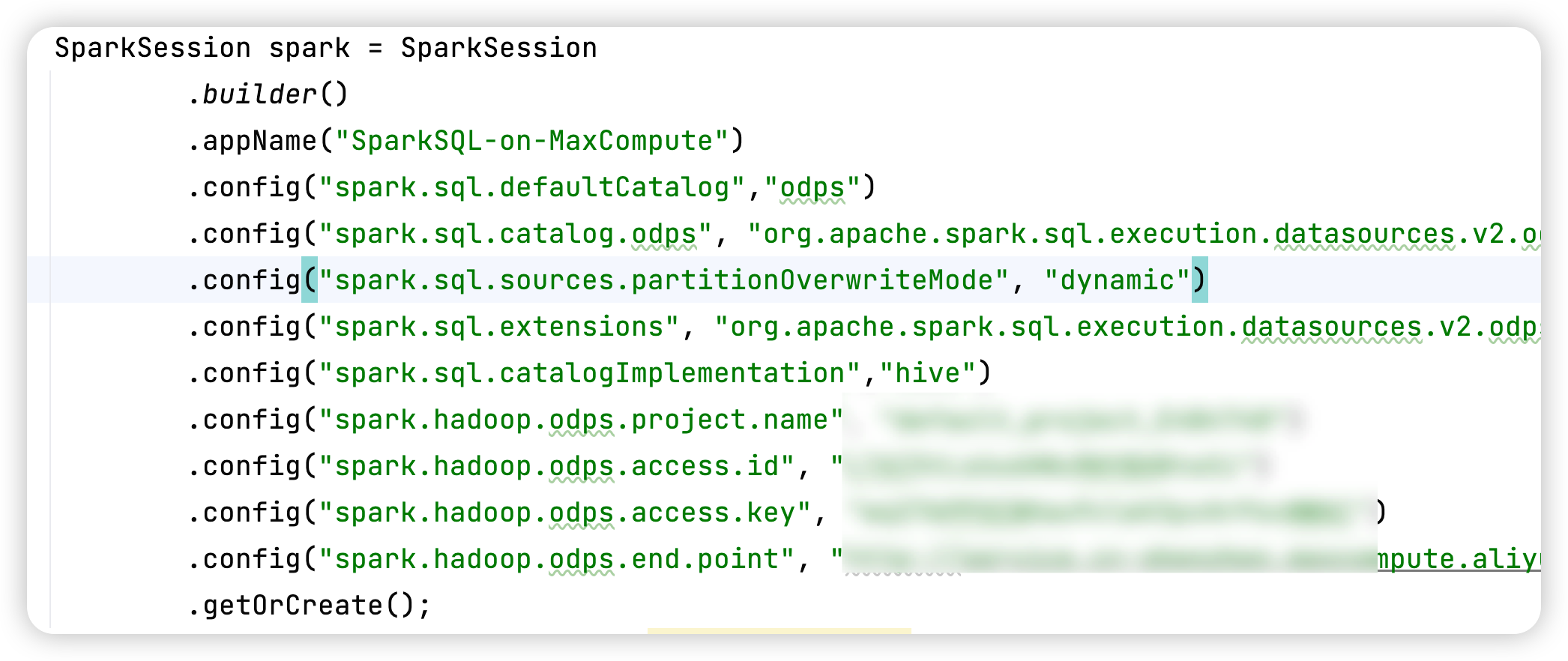

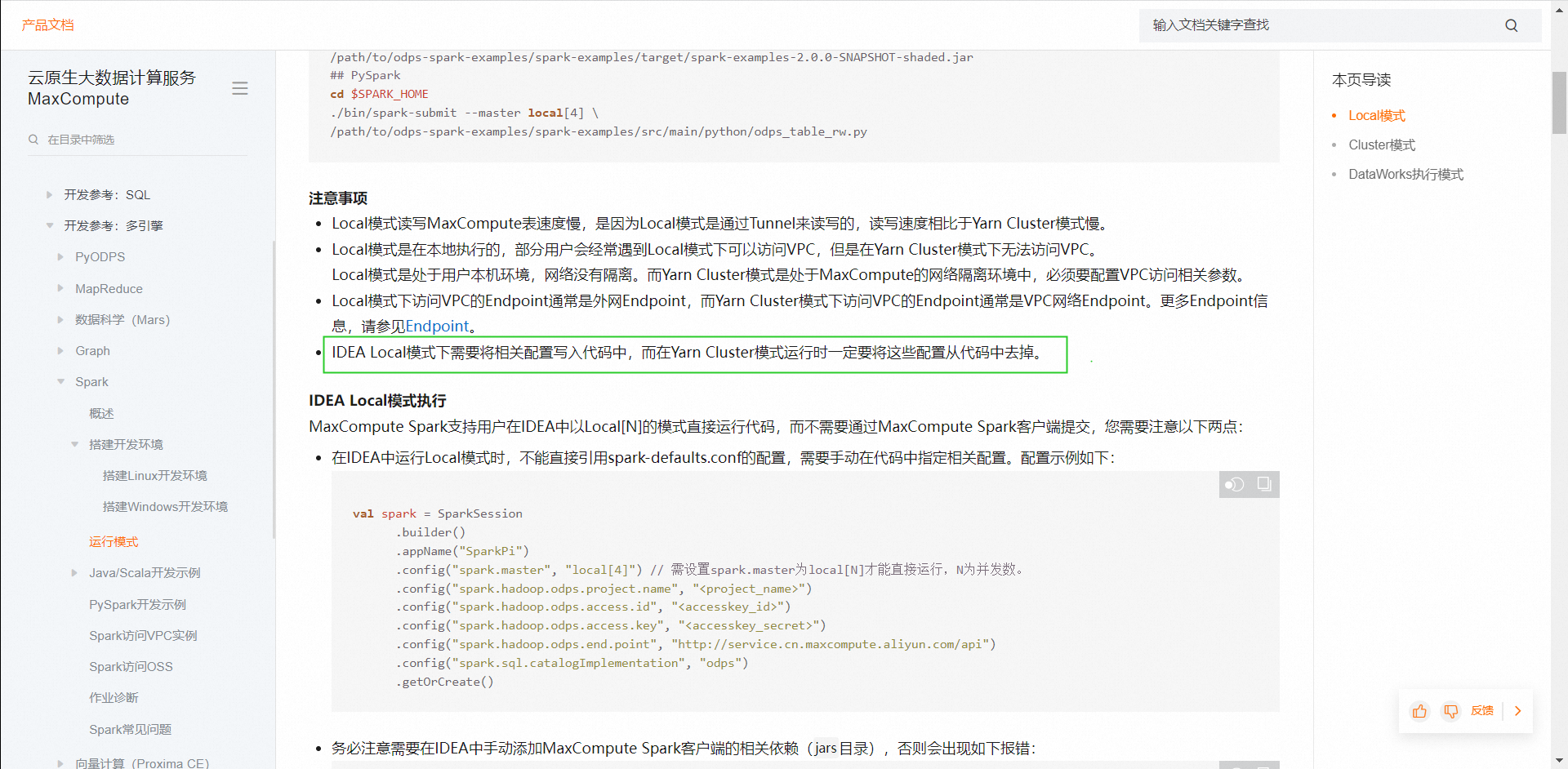

回答1: 你在代码里加上这些配置再操作一下呢,我理解还是哪里配置的问题,没连上 回答2:这里呢?核查了吗https://help.aliyun.com/document_detail/479426.html?spm=a2c4g.102430.0.0.f47414aaHeBouV#section-743-6xh-jit 如果一定要用local模式的话,看下用2.4.5版本呢?我这边也是一下,此回答整理自钉群“MaxCompute开发者社区1群”

你在代码里加上这些配置再操作一下呢,我理解还是哪里配置的问题,没连上 回答2:这里呢?核查了吗https://help.aliyun.com/document_detail/479426.html?spm=a2c4g.102430.0.0.f47414aaHeBouV#section-743-6xh-jit 如果一定要用local模式的话,看下用2.4.5版本呢?我这边也是一下,此回答整理自钉群“MaxCompute开发者社区1群”

MaxCompute(原ODPS)是一项面向分析的大数据计算服务,它以Serverless架构提供快速、全托管的在线数据仓库服务,消除传统数据平台在资源扩展性和弹性方面的限制,最小化用户运维投入,使您经济并高效的分析处理海量数据。