请问 flink-cdc 读oracle时,读chunks的task任务数是哪个参数设置 ?大佬帮忙看看  flink-cdc 读oracle时,增量读时报这个错误,大家有遇到过吗?

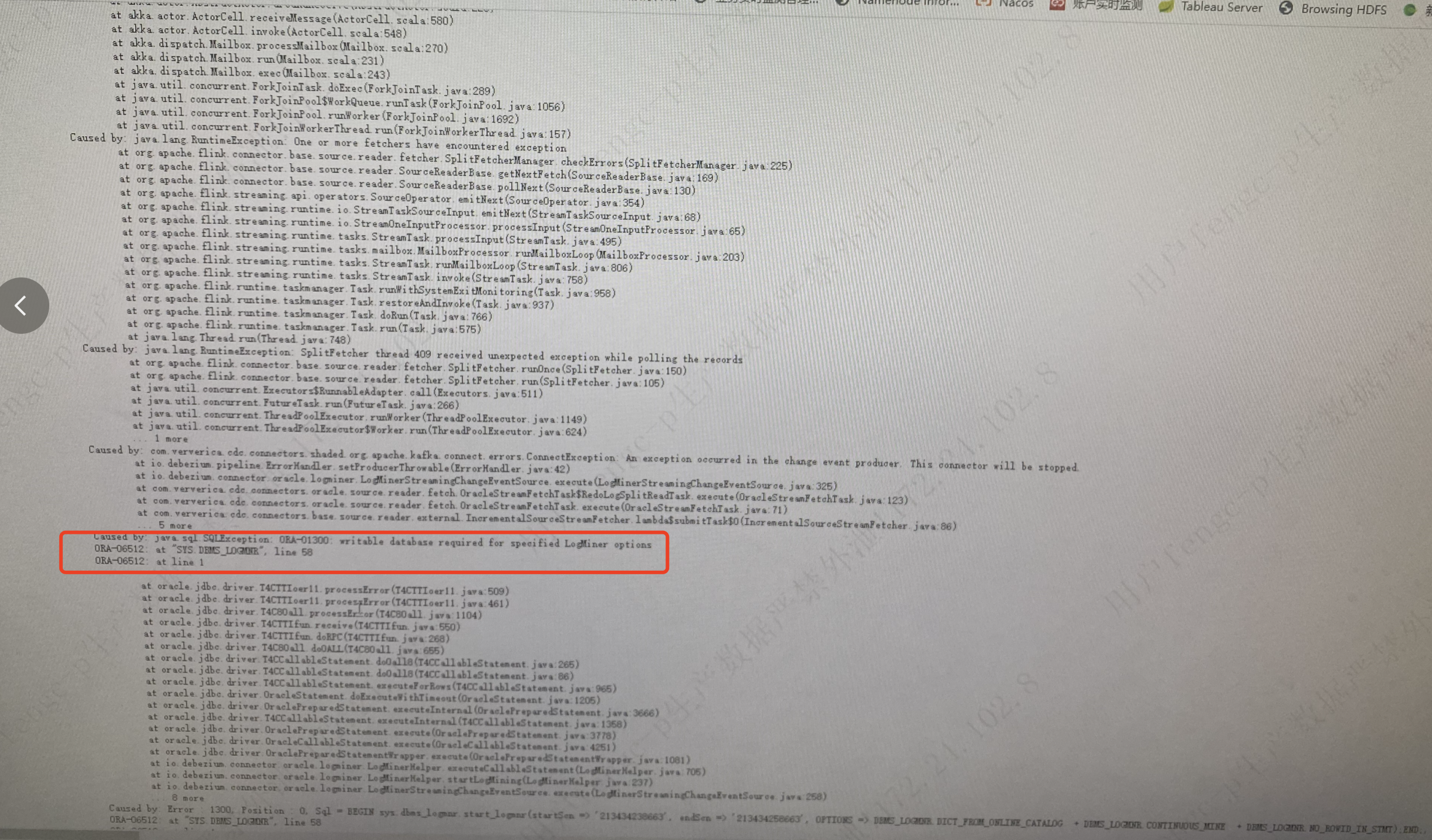

flink-cdc 读oracle时,增量读时报这个错误,大家有遇到过吗?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在Flink-CDC中,读取Oracle数据时,增量快照(Incremental Snapshot)机制会将表按照主键划分为多个分片(chunk),并逐个读取这些分片。控制读取分片的任务并发数主要与以下参数相关:

scan.incremental.snapshot.chunk.size

该参数定义了每个分片的大小(包含的行数)。通过调整分片大小,可以间接影响任务的并发度。如果分片较大,单个任务处理的数据量也会增加;反之,分片较小时,并发任务数可能增加。

parallelism.default 或 taskmanager.numberOfTaskSlots

Flink作业的并行度决定了读取分片的Task任务数。可以通过以下方式设置:

parallelism.default。-p <并行度>。taskmanager.numberOfTaskSlots),以支持更高的并发度。scan.incremental.snapshot.enabled

如果启用了增量快照(默认为true),则支持多并发读取分片。此时需要确保server-id参数设置为一个范围(如5400-5408),以便每个并发任务使用不同的MySQL客户端ID。

总结:

读取chunks的Task任务数主要由Flink作业的并行度决定,而分片大小(scan.incremental.snapshot.chunk.size)和增量快照的启用状态(scan.incremental.snapshot.enabled)会影响任务的分配和执行效率。

根据问题描述,您在使用Flink-CDC读取Oracle增量数据时遇到了错误。以下是可能导致问题的原因及解决方案:

execution.checkpointing.interval: 30s

scan.incremental.snapshot.chunk.size值来减少单个分片的数据量。taskmanager.memory.process.size: 4g

execution.checkpointing.tolerable-failed-checkpoints: 3

table.exec.sink.upsert-materialize参数,确保数据的物理化处理。例如:table.exec.sink.upsert-materialize: force

希望以上解答能帮助您解决问题!如果仍有疑问,请提供具体的错误日志以便进一步分析。