一、前置: 1.Flink 中支持的事件时间属性数据类型必须为 TIMESTAMP 或者 TIMESTAMP_LTZ 2.flinK sql代码里我也设置了时区tableEnv.getConfig().setLocalTimeZone(ZoneId.of("Asia/Shanghai")) 2.currTimestamp是13位时间错 二、然后会有以下问题: 1.其中使用TO_TIMESTAMP(FROM_UNIXTIME(currTimestamp / 1000, 'yyyy-MM-dd HH:mm:ss'))的字段设置为水位线,水位线会比实际数据的时间早8小时; 2.其中使用TO_TIMESTAMP_LTZ(currTimestamp,3)的字段设置为水位线,水位线和实际数据的时间是一致的 总结:我看flink官方说其中使用TO_TIMESTAMP和其中使用TO_TIMESTAMP_LTZ的时区通过由TableConfig指定, 我这里指定了,使用TO_TIMESTAMP函数转换数据时也会出现以上1这点问题。有那位大佬知道?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

当用处理时间转化为时间字段时,使用 TIMESTAMPADD 增加 8个小时。

1、source 端创表增加处理时间列

`proctime` as PROCTIME(),

2、 窗口函数改为使用处理时间

开窗函数使用处理时间

TUMBLE(`proctime`, INTERVAL '1' HOUR ),

3、使用处理时间转化为时间字段时,加 8个小时。

-- 时区加 8个小时

date_format_local(TIMESTAMPADD(HOUR, 8, cast(TUMBLE_START(`proctime`, INTERVAL '1' HOUR) as TIMESTAMP)),'yyyyMMddHHmmss') as `state_time`,

date_format_local(TIMESTAMPADD(HOUR, 8, cast(TUMBLE_START(`proctime`, INTERVAL '1' HOUR)as TIMESTAMP)) ,'yyyyMMddHHmmss') as `stat_time_start`,

date_format_local(TIMESTAMPADD(SECOND,-1, TIMESTAMPADD(HOUR, 8, cast(TUMBLE_END(`proctime`, INTERVAL '1' HOUR) as TIMESTAMP)) ),'yyyyMMddHHmmss') as `stat_time_end`,

——参考链接。

您好!关于您提出的问题:

在 Apache Flink 中,确实有两种方式来处理时间和日期相关的值:TO_TIMESTAMP 和 TO_TIMESTAMP_LTZ 函数。这两种函数的主要区别在于他们对待时区的不同方式。

正如您指出,TO_TIMESTAMP 函数不会自动考虑到时区差异,默认情况下它总是返回UTC时间戳,除非显式地传递了一个Timezone参数并进行了特殊的时区转换。

相比之下,TO_TIMESTAMP_LTZ 函数则始终考虑时区差异,因为它隐含地假定传入的时间是以本地时间为准。这意味着无论何时执行TO_TIMESTAMP_LTZ函数,都会自动应用用户的本地时区。

所以,如果您想避免因时区差异而导致的问题,特别是在处理带有时间戳的数据时,请尽量使用TO_TIMESTAMP_LTZ函数代替TO_timestamp函数。

至于您描述的第一个问题,“其中使用TO_TIME_STAMP(FROM_UNIXTIME(currTimestamp / 1000, 'yyyy-MM-dd HH:mm:ss'))”会导致水位线提前8个小时的现象,这是因为TO_TIMESTAMP函数忽略了时区信息,只保留了基本的Unix时间戳。在这种情况下,您需要明确告诉Flink哪个区域时区应当被视为“本地”,这样才能准确反映真实世界的时间。

总结起来,为了避免时区问题造成的困扰,在Apache Flink中应尽可能采用TO_TIMESTAMP_LTZ函数来处理时间戳数据,并确保正确设定TableConfig中的localTimeZone参数,使其反映出期望的目标时区。

是的,在 Apache Flink 中,支持的事件时间属性数据类型必须是 TIMESTAMP 或者 TIMESTAMP_LTZ。这两种数据类型都用于表示时间戳,但它们有一些区别。

TIMESTAMP 数据类型表示的时间戳是带有时区的,而 TIMESTAMP_LTZ 数据类型表示的时间戳是不带时区的。在事件时间处理中,通常需要使用 TIMESTAMP 或 TIMESTAMP_LTZ 数据类型来确保时间的准确性和一致性。

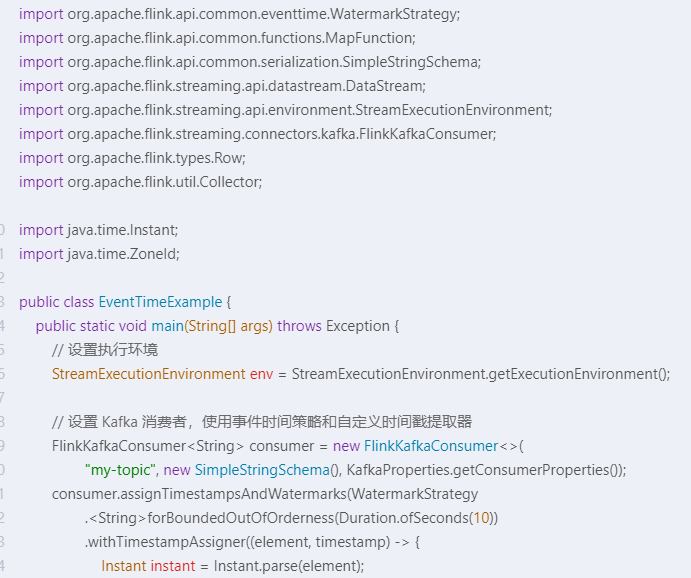

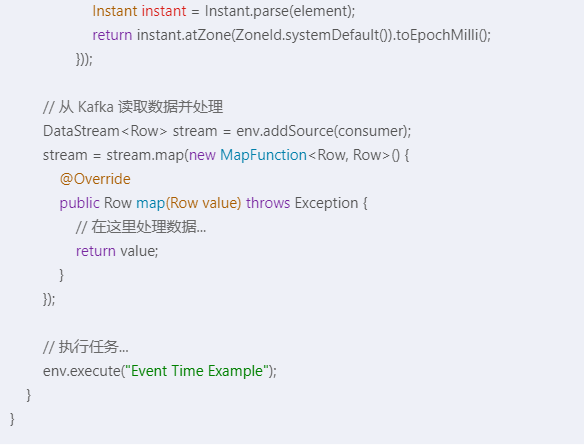

下面是一个使用 Flink 编写的示例代码,展示如何使用 TIMESTAMP 和 TIMESTAMP_LTZ 数据类型:

在上面的示例中,我们使用了 WatermarkStrategy 来定义事件时间策略,并使用 assignTimestampsAndWatermarks 方法将自定义的时间戳提取器应用于 Kafka 消费者。时间戳提取器将字符串元素解析为 Instant 对象,并将其转换为毫秒级的时间戳。这样,我们可以确保时间戳的准确性和一致性。

在 Apache Flink 中,事件时间相关的处理非常依赖于正确的时区设置和时间戳类型的处理。您提到的问题涉及到 TIMESTAMP 和 TIMESTAMP_LTZ 类型的不同以及如何正确地解析 Unix 时间戳。

TO_TIMESTAMP(FROM_UNIXTIME(currTimestamp / 1000, 'yyyy-MM-dd HH:mm:ss'))

currTimestamp 是毫秒级 Unix 时间戳。FROM_UNIXTIME() 函数将其转换为日期字符串,默认情况下,Flink SQL 中这个函数可能会使用系统的默认时区,而不是您通过 tableEnv.getConfig().setLocalTimeZone(ZoneId.of("Asia/Shanghai")) 设置的时区。TO_TIMESTAMP() 将该日期字符串转换成 TIMESTAMP 类型,这个转换过程中如果没有明确指定时区,仍然可能是基于系统默认时区而非上海时区进行的,所以可能导致您观察到的时间早了8小时。TO_TIMESTAMP_LTZ(currTimestamp, 3)

TIMESTAMP_LTZ 类型代表的是带有时区信息的本地时间戳(Local Timestamp with Time Zone)。TO_TIMESTAMP_LTZ(currTimestamp, 3) 转换时,它会假设传入的时间戳已经是 UTC 时间,并加上您之前设置的上海时区偏移量(+08:00),因此转换后的时间点与实际数据的时间一致。综上所述,如果您希望 TO_TIMESTAMP() 在转换 Unix 时间戳时也应用上海时区,可能需要明确指定时区,比如:

TO_TIMESTAMP(FROM_UNIXTIME(currTimestamp / 1000, 'yyyy-MM-dd HH:mm:ss', 'Asia/Shanghai'))

Flink SQL 是否支持在 FROM_UNIXTIME() 函数中直接传递时区参数需要查阅具体的文档或源码确认,因为在某些版本中可能不支持这样做。若不支持,您可能需要先将毫秒级 Unix 时间戳转换为 UTC 格式的时间戳字符串,再转换为 TIMESTAMP 类型,并确保整个流程中所有环节均使用相同的时区设置。

在使用Flink处理数据时遇到了时区问题。您提到了两种转换方法:TO_TIMESTAMP和TO_TIMESTAMP_LTZ。下面分别对这两种方法进行解释:

tableEnv.getConfig().setLocalTimeZone(ZoneId.of("Asia/Shanghai"));

CopyCopy

使用MySQL CDC,增量阶段读取出来的timestamp字段时区相差8小时,怎么回事呢?https://help.aliyun.com/zh/flink/support/faq-about-cdc?spm=a2c4g.11186623.0.i41#2a719e953e1ky

在解析Binlog数据中的timestamp字段时,CDC作业里配置server-time-zone参数,如果这个参数没有和您的MySQL服务器时区一致,就会出现这个问题。

在DataStream中使用了自定义序列化器,例如MyDeserializer implements DebeziumDeserializationSchema。当自定义序列化器解析timestamp类型的数据时,出现该问题。可以参考RowDataDebeziumDeserializeSchema中对timestamp类型的解析,在serverTimeZone处给定时区信息。

private TimestampData convertToTimestamp(Object dbzObj, Schema schema) {

if (dbzObj instanceof Long) {

switch (schema.name()) {

case Timestamp.SCHEMA_NAME:

return TimestampData.fromEpochMillis((Long) dbzObj);

case MicroTimestamp.SCHEMA_NAME:

long micro = (long) dbzObj;

return TimestampData.fromEpochMillis(micro / 1000, (int) (micro % 1000 * 1000));

case NanoTimestamp.SCHEMA_NAME:

long nano = (long) dbzObj;

return TimestampData.fromEpochMillis(nano / 1000_000, (int) (nano % 1000_000));

}

}

LocalDateTime localDateTime = TemporalConversions.toLocalDateTime(dbzObj, serverTimeZone);

return TimestampData.fromLocalDateTime(localDateTime);

}

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。