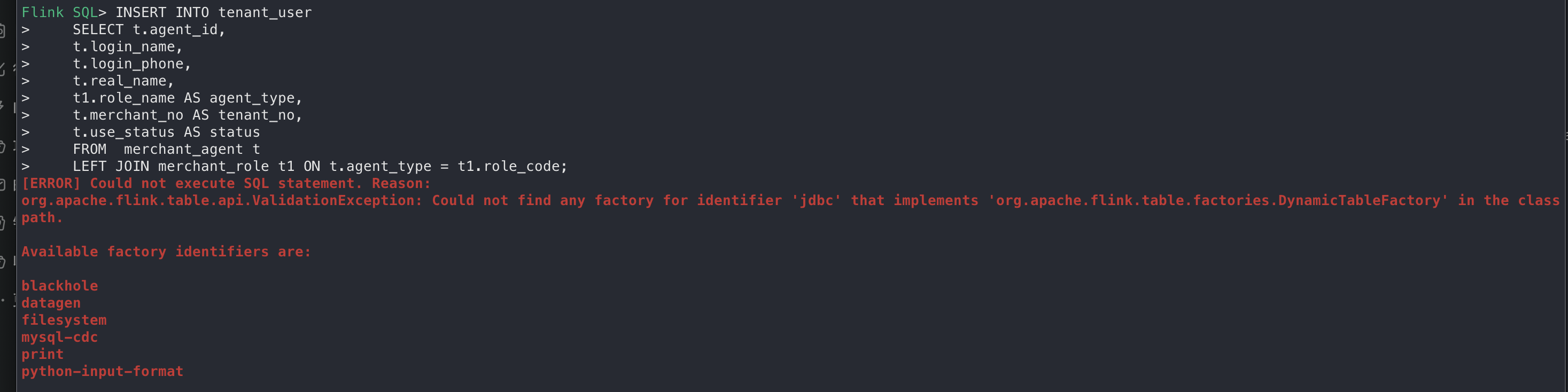

各位大佬,Flink中这个是啥情况,jar包都放到lib下面,还是出这个问题?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

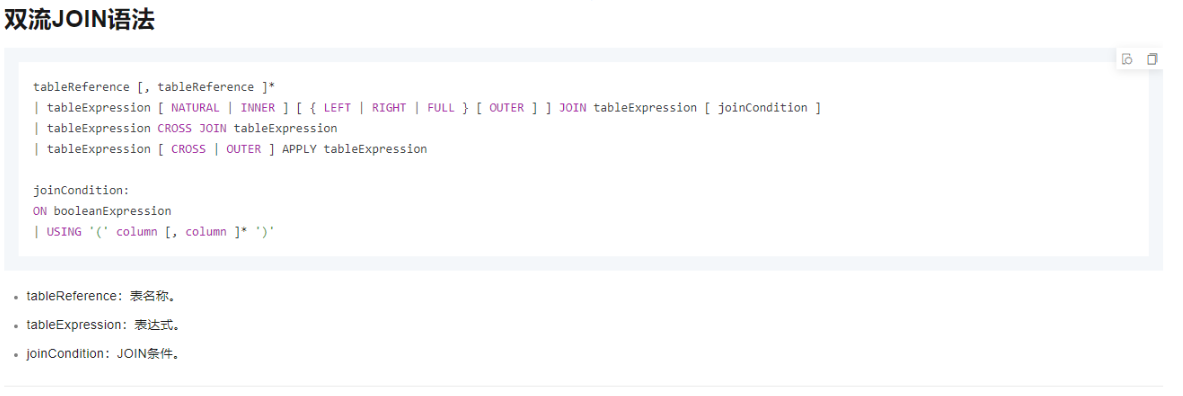

实时计算的JOIN和传统批处理JOIN的语义一致,都用于将两张表关联起来。区别为实时计算关联的是两张动态表,关联的结果也会动态更新,以保证最终结果和批处理结果一致。

https://help.aliyun.com/zh/flink/developer-reference/dual-stream-join-statements?spm=a2c6h.13066369.question.11.74094aeeVnz7JW

根据提供的信息,你在尝试使用jdbc连接数据库时遇到问题。你的SQL语句无法成功执行,因为找不到实现org.apache.flink.table.factories.DynamicTableFactory接口的工厂类用于识别jdbc标识符。

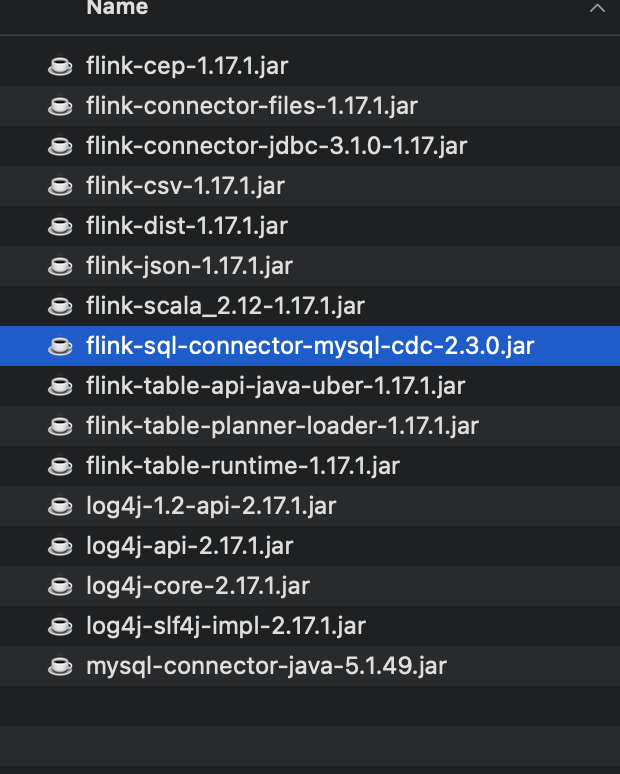

解决方法可能是检查是否安装了正确的JDBC驱动程序库(JAR文件),并将它们放在Flink的lib目录下。此外,还需要确认Flink版本与使用的JDBC驱动兼容性。

如果你还没有这样做,请确保满足以下几个条件:

您已经在项目结构中的lib目录下放置了对应的JDBC驱动JAR文件。

JDBC驱动JAR文件的位置已经被Flink发现并加载。

JDBC驱动JAR文件适用于正在运行的Flink版本。

SQL查询语法无误。

若上述步骤不能解决问题或不确定如何完成某项操作,请提供更多详细信息以帮助我们更好地诊断问题。例如,你正在使用的数据库类型及其相关依赖关系,还有Flink的具体版本号等等。

根据你提供的截图内容,出现了一个名为org.apache.flink.table.api.ValidationException异常,提示找不到标识符为'jdbc'的工厂类实现了org.apache.flink.table.factories.DynamicTableFactory接口。这是因为在你的项目中没有找到支持JDBC的依赖项。

要解决这个问题,你需要添加Apache Flink JDBC依赖项到项目的pom.xml文件中。你可以参考以下Maven坐标:

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-jdbc_2.12</artifactId>

<version>${flink.version}</version>

</dependency>

其中${flink.version}应该替换为你正在使用的Flink版本号。这样,你应该能够运行SQL语句而不报错。如果你已经在pom.xml中包含了该依赖项但仍出现问题,则可能是缓存或其他构建问题导致的。在这种情况下,重新编译项目或者清理项目后再试一次。若问题依然存在,你也可以尝试更新Flink及其所有依赖库至最新稳定版。

这个错误是由于 Flink 无法找到合适的 DynamicTableFactory 来创建表。根据提供的错误信息,Flink 集群中可用的工厂标识符包括:blackhole、datagen、filesyster、nysql-cdc、rint、vthon-input-forma。

要解决这个问题,请检查以下几点:

factory.scan.packages=com.example.myflinkpackage

CopyCopy

import org.apache.flink.table.api.EnvironmentSettings;

import org.apache.flink.table.api.TableEnvironment;

CopyCopy

EnvironmentSettings settings = EnvironmentSettings.newInstance().useBlinkPlanner().inBatchMode().build();

TableEnvironment tableEnv = settings.newTableEnvironment(executionEnvironment);

// 注册自定义的 DynamicTableFactory

tableEnv.registerFunction("myDynamicTableFactory", new MyDynamicTableFactory());

CopyCopy

这是由于Flink在执行SQL语句时,无法找到合适的表工厂来处理JOIN操作。

Flink SQL支持对动态表进行复杂而灵活的连接操作,本文为您介绍如何使用双流JOIN语句。https://help.aliyun.com/zh/flink/developer-reference/dual-stream-join-statements?spm=a2c4g.11186623.0.i35

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。