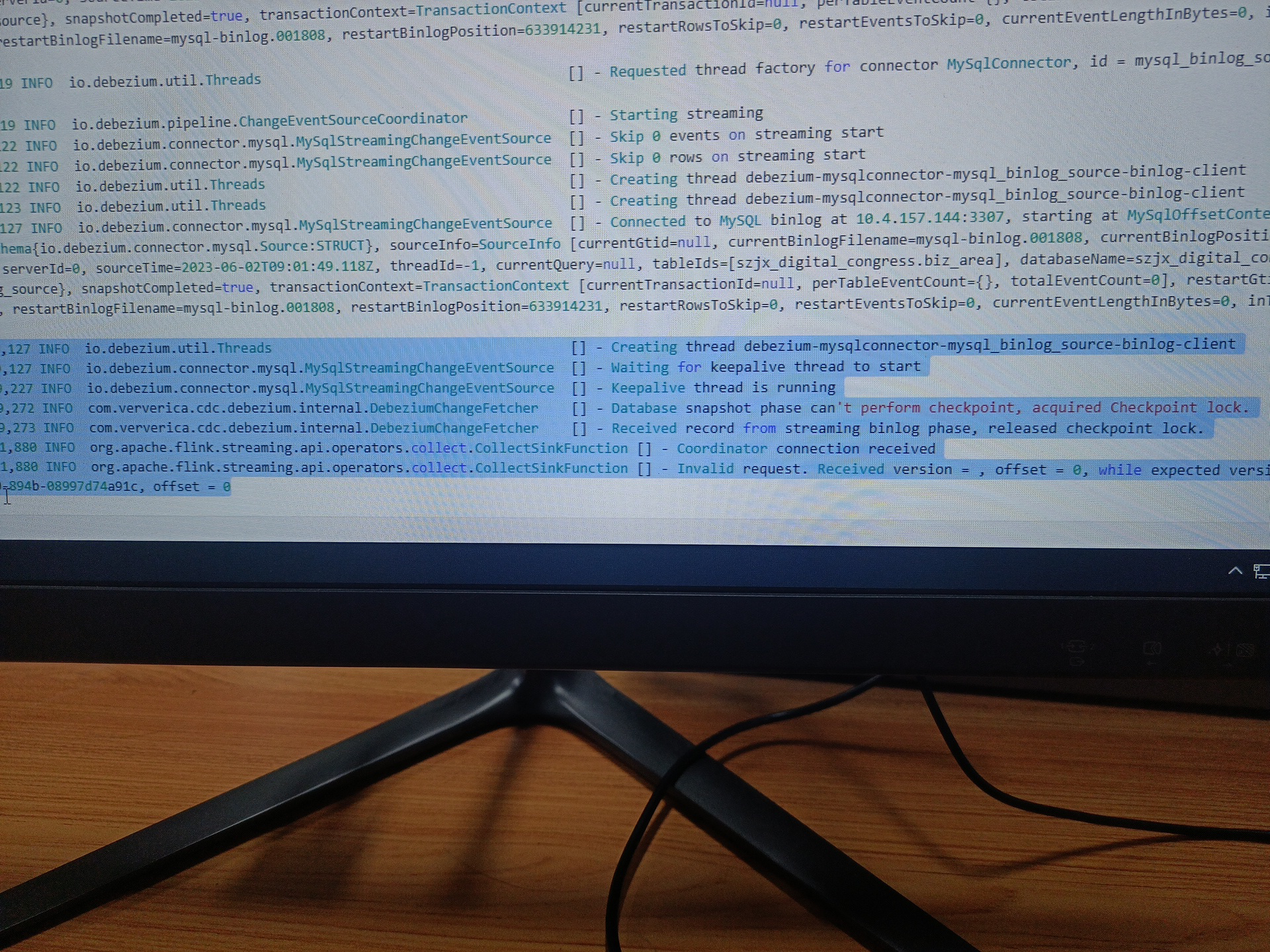

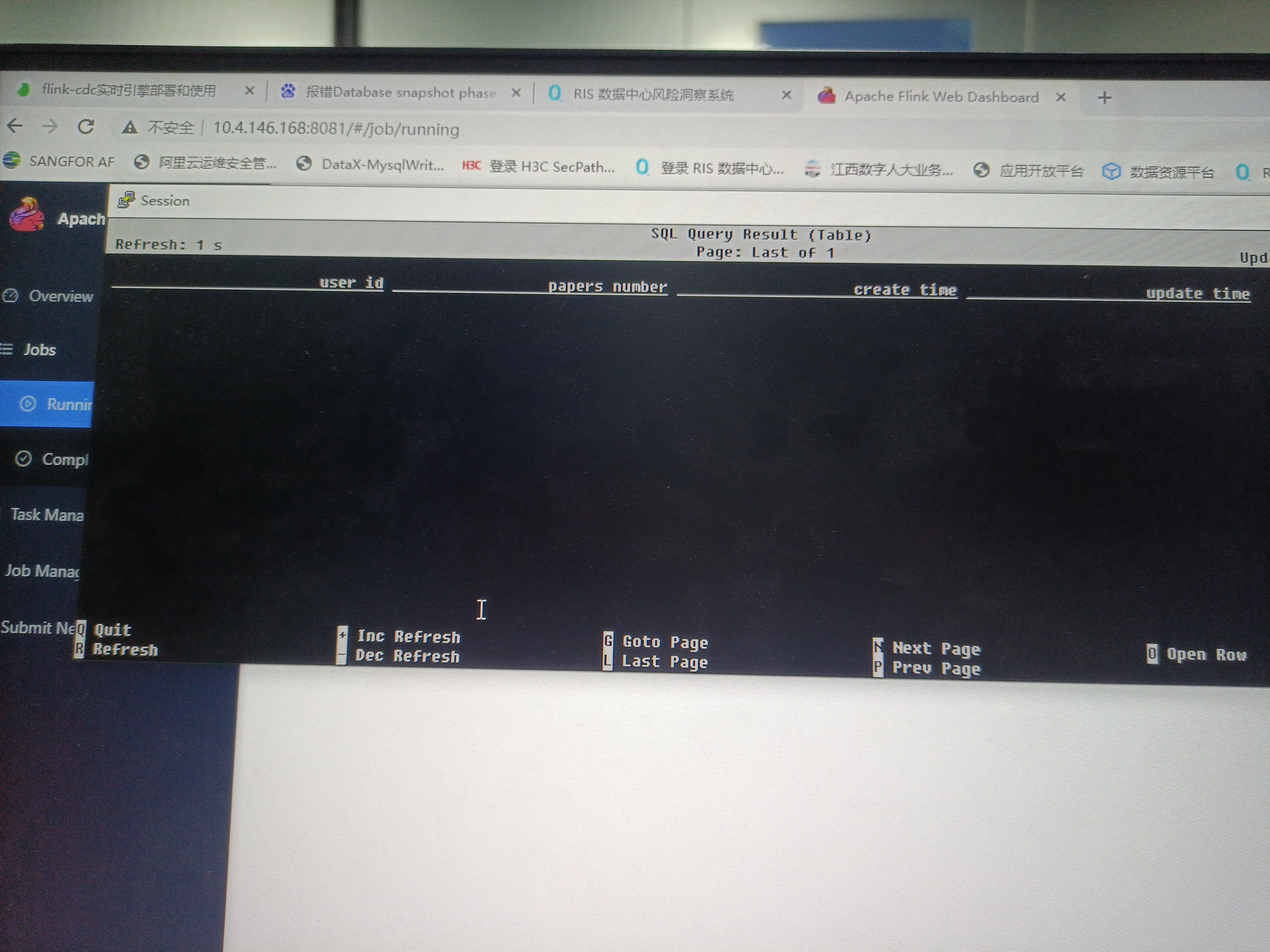

大佬,Flink CDC中报这个错了。是啥意思啊?我服务起来了,但是select.没数据

直接select *from table

直接select *from table

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

根据您描述的问题“Flink CDC中报错,服务起来了,但是select * from table没有数据”,结合知识库中的参考资料,以下是可能的原因分析和解决方案:

在Flink CDC全量阶段,如果MySQL源表发生了表结构变更(如新增列、修改列类型等),可能会导致作业报错或无法同步数据。这种情况下,下游表可能为空。

Flink CDC依赖MySQL的Binlog来捕获增量数据。如果Binlog文件被清理或不可用,可能导致数据无法同步。

报错:The connector is trying to read binlog starting at GTIDs ..., but this is no longer available on the server。

mysql> show variables like 'expire_logs_days';

mysql> set global expire_logs_days=7;

报错:Encountered change event for table xxx.xxx whose schema isn't known to this connector。

debezium.snapshot.mode)或数据库权限不足。'debezium.snapshot.mode'='never',建议改为默认值initial。DEFAULT (now())),并调整表结构。如果在Flink SQL中使用了WHERE条件过滤数据,可能导致查询结果为空。

SELECT * FROM table是否返回数据。如果没有数据,说明问题出在CDC源表。WHERE条件后无数据,说明过滤条件过于严格。UPDATE或DELETE操作,确认用户是否具有DELETE权限,因为UPDATE_BEFORE会被识别为DELETE操作。Flink CDC分为全量阶段和增量阶段。如果全量阶段尚未完成,增量阶段的数据可能还未开始同步。

server-id范围以支持更高的并发度。例如:

SELECT ...

FROM `<mysqlcatalog>`.`<dbname>`.`<tablename>` /*+ OPTIONS('server-id' = '6000-6008') */;

注意:server-id范围中的个数需大于等于并发度。

如果下游表未正确写入数据,可能是由于目标表的Catalog不支持CTAS(Create Table As Select)操作。

CREATE TABLE ... AS TABLE ... statement requires target catalog ... implements org.apache.flink.table.catalog.CatalogTableProvider interface。

虽然您提到Flink和Kafka之间的网络是连通的,但如果Endpoint信息不正确,仍可能导致数据无法读取。

zkCli.sh

ls /brokers/ids

get /brokers/ids/{your_broker_id}

server-id范围和Binlog保留时间。如果以上方法仍无法解决问题,请提供具体的报错日志,以便进一步分析。