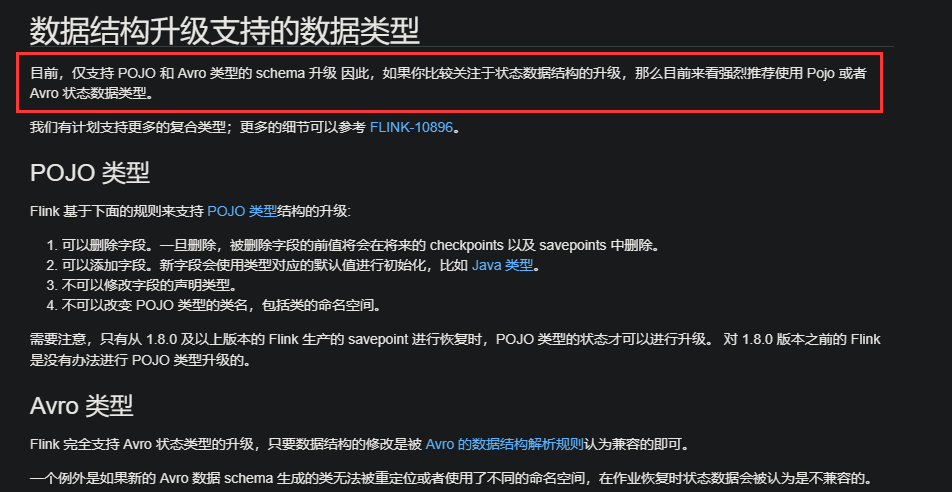

Flink CDC中我看官方文档写的是只支持pojo和avro类型,那我应该怎么修改序列化类型,我使用的是sql-client提交的sql,我在官方文档没找到怎么设置?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在Flink CDC中,默认情况下,SQL Client提交的SQL作业确实主要支持POJO和Avro类型的序列化。如果您需要修改序列化类型以满足特定需求,可以通过以下方式进行配置和调整:

Flink允许通过注册自定义序列化器来支持其他数据类型。您可以在SQL作业中通过WITH参数指定序列化格式,并结合DataStream API实现更灵活的序列化逻辑。

WITH子句为表指定序列化格式。例如,如果您希望使用JSON格式进行序列化,可以设置如下参数:

CREATE TABLE your_table (

id BIGINT,

name STRING,

...

) WITH (

'connector' = 'kafka',

'format' = 'json', -- 指定序列化格式为JSON

'properties.bootstrap.servers' = 'your_kafka_broker',

...

);

如果您的数据适合使用Avro格式,可以通过以下方式启用Avro序列化: - 在WITH参数中指定format为avro,并配置相关选项:

CREATE TABLE your_table (

id BIGINT,

name STRING,

...

) WITH (

'connector' = 'kafka',

'format' = 'avro', -- 使用Avro格式

'avro.codec' = 'snappy', -- 可选:指定压缩编解码器

'properties.bootstrap.servers' = 'your_kafka_broker',

...

);

如果您正在处理CDC数据流(如MySQL CDC),可以使用Debezium JSON格式进行序列化和反序列化。具体配置如下: - 在WITH参数中指定format为debezium-json,并根据需要启用schema支持:

CREATE TABLE your_cdc_table (

id BIGINT,

name STRING,

...

) WITH (

'connector' = 'kafka',

'format' = 'debezium-json', -- 使用Debezium JSON格式

'debezium-json.schema-include' = 'true', -- 可选:是否包含schema信息

'properties.bootstrap.servers' = 'your_kafka_broker',

...

);

如果您的数据类型无法直接映射到POJO或Avro,可以通过注册自定义类型提示来手动创建序列化规则。例如: - 在SQL作业中使用TYPE HINT语法为字段指定类型:

CREATE TABLE your_table (

id BIGINT,

custom_field AS RAW('com.example.CustomType') -- 自定义类型提示

) WITH (

'connector' = 'kafka',

'format' = 'raw', -- 使用RAW格式

'properties.bootstrap.servers' = 'your_kafka_broker',

...

);

通过上述方法,您可以根据实际需求修改Flink CDC中的序列化类型。推荐优先使用Avro或Debezium JSON格式,因为它们在CDC场景下具有更好的兼容性和性能表现。如果需要进一步定制,可以通过DataStream API实现自定义序列化逻辑,并与SQL作业集成。