请问使用Flink CDC获取Oracle的数据报这个错有遇到过吗 全量同步没有问题,增量就报错

全量同步没有问题,增量就报错

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

根据您描述的问题,使用Flink CDC获取Oracle数据时,全量同步没有问题,但在增量同步阶段报错。以下是可能的原因分析及解决方案:

在增量同步阶段,Flink CDC依赖Oracle的LogMiner工具来解析日志文件。如果LogMiner配置或权限存在问题,可能导致增量同步失败。

原因 1:Oracle LogMiner不支持在PDB(Pluggable Database)上执行。

debezium.database.pdb.name参数。原因 2:表名长度超过30个字符。

原因 3:权限不足。

GRANT SELECT ANY TRANSACTION TO <username>;

GRANT LOGMINING TO <username>;

GRANT SELECT ON V$LOGMNR_CONTENTS TO <username>;

同时,检查当前用户的权限是否正确配置。

在全量同步完成后,如果Oracle表结构发生了变更(如新增列、修改列类型等),可能会导致增量同步失败。

如果增量阶段读取的timestamp字段存在时区差异,可能是由于CDC作业中未正确配置server-time-zone参数。

server-time-zone参数与Oracle服务器的时区不一致。

server-time-zone参数为与Oracle服务器一致的时区。例如:server-time-zone=Asia/Shanghai

确保该参数与Oracle服务器的实际时区匹配。

在从全量切换到增量的过程中,Flink CDC需要等待一个Checkpoint完成,以确保全量数据已写入下游后再开始增量同步。如果Checkpoint间隔时间过长,可能导致增量同步延迟或失败。

execution.checkpointing.interval=10s

这样可以加快全量到增量的切换过程。

不同版本的Oracle CDC可能存在Bug或功能限制,影响增量同步的正常运行。

如果Oracle数据库配置了Binlog过滤器,可能会忽略某些表的变更日志,导致增量同步失败。

SHOW PARAMETER LOG_ARCHIVE_DEST;

如果发现目标表被忽略,请调整过滤器配置。

问题:增量阶段读取到的数据不完整或丢失。

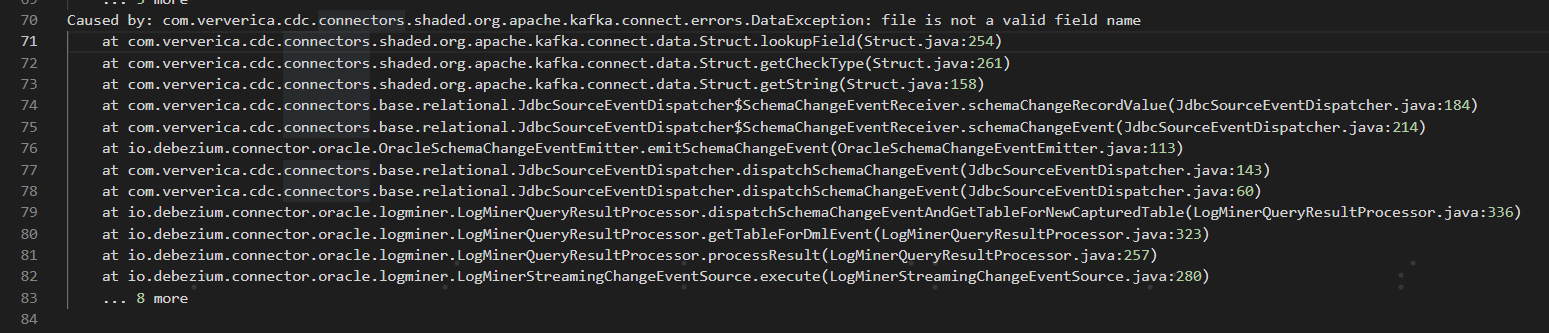

问题:增量阶段出现DataException: file不是有效的字段名。

根据上述分析,您可以按照以下步骤排查和解决问题: 1. 检查Oracle LogMiner配置和权限,确保支持增量同步。 2. 确认表结构未发生不兼容的变更,必要时重启作业。 3. 校验server-time-zone参数是否与Oracle服务器时区一致。 4. 调整Checkpoint间隔时间,避免切换延迟。 5. 升级Oracle CDC版本,修复已知问题。 6. 检查Binlog过滤器配置,确保目标表的变更日志未被忽略。

如果问题仍未解决,请提供更多具体的错误日志信息,以便进一步分析和定位问题。您可以复制页面截图提供更多信息,我可以进一步帮您分析问题原因。