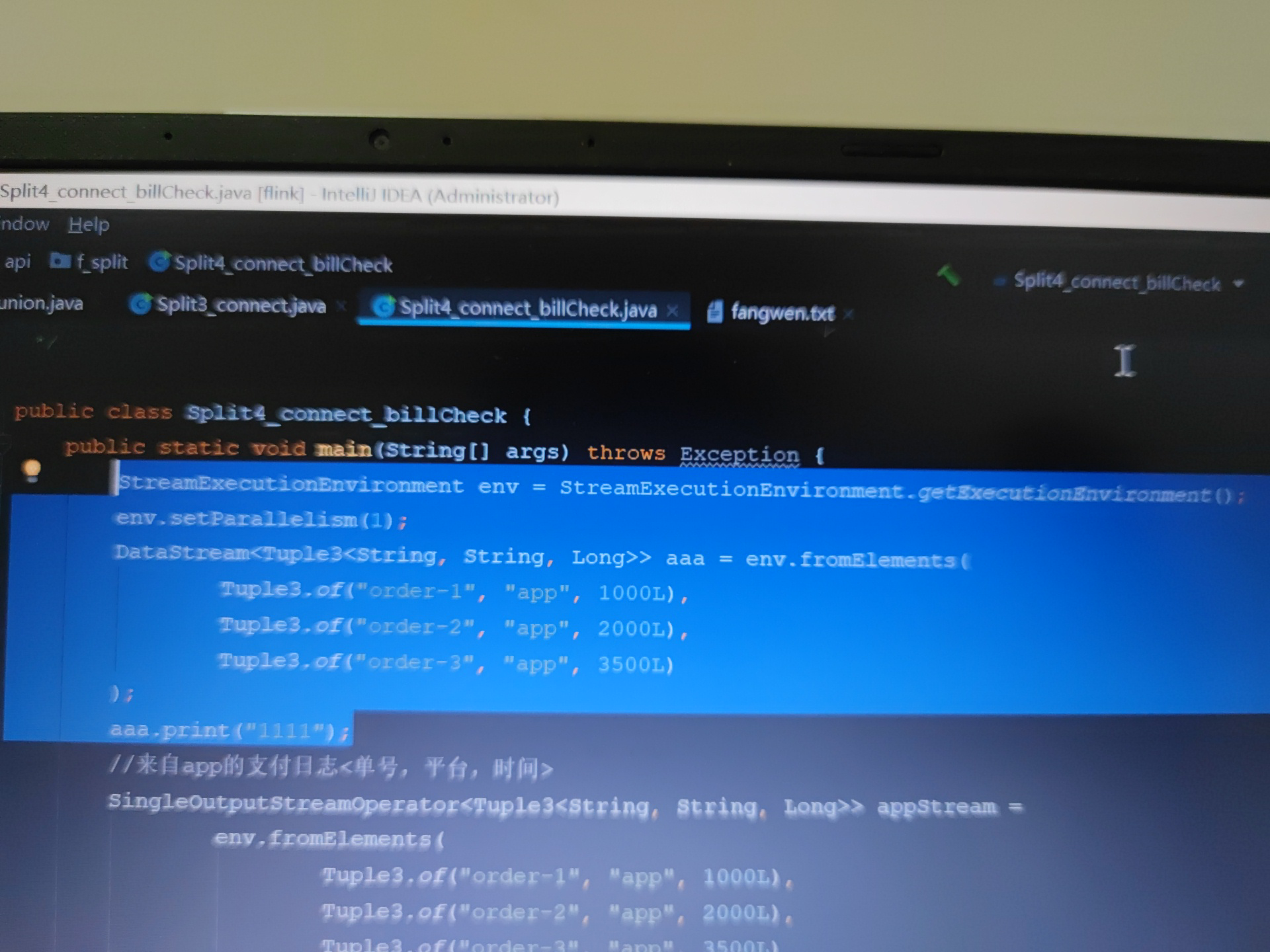

Flink中运行选中这部分代码,打印不出东西,有大佬知道原因吗,好奇怪啊?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在Apache Flink中,如果你的代码执行后没有打印出任何东西,这可能有几个原因。这里有几个常见的问题及解决办法:

日志级别设置:检查你的Flink作业的日志级别是否被设置为了一个较低的级别(如ERROR),这样只有错误信息会被打印出来,而INFO或DEBUG级别的日志则不会显示。你可以通过配置文件调整日志级别。

输出 sink 未正确配置:确保你的数据流最终被连接到了一个正确的输出sink。比如,你可能忘记将数据流连接到print()函数或者一个文件/消息队列等外部存储的sink上。

代码逻辑问题:确认你的代码逻辑中确实有数据流经那些应该产生打印输出的部分。有时候,由于过滤条件、窗口操作或其他转换操作的原因,数据流可能提前被截断或为空。

并行度问题:如果并行度大于1,且使用了非确定性的操作(例如未指定key的print()),输出可能会分散在不同的taskmanager上,导致你在单个地方看不到所有输出。可以尝试临时将并行度设为1来验证这个问题。

运行时环境问题:确认你的Flink集群是正常运行的,没有资源不足或任务管理器失败的情况。

查看Web UI:Flink提供了一个Web UI,通常在localhost:8081(或集群配置的地址)上,可以查看作业的状态、监控数据流以及跟踪错误信息,这对于诊断问题非常有帮助。

异常处理:检查是否有未被捕获的异常中断了程序的执行。Flink的执行过程中如果有异常,它通常会记录在日志中而不是直接在控制台打印。

如果以上建议都不能解决问题,建议详细检查你的代码,并在关键位置添加日志输出,以便更好地理解数据流经过的路径和状态。同时,查看Flink的日志文件,通常位于$FLINK_HOME/log/目录下,以获取更详细的错误信息。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。