老板们,遇到过Flink CDC 这个问题吗。不回收 mysql cdc的,几分钟干满6G内存。

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

根据您描述的问题“Flink CDC 不回收 MySQL CDC 的内存,几分钟内占用 6G 内存”,这可能是由于 Flink CDC 在全量阶段或增量阶段的内存管理不当导致的。以下是可能的原因分析及解决方案:

在 MySQL CDC 的全量阶段,Flink 使用增量快照算法将表按照主键分成多个分片(chunk),并逐个读取每个分片的数据。如果某个分片的数据量过大,可能会导致 TaskManager 内存不足,出现 OOM(Out of Memory)问题。

调整分片大小

减少 scan.incremental.snapshot.chunk.size 参数值,以减少每个分片的数据条数。例如:

scan.incremental.snapshot.chunk.size = 5000

默认值为 8096,您可以根据实际数据分布情况适当降低该值。

增加 TaskManager 堆内存

如果无法通过调整分片大小解决问题,可以尝试增加 TaskManager 的堆内存。在 Flink 配置中调整以下参数:

taskmanager.memory.process.size = 8g

指定分片字段

对于联合主键的表,默认使用主键中的第一个字段进行分片。如果该字段的值分布不均匀,可能导致某些分片数据量过大。可以通过 scan.incremental.snapshot.chunk.key-column 指定一个分布更均匀的字段作为分片依据。例如:

scan.incremental.snapshot.chunk.key-column = id

在 VVR 8.0.8 及之前的版本中,最后一个分片需要读取的数据量可能较大,容易导致 TaskManager 出现 OOM。

在增量阶段,MySQL CDC 会读取整个实例级别的 Binlog 文件。即使您的作业只涉及部分表,Binlog 中仍然包含所有表的变更记录。这种情况下,Flink CDC 需要在连接器层面过滤出目标表的变更数据,这可能会导致带宽和内存消耗较高。

启用 CDC Source 复用

如果同一个作业中有多个 MySQL CDC 源表,并且这些源表都来自同一个 MySQL 实例,建议启用 CDC Source 复用功能。这样可以减少 Binlog Client 的数量,从而降低内存和带宽的消耗。

优化 Binlog 过滤规则

确保 MySQL 的 Binlog 配置中启用了 binlog-do-db 或 binlog-ignore-db,以减少不必要的数据库变更记录写入 Binlog。

Flink CDC 在全量阶段和增量阶段都会周期性执行 Checkpoint,用于记录分片进度和 Binlog 位点。如果 Checkpoint 配置不合理,可能会导致内存占用过高。

调整 Checkpoint 间隔时间

合理设置 Checkpoint 的间隔时间,避免过于频繁的 Checkpoint 导致内存压力。例如:

execution.checkpointing.interval = 60s

启用增量 Checkpoint

如果您的状态后端支持增量 Checkpoint(如 RocksDB),建议启用该功能以减少内存占用:

state.backend.incremental = true

如果 MySQL 表的主键分布不均匀,可能导致某些分片的数据量远大于其他分片,从而引发内存问题。

scan.incremental.snapshot.chunk.key-column 指定一个分布更均匀的字段作为分片依据。不同版本的 Flink 引擎可能存在内存管理或性能优化上的差异。如果当前使用的引擎版本较旧,可能会导致内存管理问题。

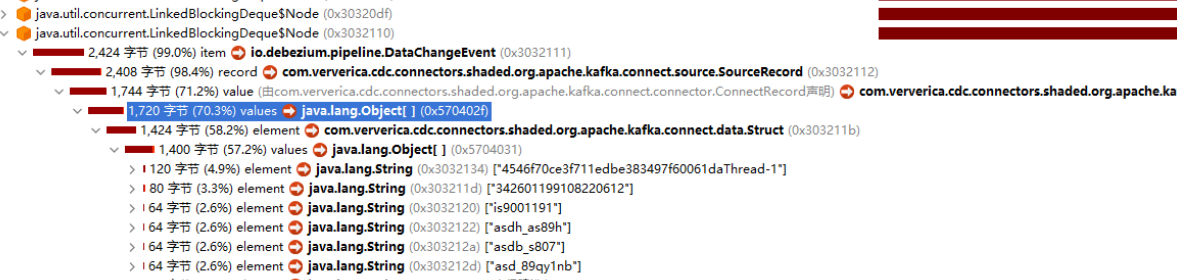

为了进一步定位问题,建议启用 Flink 的监控功能,查看 TaskManager 的内存使用情况和 GC 日志。

启用 Flink Web UI

通过 Flink Web UI 查看 TaskManager 的内存使用情况。

检查 GC 日志

在 Flink 配置中启用 GC 日志,分析是否存在频繁的 Full GC:

env.java.opts: "-XX:+PrintGCDetails -Xloggc:/path/to/gc.log"

针对您描述的问题,建议从以下几个方面入手解决: 1. 调整分片大小和指定分片字段,优化全量阶段的内存使用。 2. 升级 Flink 引擎版本,避免已知的内存管理问题。 3. 启用 CDC Source 复用功能,减少 Binlog Client 的数量。 4. 合理配置 Checkpoint 和状态后端,降低内存压力。 5. 检查主键分布,避免数据倾斜问题。

如果问题仍未解决,请提供更多的上下文信息(如 Flink 配置、MySQL 表结构、GC 日志等),以便进一步分析。