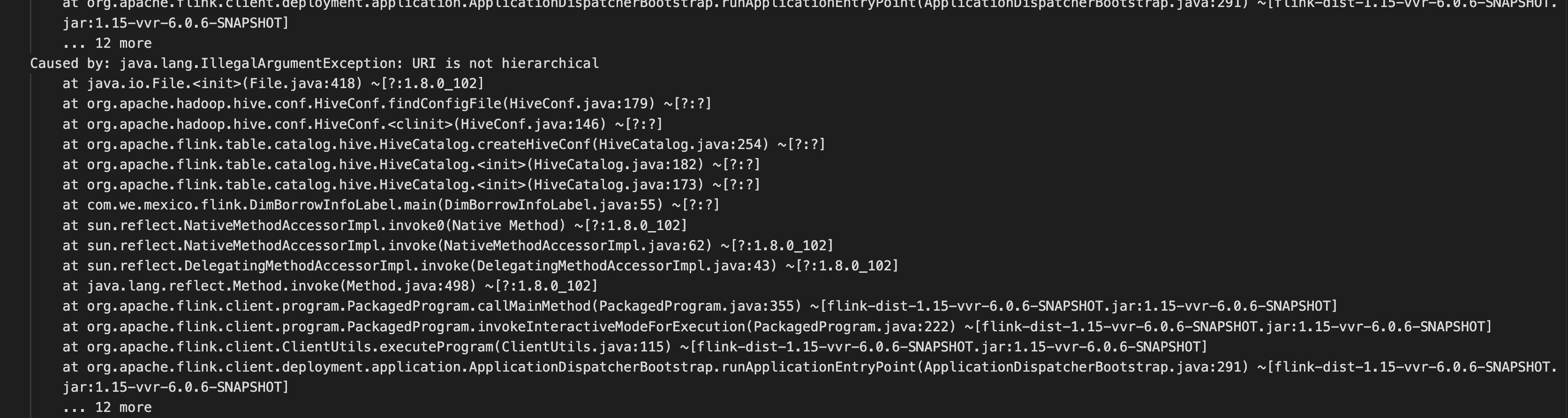

问下阿里全托管flink下,怎么在代码中配置oss路径的hive-catalog?云下配置本地路径没问题,云上配置oss的hive-catalog 目录,直接报

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

要在阿里云全托管Flink中通过代码配置OSS路径的Hive Catalog,请遵循以下步骤进行操作:

确保您的Flink项目已正确配置了与阿里云OSS及Hive Catalog相关的依赖。这通常涉及到在项目的pom.xml(如果是Maven项目)或相应构建文件中添加必要的依赖项。

在Flink的配置文件(如flink-conf.yaml)中,添加或更新以下配置以指向OSS存储上的Hive元数据和仓库目录:

hive.metastore.warehouse.dir: oss://${YOUR_OSS_BUCKET}/${YOUR_WAREHOUSE_PATH}

fs.oss.accessKeyId: ${YOUR_ACCESS_KEY_ID}

fs.oss.accessKeySecret: ${YOUR_ACCESS_KEY_SECRET}

fs.oss.endpoint: ${YOUR_OSS_ENDPOINT}

fs.defaultFS: oss://${YOUR_OSS_HDFS_BUCKET_DOMIN}

请替换${YOUR_ACCESS_KEY_ID}, ${YOUR_ACCESS_KEY_SECRET}, ${YOUR_OSS_BUCKET}, ${YOUR_WAREHOUSE_PATH}, 和 ${YOUR_OSS_ENDPOINT}为实际的值。

oss://${bucket}/artifacts/namespaces/${ns}/${hms}。hive-site.xml)以及必要的Hadoop配置文件(如core-site.xml, hdfs-site.xml等)上传到对应的OSS目录下:

hive-conf-dir/存放hive-site.xml。hadoop-conf-dir/存放Hadoop相关配置文件。在Flink应用代码中,使用如下方式创建指向OSS的Hive Catalog实例:

// 导入必要的类库

import org.apache.flink.table.api.bridge.java.StreamTableEnvironment;

import org.apache.flink.table.catalog.hive.HiveCatalog;

// 初始化TableEnvironment

StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

StreamTableEnvironment tableEnv = StreamTableEnvironment.create(env);

// 创建Hive Catalog实例

String catalogName = "myHiveCatalog"; // 自定义Catalog名称

String defaultDatabase = "default"; // 默认数据库名

String metastoreURI = "thrift://your-metastore-host:port"; // Hive Metastore服务地址

String warehouseDir = "oss://${YOUR_OSS_BUCKET}/${YOUR_WAREHOUSE_PATH}"; // OSS上的仓库目录

HiveCatalog hiveCatalog = new HiveCatalog(catalogName, defaultDatabase, metastoreURI, warehouseDir);

// 注册Catalog

tableEnv.registerCatalog("catalogName", hiveCatalog);

metastoreURI,如果使用的是内建的Hive Metastore服务,则可能需要不同的配置。以上步骤指导您如何在阿里云全托管Flink环境中通过代码配置指向OSS的Hive Catalog。务必根据实际环境调整具体参数。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。