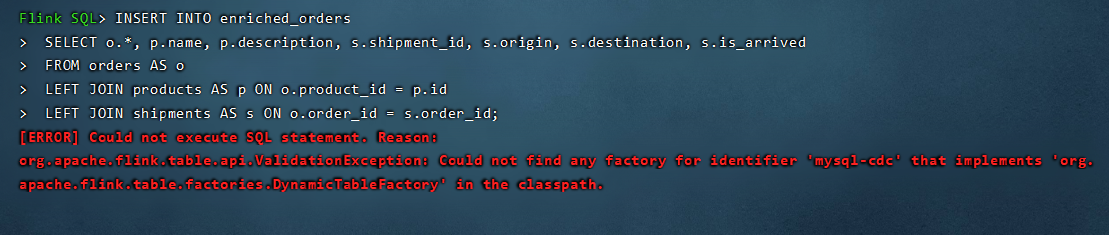

Flink CDC样例中关联订单数据并且将其写入 Elasticsearch 中这一步报错是缺少了什么东西吗?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

根据您描述的问题,Flink CDC作业在尝试关联订单数据并写入Elasticsearch时遇到报错,这可能是由于多种原因导致的。结合知识库中的信息,这里提供一些可能的原因和解决思路:

配置不完整或错误:确保您的Flink作业配置中包含了所有必要的连接参数和sink配置。例如,对于Elasticsearch sink,需要正确设置endPoint、accessId、accessKey、index以及typeName等参数。

权限问题:检查Elasticsearch实例是否对Flink任务执行用户赋予了足够的写入权限。包括索引是否存在以及用户是否有权修改或创建索引。

数据映射问题:如果使用了如StarRocks-migrate-tools (SMT) 进行数据迁移配置,确认所有表规则[table-rule.x]都配置了完整的database、table和Flink Connector信息,避免因缺少必要选项而导致的验证异常。

资源限制:确认Elasticsearch集群是否有足够的存储空间和资源处理写入请求,避免因磁盘满或资源不足导致的写入失败。

网络与连接问题:检查网络配置,确保Flink作业能够顺利访问到Elasticsearch服务地址,无防火墙或网络策略阻拦。

数据格式或类型不匹配:确认写入Elasticsearch的数据结构与定义的索引mapping兼容,不匹配可能导致写入失败。

Flink作业配置:检查Flink作业的Checkpointing配置是否启用且正确设置,以支持Task的自动重启。此外,确保没有其他配置错误或遗漏,比如作业的SQL逻辑中可能缺失了对订单数据源的正确引用或转换逻辑。

为了解决问题,请按照以下步骤操作: - 复查配置:仔细核对sink至Elasticsearch的所有配置项。 - 日志分析:查看Flink作业的日志输出,通常错误信息会提供更具体的报错原因。 - 资源检查:确保Elasticsearch集群资源充足,特别是磁盘空间。 - 权限验证:确认Elasticsearch的访问权限设置正确。 - 数据流验证:检查数据流经的每个环节,包括数据源、转换逻辑及sink配置,确保数据类型和结构与目标索引相匹配。

通过上述排查和调整,应能定位并解决Flink CDC作业写入Elasticsearch时遇到的问题。您可以复制页面截图提供更多信息,我可以进一步帮您分析问题原因。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。