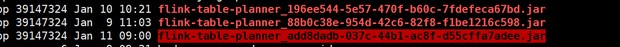

使用sql-client -f 提交脚本,为啥每次都会在/tmp文件夹下面生成一个flink-table-planner*.jar 有大神知道吗?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

当您使用sql-client -f命令提交Flink SQL脚本时,Flink会自动将SQL脚本编译成执行计划,并打包成一个临时的JAR文件存储在/tmp目录下。这个JAR文件名为flink-table-planner*.jar,其中星号(*)代表的是随时间或会话变化的随机后缀,用于区分不同执行会话的临时JAR文件。

原因解释: 1. 动态编译与优化:Flink SQL客户端在接收到SQL脚本后,需要对其进行解析、验证以及优化处理,这一过程涉及到Flink的Table API和SQL Planner。为了执行这些操作,Flink会生成一个包含所有必要依赖和优化后执行计划的可执行JAR包。 2. 资源隔离与管理:利用临时文件系统(如/tmp目录)来存储这些临时JAR,可以避免对主工作目录的污染,同时便于管理和清理。因为这些文件是执行过程中的临时产物,通常在作业执行完毕或者客户端关闭后可以被安全删除,不会长期占用磁盘空间。

注意事项: - 空间监控:虽然这些文件为临时性质,但如果频繁执行SQL脚本且没有适当的清理机制,可能会暂时性地占用较多的/tmp空间。因此,定期检查并清理/tmp目录是一个好习惯。 - 版本兼容性:确保Flink版本与使用的SQL语法及依赖库版本兼容,以避免因编译产生的JAR不兼容导致的执行错误。

此行为是Flink SQL客户端的标准操作流程,旨在提升执行效率和灵活性,无需特别担心。但如果您发现该过程导致了特定问题,比如磁盘空间不足等,可以根据实际情况考虑调整临时文件的存储位置或优化作业执行策略。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。