版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

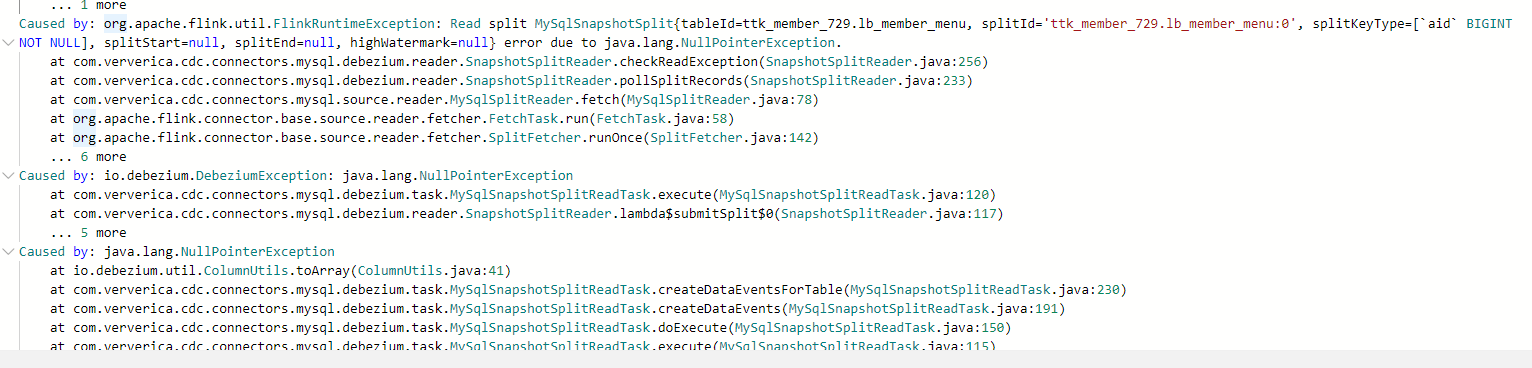

此错误通常表示 Flink 作业无法从 Checkpoint 中恢复其状态。这可能是由于以下原因:

Checkpoint 文件损坏或丢失。检查你的存储系统以确保 Checkpoint 文件存在且未损坏。

Checkpoint 和作业配置不匹配。确保 Checkpoint 文件与要恢复的作业的配置兼容。

状态后端配置不正确。检查你的状态后端配置以确保它与 Checkpoint 文件的格式兼容。

JVM 崩溃或 OutOfMemory 错误。如果 Flink 作业在 Checkpoint 期间崩溃或遇到 OutOfMemory 错误,则 Checkpoint 可能已损坏。

规避方法:

使用可靠的存储系统存储 Checkpoint。考虑使用 Amazon S3、Azure Blob Storage 或 Google Cloud Storage 等持久性存储系统。

定期验证 Checkpoint 的完整性。使用 Flink 的 flink checkpoint verify 命令定期检查 Checkpoint 文件是否损坏。

在生产环境中启用 Flink 的高可用性。这将确保作业故障时可以从另一个 JobManager 恢复。

监控作业的内存使用情况。如果作业接近内存限制,请考虑增加作业的内存或优化代码以减少内存使用。

使用增量 Checkpoint。增量 Checkpoint 可以减少 Checkpoint 文件的大小和恢复时间。

其他提示:

检查 Flink 作业的日志以获取有关错误的更多信息。

在 Flink 社区论坛或邮件列表上寻求帮助。

参考 Flink 文档以获取有关故障排除的更多信息:https://ci.apache.org/projects/flink/flink-docs-stable/ops/debugging.html

注意:

此错误与前面提到的 DDL 语句重复消费无关。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。