请教下,我通过fFlink CDC lnk cdc拿到mysql数据到kafka后如何使用呢?因为都是binlog的记录而不是源数据表的完整结构

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

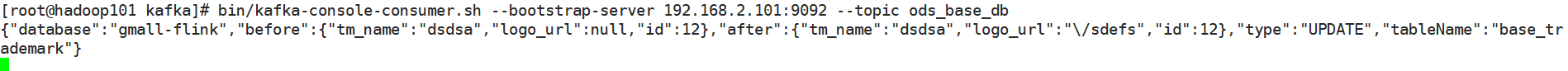

当您通过Flink CDC链接从MySQL获取数据并发送到Kafka后,这些数据是以Binlog形式记录的变更事件(如INSERT、UPDATE、DELETE),而非完整的源数据表结构。要使用这些数据,您需要在下游消费端对这些变更事件进行处理,以重构或更新您的目标数据存储,使其保持与源数据库同步。以下是处理步骤:

I(INSERT), U(UPDATE), -D(DELETE))以及对应的数据字段。增量处理:

INSERT事件,直接将新记录插入到目标系统(如HBase、Elasticsearch、另一个数据库等)。UPDATE事件,根据主键定位到目标系统中的记录并更新其内容。DELETE事件,同样根据主键定位并删除目标系统中的相应记录。全量与增量结合:首次启动时,可能需要先做一次全量数据同步,之后再应用增量的Binlog事件,确保数据的完整性。这可以通过执行一次全量SQL查询或者利用Flink的Savepoint功能实现。

// 假设使用Flink作为消费框架

streamExecutionEnvironment = StreamExecutionEnvironment.getExecutionEnvironment();

FlinkKafkaConsumer<String> kafkaSource = new FlinkKafkaConsumer<>(

"your-kafka-topic",

new SimpleStringSchema(),

kafkaProperties);

DataStream<String> binlogStream = env.addSource(kafkaSource);

binlogStream

.map(new MapFunction<String, BinlogEvent>() {

@Override

public BinlogEvent map(String value) {

// 解析Kafka消息为BinlogEvent对象

return parseBinlogEvent(value);

}

})

.keyBy(event -> event.getPrimaryKey())

.process(new MyProcessFunction()); // 自定义函数处理Insert/Update/Delete事件

env.execute("MySQL Binlog to Kafka Processing");

通过上述步骤,您可以有效地利用从MySQL通过Flink CDC流转到Kafka的Binlog数据,实现实时数据集成和处理任务。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。