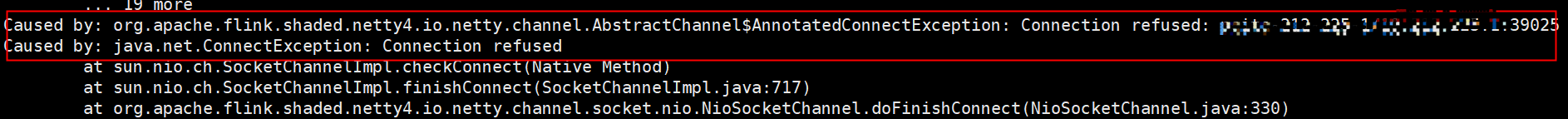

大神有人知道这个错误嘛? flink1.15 cdh6.3.2

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

您好!根据您提供的错误信息“flink1.15 cdh6.3.2”,看起来您可能在尝试将Apache Flink 1.15与CDH 6.3.2集成时遇到了问题。虽然知识库中没有直接针对此特定环境组合的解决方案,但我们可以基于Flink和大数据平台的一般知识给出一些建议来帮助您排查问题。

检查兼容性: 验证Flink 1.15是否支持与CDH 6.3.2的集成。查阅官方文档或社区论坛了解已知的兼容性问题。

审查依赖:确保所有依赖项(包括Hadoop客户端库)与CDH 6.3.2中的版本相兼容。必要时,调整pom.xml或构建脚本以排除或指定正确的依赖版本。

配置验证:

日志分析:详细查看Flink作业提交到YARN时的日志输出,寻找错误或警告信息,这些通常会提供失败的具体原因。

环境一致性:确认开发环境与生产环境(CDH集群)的Java版本、网络配置等保持一致。

测试升级或降级:如果上述方法均无法解决问题,考虑测试其他Flink版本与CDH的组合,看是否为特定版本间的兼容性问题。

请按照上述步骤逐一排查,希望能帮助您解决遇到的问题。如果问题依旧,建议提供更具体的错误信息或日志,以便进行更深入的分析。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。