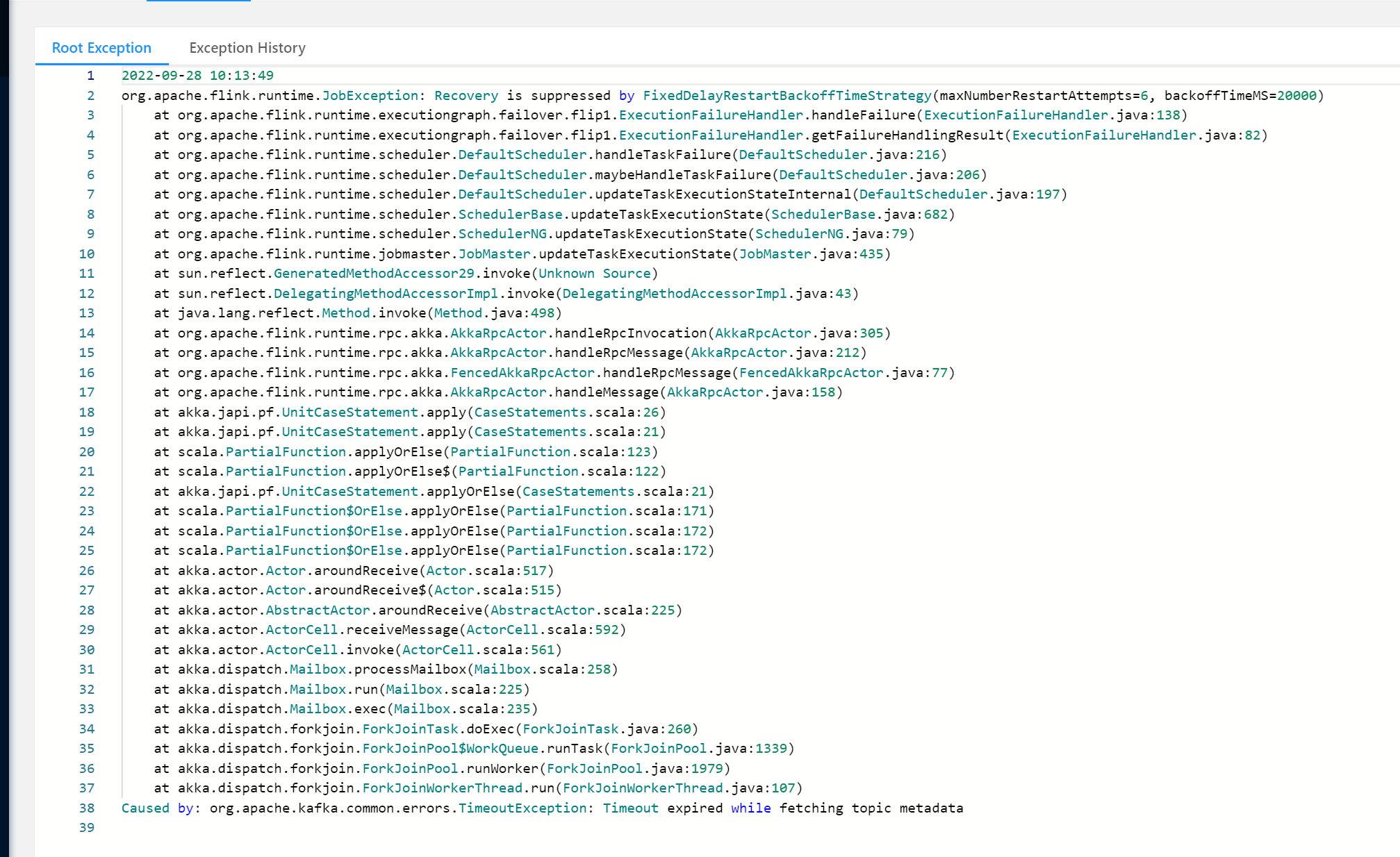

我通过Kafka命令是可以消费到Kafka数据的,但是在代码中就报这个错误,和某个节点发生GC有关系吗?TimeoutException: Timeout expired while fetching topic metadata

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

遇到TimeoutException: Timeout expired while fetching topic metadata错误,通常并不直接关联到某个节点的GC(垃圾回收)问题,而是与网络连接、Kafka Broker的可达性、以及客户端配置有关。根据提供的知识库资料,以下是一些可能的原因及解决步骤:

网络连通性检查:

telnet或nc命令检查与Kafka Broker地址的TCP连接是否畅通。Kafka元数据获取超时:

request.timeout.ms和metadata.max.age.ms参数,增加请求超时时间和元数据的最大更新间隔。用户名和密码验证:

bootstrap.servers、sasl.jaas.config等配置项设置正确。DNS解析问题:

Kafka Broker状态检查:

/brokers/ids路径下,并且它们的Endpoint信息是可达的。特别注意listener_security_protocol_map中的配置,确保客户端能通过正确的协议和端口访问。客户端日志分析:

资源与性能监控:

综上所述,此错误主要指向网络、配置或Kafka集群状态方面的问题,而不是直接由单个节点的GC引起。通过上述步骤逐一排查,应该能找到问题所在并进行相应解决。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。