flink处理数据,突然有时间戳异常的数据那么我后续来的正常数据还会被处理(filter算子)吗

flink处理数据,突然有时间戳异常的数据(时间是七天后)那么我后续来的正常数据还会被处理(filter算子)吗

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

-

公众号:网络技术联盟站,InfoQ签约作者,阿里云社区签约作者,华为云 云享专家,BOSS直聘 创作王者,腾讯课堂创作领航员,博客+论坛:https://www.wljslmz.cn,工程师导航:https://www.wljslmz.com

如果flink处理数据的程序中使用的是EventTime,那么在处理数据时Flink会根据数据中的时间戳来判断事件发生的顺序,从而进行事件的处理。因此,如果突然出现时间戳异常的数据,这些数据会被判定为“延迟到达”的事件,而不是已经过去的事件,这会导致后续的事件也被延迟到达。

默认情况下,过去的事件(即Watermark <= EventTime)将被立即处理,而延迟到达的事件(即Watermark > EventTime)将被等待一定时间。处理延迟数据时,如果有用到TimeWindow之类的窗口操作,Flink程序会持续等待一定时间(等待时间由Flink的EventTime延迟阈值决定),以便等待更多可能延迟到达的事件过来,以填补之前因延迟到达事件导致的数据缺失。因此,后续来的正常数据仍然会被处理,但会等待一定时间等待之前延迟到达的事件到达进而得到更完整的结果。

如果您使用的是ProcessTime,那么Flink会按照系统时间来判断事件发生的顺序,这时候时间戳异常的事件会被当做未来的事件,不会影响后续事件的处理。

2023-05-05 20:42:56赞同 展开评论 -

如果您使用 Flink 的时间窗口处理数据,那么窗口的开始和结束时间通常是由数据流中的事件时间戳确定的。事件时间戳作为事件的时间戳,一般也应该是事件发生的时间。如果您的数据流中出现时间戳异常的数据,例如时间戳比实际时间晚七天,那么这些数据可能会对基于事件时间的处理产生影响,导致窗口无法及时关闭或者延迟关闭,从而对后续数据的处理可能会造成影响。

对于事件时间戳异常的数据,您可以考虑将它们过滤掉,而不是将其包含在窗口中。如果您使用的是 Flink 的 Filter 算子进行数据过滤,那么在自定义 Filter 函数时,可以对异常的时间戳进行判断,如果超出了一个合理的时间范围就过滤掉该数据。这样可以保证后续来的正常数据不会受到影响,并且窗口的关闭也不会延迟。

另外,如果您使用的是基于处理时间的窗口,在窗口定义中使用的是 ProcessingTimeTrigger,那么窗口的关闭是由系统时间触发的,与数据流中的事件时间戳无关。因此,在这种情况下,即使数据流中出现异常的事件时间戳,也不会对窗口的关闭产生影响。但是,基于处理时间的窗口只考虑事件被处理的时间,无法反映事件实际发生的时间,不适用于需要分析和监控实时数据的场景。

2023-05-05 18:15:14赞同 展开评论 -

对于事件时间处理来说,Flink程序通常会根据每个事件的时间戳来触发一些时间驱动型的操作,例如窗口操作,而窗口操作通常是按照时间戳将事件划分到不同的窗口中。如果某些事件的时间戳异常并超出了您定义的窗口边界,则这些事件将不会被包含在任何窗口中,从而不会触发与下游算子的交互。

如果您使用的是Filter算子对数据流进行过滤,那么当突然出现时间戳异常的数据时,如果您的Filter算子逻辑未进行处理,则异常数据和后续的正常数据都会被Filter算子过滤掉。

因此,在处理具有时间戳异常的数据时,您可以使用特殊的处理逻辑,例如将异常数据记录在日志文件中或者将其标记为无效数据,从而保留后续的正常数据进一步处理。

2023-05-03 08:05:06赞同 展开评论 -

如果您使用的是Flink的事件时间(Event Time)处理方式,则会将异常时间戳的数据按照其实际时间戳进行处理,而后续来的正常数据也会顺利被处理。因为在事件时间中,数据的处理时间取决于数据本身的时间戳,而不是数据到达算子的时间。但是如果您使用的是处理时间(Processing Time)处理方式,则异常时间戳的数据可能会由于被视为过时而被丢弃,从而影响后续正常数据的处理。

2023-04-28 20:16:06赞同 展开评论 -

云端行者觅知音, 技术前沿我独行。 前言探索无边界, 阿里风光引我情。

在Flink中,时间戳异常的数据可能会影响后续来的正常数据的处理。这是因为Flink的时间戳处理机制是基于事件的,即每个事件的时间戳是它被发送时的时间戳。如果时间戳异常的数据被标记为已处理,那么后续来的正常数据将无法被处理,因为它们的时间戳比异常数据更晚,会被误判为已经处理过的数据。

为了解决这个问题,您可以使用Flink的Filter算子来过滤时间戳异常的数据。在Filter算子中,您可以使用temporalFilter()方法来检查事件的时间戳是否异常,如果不异常,则将事件传递给下游算子进行处理,否则丢弃该事件。

2023-04-27 18:00:44赞同 展开评论

2023-04-27 18:00:44赞同 展开评论 -

值得去的地方都没有捷径

在Flink中处理数据时,会使用Watermark来指示事件时间中存在的延迟。Watermark是事件时间的度量,指示系统可确信在此之前所有事件均已到达。如果您的数据流中出现时间戳异常的数据(如您的问题中所述,时间戳是七天之后),则这些事件的Watermark是非常高的,因为系统无法确信在这之后是否还有更多的事件到达。为了避免根据过高的Watermark而丢弃正常数据,您可以使用系统控制Watermark的算法进行优化。

当系统接收到新的事件时,Watermark的值会发生变化,因此在您的数据流中出现异常后,后续到达的正常数据仍然会被处理。从概念上讲,如果Watermark的值仅仅因为某些时间戳异常的事件而变得非常高,那么处理正常数据的过程并不会受到影响。因此,在使用Flink进行数据处理时,要注意对异常事件的处理,并确保设计算法时考虑到事件时间的整体特点以减少对正常数据处理的干扰。

2023-04-26 14:38:49赞同 展开评论 -

在 Flink 中使用 Filter 算子进行数据过滤时,如果输入数据中存在时间戳异常的数据,后续正常数据是否会被处理,需要根据具体情况来确定。以下是一些可能的情况和处理方式:

时间戳异常的数据被过滤掉 如果时间戳异常的数据被正确地过滤掉,则后续正常数据仍会被 Filter 算子处理。可以在算子中根据具体条件判断输入数据是否异常,并对异常数据进行特殊处理或者直接丢弃。

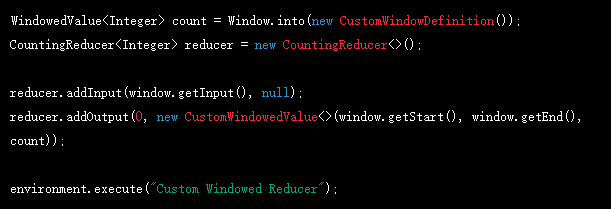

例如,可以编写如下代码来实现对输入数据进行时间戳过滤:

DataStream input = ...; // 输入数据流 long maxEventTime = ...; // 最大事件时间戳

DataStream filtered = input.filter(new FilterFunction() { @Override public boolean filter(Event event) throws Exception { if (event.getTimestamp() > maxEventTime) { // 过滤时间戳异常的数据 return false; } return true; } });

filtered.map(new MapFunction<Event, String>() { @Override public String map(Event event) throws Exception { // 处理过滤后的正常数据 ... return result; } }); 在上述代码中,使用 Filter 算子将时间戳异常的数据过滤掉,并将后续正常数据传递给 Map 算子进行处理。

时间戳异常的数据未被过滤掉 如果时间戳异常的数据未能被正确地过滤掉,则后续正常数据可能会受到影响,从而导致程序错误或者异常退出。可以通过对输入数据进行排序、分区等方式来确保时间戳异常的数据不会影响后续处理。

例如,在使用 Flink 的 DataSet API 进行批处理时,可以在读取数据之后对数据进行排序,并使用 filter 方法过滤掉时间戳异常的数据,以确保后续正常数据仍能被正确处理。

final ExecutionEnvironment env = ExecutionEnvironment.getExecutionEnvironment();

DataSet input = ...; // 输入数据集 long maxEventTime = ...; // 最大事件时间戳

DataSet filtered = input .sortPartition(new KeySelector<Event, Long>() { @Override public Long getKey(Event event) throws Exception { // 按照时间戳升序排列 return event.getTimestamp(); } }, Order.ASCENDING) .filter(new FilterFunction() { @Override public boolean filter(Event event) throws Exception { if (event.getTimestamp() > maxEventTime) { // 过滤时间戳异常的数据 return false; } return true; } });

filtered.map(new MapFunction<Event, String>() { @Override public String map(Event event) throws Exception { // 处理过滤后的正常数据 ... return result; } });

env.execute("Batch processing job"); 在上述代码中,使用 SortPartition 方法对输入数据进行升序排列,并使用 Filter 算子过滤掉时间戳异常的数据。这样可以确保后续正常数据能够按照正确的时间顺序进行处理。

总之,在 Flink 中使用 Filter 算子进行数据过滤时,需要根据具体情况来确定是否会影响后续数据的处理,并采取相应的优化和处理方式来确保任务的正确执行。

2023-04-26 12:33:49赞同 展开评论 -

天下风云出我辈,一入江湖岁月催,皇图霸业谈笑中,不胜人生一场醉。

一般情况下,如果 Flink 处理数据时遇到时间戳异常的数据,该数据可能会被丢弃,然后 Flink 会继续处理后续的数据。但是,具体行为取决于您使用的算子和配置。

对于 filter 算子,它会对每个输入元素应用一个谓词函数,如果函数返回 true,则保留输入元素,否则过滤掉。因此,如果时间戳异常的数据不满足谓词函数,则会被过滤掉,不会对后续正常数据产生影响。

但需要注意的是,如果异常数据的时间戳比后续正常数据的时间戳还要早,而您的程序又使用了事件时间(Event Time)语义来进行处理,那么可能会出现数据丢失或延迟等问题。例如,如果异常数据的时间戳比后续正常数据的水位线(Watermark)还要早,那么该条数据不仅会被丢弃,而且可能会导致后续正常数据的延迟或被认为已经过期而被丢弃。

因此,在使用 Flink 进行流处理时,建议根据实际需求选择合适的时间语义,并加入合适的水位线生成机制、窗口算子等来确保数据的正确性和完整性。

2023-04-26 11:00:13赞同 展开评论 -

十分耕耘,一定会有一分收获!

楼主你好,若你的filter算子没有给时间戳进行判断和过滤,在后面的正常数据也会被处理,原因就是因为Flink是一个流处理系统,若数据进入系统就会被立即处理,不会因为之前的数据出现异常而停止处理,所以在算子中一定要对数据进行合理的过滤和判断。

2023-04-24 23:07:31赞同 展开评论 -

如果您使用 Flink 的 EventTime 模式处理数据,那么时间戳异常的数据(比如时间戳七天后的数据)可能会对后续数据的处理产生影响。原因是 EventTime 模式是基于事件时间进行处理的,如果事件时间不正确,Flink 可能会认为某些数据延迟到达,从而影响后续数据的处理。

在这种情况下,您可以考虑使用 Flink 的 ProcessingTime 模式,即基于处理时间进行处理。在 ProcessingTime 模式下,Flink 使用系统时间作为时间戳,而不是数据中的时间戳,因此不会受到数据时间戳异常的影响。但是,ProcessingTime 模式可能会导致结果的准确性降低,因为它不能反映数据的真实时间顺序和时间差异。

如果您仍然需要使用 EventTime 模式,您可以使用 Flink 提供的 Watermark 机制来解决时间戳异常的数据问题。Watermark 是一种特殊的时间戳,用于表示事件时间已经达到某个时间点,因此 Flink 不应该再等待更早的数据。通过设置适当的 Watermark,您可以告诉 Flink 哪些数据是过时的,哪些数据是最新的,从而避免时间戳异常的数据影响后续数据的处理。

总之,如果您使用 EventTime 模式处理数据,请确保数据的时间戳正确无误,并使用适当的 Watermark 机制来处理时间戳异常的数据。如果您使用 ProcessingTime 模式,则不需要考虑时间戳异常的数据问题。

2023-04-24 18:34:23赞同 展开评论 -

全栈JAVA领域创作者

如果你的filter算子中没有对时间戳进行判断和过滤的话,那么后续的正常数据也会被处理。因为Flink是流处理系统,一旦数据进入系统,就会被立即处理,不会因为之前的数据出现异常而停止处理。因此,在算子中,一定要对数据进行合理的过滤和判断,避免异常数据对后续数据的处理造成影响。

2023-04-23 23:47:01赞同 展开评论 -

热爱开发

在阿里云Flink中,如果突然出现时间戳异常的数据,并且您在处理流程中使用了过滤算子(如filter),则可能会影响后续正常数据的处理。原因是时间戳异常的数据可能会导致基于时间的操作不稳定,从而被过滤掉。

为了避免这种情况,建议在过滤算子之前先使用TimestampAssigner将输入数据的时间戳设置为有序的时间戳,以便更好地处理乱序数据和时间戳异常的数据。例如,可以使用BoundedOutOfOrdernessTimestampExtractor或AscendingTimestampExtractor等内置的TimestampAssigner来解决这个问题。

另外,您还可以考虑使用侧输出(Side Output)机制,将时间戳异常的数据分离到一个侧输出流中,避免影响主要流程的数据处理。

2023-04-23 17:43:37赞同 展开评论 -

如果您在 Flink 中使用

filter算子来过滤数据流,并且有些数据的时间戳异常(比如比当前时间晚七天),那么这些异常数据将会被过滤掉,不会被处理。而后续来的正常数据也会按照您所定义的过滤条件进行处理,不会受到之前异常数据的影响。具体来说,如果您在

filter算子中使用类似以下代码的时间过滤条件:.filter(t -> t.getTimestamp() < System.currentTimeMillis())那么只有时间戳小于当前时间的数据才会被处理,时间戳异常的数据会被过滤掉。后续来的正常数据也会被按照这个条件进行过滤和处理,不会受到之前异常数据的影响。

但是需要注意的是,如果您的异常数据发生在窗口操作(如时间窗口或计数窗口)内,且窗口已经开始计算,那么这个窗口中的数据都会被计算并输出。因此,这些异常数据仍然会对窗口计算结果产生影响。

为避免这种情况,您可以在

filter算子之前加上针对异常数据的过滤逻辑,例如:.filter(t -> t.getTimestamp() < System.currentTimeMillis() && t.getTimestamp() > acceptableTime)其中

acceptableTime是一个可接受的时间范围。这样就能防止异常数据对窗口计算结果产生影响了。2023-04-23 17:09:26赞同 展开评论 -

存在即是合理

如果你的Flink程序使用了Watermark来处理事件时间,那么后续来的正常数据可能会被处理。Watermark是Flink中用来表示事件时间进展的机制,它会告诉Flink程序当前处理到哪个时间点的数据,因此Flink会在处理数据时自动忽略那些已经过期的数据。

当Flink程序在处理数据时,如果发现某条数据的时间戳比当前Watermark还要新,则认为这条数据属于迟到数据。如果你在程序中使用了filter算子,那么这条迟到数据可能会被过滤掉,不会被进一步处理。

但需要注意的是,这个行为是基于默认的Flink机制而言的,具体会不会被处理还需要看具体程序的实现。如果你想要确保那些时间戳异常的数据不会被处理,可以在程序中对这些数据进行过滤或者丢弃。

2023-04-23 17:09:21赞同 展开评论

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。