版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

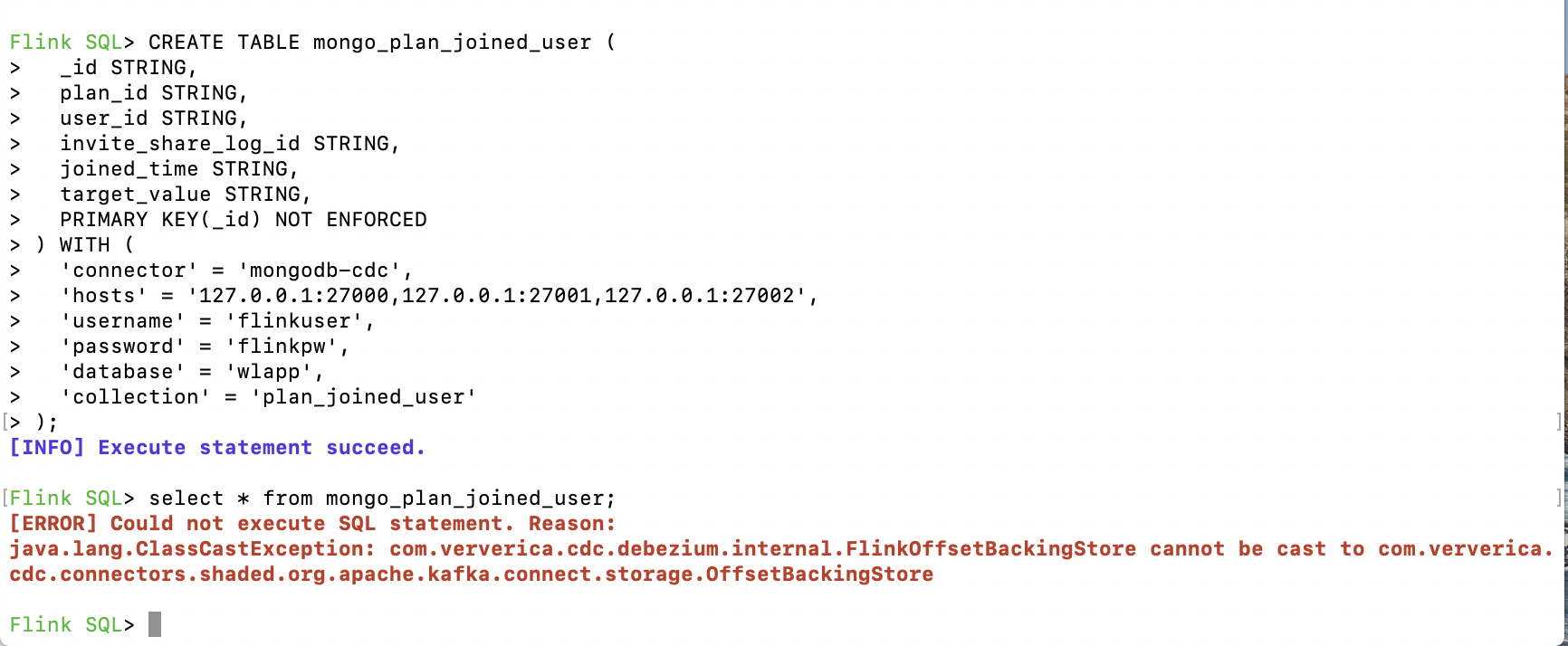

根据报错信息来看的话是在execute SQL时Flink在将FlinkOffsetBackingStore强制转化为OffsetBackingStore类时报错,这种情况一般来说是版本差异造成的,版本不匹配或者是依赖包升级后方法改名无法匹配导致的,建议排查一下执行环境的依赖包版本是否匹配。

根据描述,这个错误是由于 Flink CDC MongoDB Connector 的版本不兼容引起的。具体来说,Flink CDC MongoDB Connector 依赖的 Kafka Connect Storage 接口版本与 Flink 的版本不匹配,导致出现了 ClassCastException 异常。

解决这个问题的方法是升级 Flink CDC MongoDB Connector 的版本,或者降低 Flink 的版本。可以尝试使用 Flink 1.13 或以上版本,同时使用 Flink CDC MongoDB Connector 1.5.3 或以上版本。

另外,也可以查看 Flink 和 Flink CDC MongoDB Connector 的依赖版本,确保它们之间的兼容性。在升级或降低版本时,也需要注意相关依赖是否需要一并升级或降级。

这个错误可能是因为你的 Flink 或者 Kafka 版本不兼容造成的。具体而言,是因为 Flink 和 Kafka 连接器的依赖版本不匹配导致的。

你可以检查一下依赖的版本是否正确,并且确保 Flink 和 Kafka 连接器之间的版本兼容性。建议使用最新版本的 Flink 和 Kafka 连接器,以确保最好的兼容性和稳定性。

这个问题可能是由于您使用的 Flink SQL CDC Connector for MongoDB 版本与 Flink Connector for Kafka 版本不兼容导致的。

具体来说,CDC Connector for MongoDB 和 Connector for Kafka 都依赖于名为 kafka-clients 的 Kafka 客户端库,不同版本的 Connector for Kafka 依赖的 kafka-clients 版本也可能不同。如果您同时在 Flink 作业中使用了 CDC Connector for MongoDB 和 Connector for Kafka,依赖的 kafka-clients 版本可能会发生冲突,导致上述错误。

解决方案如下:

1、确认您使用的 CDC Connector for MongoDB 和 Connector for Kafka 版本是否兼容,可以查看官方文档了解最佳版本组合。

2、如果您使用的版本兼容,则可以尝试在pom.xml中,将flink-connector-kafka的版本设置为Flink SQL CDC Connector for MongoDB版本所依赖的Connector for Kafka版本,并重新编译您的应用程序。例如,在 pom.xml 文件中添加以下依赖:

<dependencies>

<!-- other dependencies... -->

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-connector-kafka_2.12</artifactId>

<version>${flink.kafka.version}</version>

</dependency>

</dependencies>

其中,${flink.kafka.version} 指的是与 CDC Connector for MongoDB 兼容的 Connector for Kafka 版本。

如果问题仍然存在,请将完整的错误消息和您的 Flink SQL 和应用程序配置文件(如 SQL Client 平台上的 YAML 配置)提供出来,以便更好地帮助您解决问题。

可能是 Flink CDC Connector 在使用 Kafka OffsetBackinatore 时出现了类型转换错误,导致不能正确执行 SQL 语句。

建议你检查以下几点:

版本兼容性:Flink CDC Connector 和 Kafka OffsetBackinatore 的版本是否兼容。不同版本之间可能存在 API 的变化或者兼容性问题,导致类型转换错误。

类型匹配:检查代码中类型的定义和使用,确认是否存在类型不匹配的问题。比如,在转换 OffsetBackinatore 类型时,可能存在将其转换成错误的类型,导致类型转换异常。

依赖冲突:这个问题也可能是由于依赖冲突引起的。在应用程序中使用了多个依赖包,其中某些依赖包之间存在版本冲突,可能出现无法预期的行为,包括类型转换错误。

这个报错是因为FlinkOffsetBackingStore这个类不能被强制转换为org.apache.kafka中的类。可能是由于版本不一致造成的。你需要检查你使用的Flink和CDC connector的版本是否匹配,如果版本不匹配,可能会导致类不兼容的问题。

你可以尝试将版本升级到最新的版本,或者手动检查版本兼容性。如果问题仍然存在,请查看CDC connector的文档,以获得更多信息。

这个错误是由于 Flink SQL CDC 连接器在使用新版本 Flink 时与旧版本 Kafka Connect 存储偏移量的 API 不兼容导致的。解决这个问题的方法有两个:

升级 Kafka Connect:将 Kafka Connect 升级到与 Flink SQL CDC 连接器兼容的版本,可以解决这个问题。

使用 Flink 1.13 版本:Flink 1.13 版本中已经更新了 Flink SQL CDC 连接器,可以与 Kafka Connect 存储偏移量的 API 兼容,因此可以解决这个问题。

如果你选择升级 Kafka Connect,请确保升级后的版本与 Flink SQL CDC 连接器兼容。如果你选择使用 Flink 1.13 版本,请注意 Flink 1.13 版本中的一些新特性和变更,需要进行相应的调整。

楼主你好,根据你的报错信息可以知道,是因为flink sql在同步数据的时候因为类型转换失败导致的报错,你可以检查一下数据类型,然后进行转换支持的数据类型即可。

根据错误提示信息,flink sql 同步mongo数据时,出现了 MongoDB BsonDocument类型的数据转换错误。这可能是由于MongoDB BsonDocument中包含了不支持的数据类型导致的。你可以检查你的 MongoDB 数据中是否有不支持的数据类型,并尝试使用其他方式进行同步。另外,你也可以尝试升级 MongoDB 连接器版本,以查看是否已经解决了这个问题。

根据你提供的错误信息,这是一个类型转换异常(ClassCastException)。具体来说,是将com.ververica.cdc.debezium.internal.CdcKafkaOffsetBackingStore类转换为com.ververica.cdc.connectors.shaded.org.apache.kafka.connect.storage.OffsetBackingStore类时引发了异常。

这个问题可能是由于版本不兼容或依赖库冲突导致的。我建议升级Flink SQL和相关依赖库的版本,并确保它们兼容并正确配置。或者,你可以尝试通过查看更详细的日志或从源代码中进行调试来进一步诊断和解决这个问题。

这个问题是因为 MongoDB 的连接 URL 配置不正确,可以尝试检查连接 URL 是否正确配置。具体来说,需要确保连接 URL 包含以下配置项:

mongodb://:表示使用 MongoDB 协议;

username:password@:表示使用用户名和密码进行认证;

server1:port1,server2:port2,…:表示 MongoDB 集群的地址和端口号;

/database:表示连接的数据库名称。

这个错误提示是由于你在使用Flink SQL 同步MongoDB数据时,使用的CDC connector没有正确配置。具体来说,该错误是由于在Flink SQL配置文件中使用的CDC connector是Debezium的,而你在Flink作业中使用的是Kafka Connect的offset存储方式,导致类型转换异常。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。