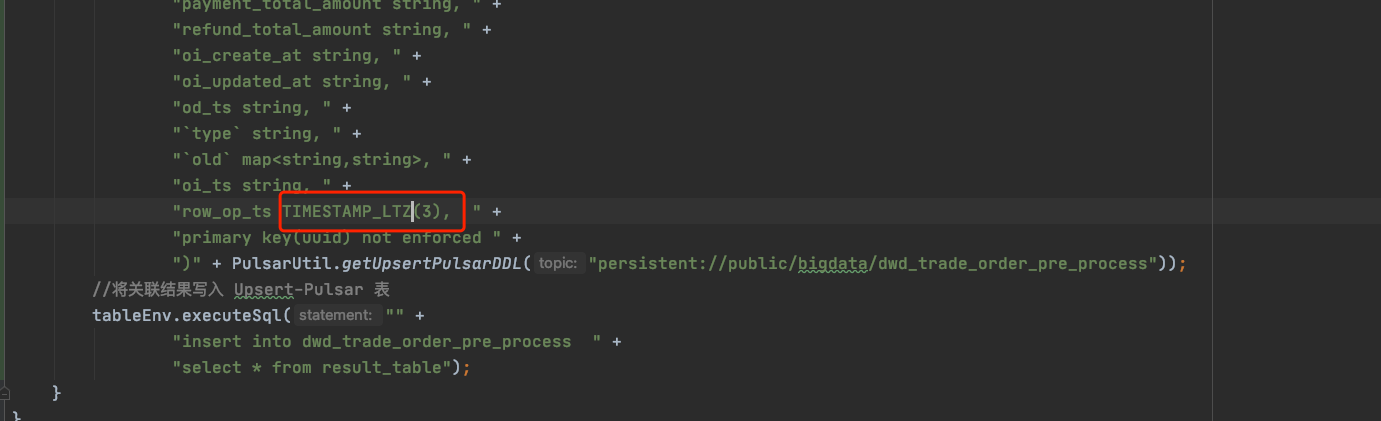

Unsupported to derive Schema for type: TIMESTAMP_LTZ(3) 调用的是org.apache.flink.formats.avro.typeutils.AvroSchemaConverter#convertToSchema(org.apache.flink.table.types.logical.LogicalType, java.lang.String)

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

这个错误通常是由于时间戳类型在 Flink 的 Avro 格式转换器中不受支持造成的。Flink 支持的时间戳类型包括:SQL TIMESTAMP、SQL DATE、SQL TIME(with / without TIME ZONE)以及 java.time classes。

如果您在 Avro 格式转换器中使用了时间戳类型 TIMESTAMP_LTZ(3),则可能会出现这个错误。为了解决这个问题,请确保使用 Flink 支持的时间戳类型,并且更新您的 Avro 格式转换器代码。

如果您需要使用 Avro 格式转换器来转换 TIMESTAMP_LTZ(3) 类型数据,您可以尝试使用自定义的 Avro 类型转换器。您需要实现 org.apache.flink.formats.avro.typeutils.SchemaConverter 接口,并在 Flink 中注册您的自定义转换器:tableEnv.getConfig().getConfiguration().setString("flink.avro.schema-registry.schema-converters", "your.custom.converter;org.apache.flink.formats.avro.typeutils.AvroSchemaConverter")。

这个问题是因为 AvroSchemaConverter 不支持将 TIMESTAMP_LTZ(3) 类型转换为 Avro Schema。TIMESTAMP_LTZ(3) 是 Snowflake 数据库中的一种时间类型,精度是毫秒,比较常见。

为了解决这个问题,您可以尝试使用 Flink 的时间类型来代替 Snowflake 中的 TIMESTAMP_LTZ(3) 类型。您可以在读取 Snowflake 数据时,将 TIMESTAMP_LTZ(3) 类型映射到 Flink 的 TimestampType(如果您使用的是 Flink 1.13 或更高版本)或者 RowtimeType(如果您使用的是 Flink 1.12 或更低版本)。

具体操作可以参考 Flink 官方文档关于时间类型的章节,以及 Flink 和 Snowflake 的连接器文档。

根据错误提示来看的话是AvroSchemaConverter转化为Schema的时候遇到了不支持的数据类型TIMESTAMP_LTZ(3)导致的报错,建议可以更换成其他AvroSchemaConverter支持的

这个错误通常发生在 Apache Flink 的 Avro 格式转换过程中,表明 AvroSchemaConverter 在尝试将 TIMESTAMP_LTZ(3) 类型的逻辑类型转换为 Avro 模式时失败了。

这可能是由于 Flink 版本与 Avro 库版本不兼容导致的。请确保使用的 Apache Flink 版本与 Avro 库版本兼容,并且您已正确配置了 Avro 库。

此外,TIMESTAMP_LTZ(3) 类型可能不支持在 Avro 模式中。您可以尝试使用其他类型,例如 TIMESTAMP_WITH_TIME_ZONE 或 TIMESTAMP_WITH_LOCAL_TIME_ZONE。

最后,如果您使用的是自定义类型,请确保已正确实现 AvroSchemaConverter 中的 convertToSchema 方法。

是的,这个错误通常是由于 Flink 的 Avro 序列化库不支持某些数据类型而导致的。根据报错信息,很可能是使用了 TIMESTAMP_LTZ 这个逻辑类型,但是 Avro 序列化库不支持这个类型。因此,需要通过一些方式将 TIMESTAMP_LTZ 转换成 Avro 支持的类型。

一种可能的解决方案是,将 TIMESTAMP_LTZ 转换成 TIMESTAMP_WITH_LOCAL_TIME_ZONE 类型。这两种类型本质上是相同的,只是命名和精度略有不同。Flink 支持将 TIMESTAMP_WITH_LOCAL_TIME_ZONE 类型转换成 Avro 支持的 Timestamp 类型,因此可以先将 TIMESTAMP_LTZ 转换成 TIMESTAMP_WITH_LOCAL_TIME_ZONE,然后再序列化。

具体来说,可以使用 Flink org.apache.flink.table.functions.TemporalFunctions.TO_TIMESTAMP_TZ() 函数将 TIMESTAMP_LTZ 转换成 TIMESTAMP_WITH_LOCAL_TIME_ZONE 类型,例如:

sql

SELECT TO_TIMESTAMP_TZ(my_timestamp, 'UTC') as converted_timestamp FROM my_table;

在上面的 SQL 查询中,我们将 my_timestamp 字段从 TIMESTAMP_LTZ 类型转换成 TIMESTAMP_WITH_LOCAL_TIME_ZONE 类型,并指定了时区为 UTC。然后,可以将得到的 converted_timestamp 列转换成 Avro 支持的 Timestamp 类型进行序列化。

这个报错通常是由于 Flink 在尝试将特定的逻辑类型转换为 Avro schema 时失败了。其中 TIMESTAMP_LTZ 是指带有本地时区的时间戳类型。

这个问题的解决方案可能取决于您的具体情况,但以下是一些可能有用的步骤:

确保您正在使用最新版本的 Flink 和 Avro 依赖项。这可能会解决一些已知的问题。

检查您的代码,确保您正在正确地使用 TIMESTAMP_LTZ 类型。如果您正在使用自定义类型,可能需要实现自定义的 AvroSchemaConverter。

如果您正在使用 Flink Table API 或 SQL,您可以尝试使用 toTimestampLtz() 函数将 TIMESTAMP 类型转换为 TIMESTAMP_LTZ 类型。这可能会解决一些兼容性问题。

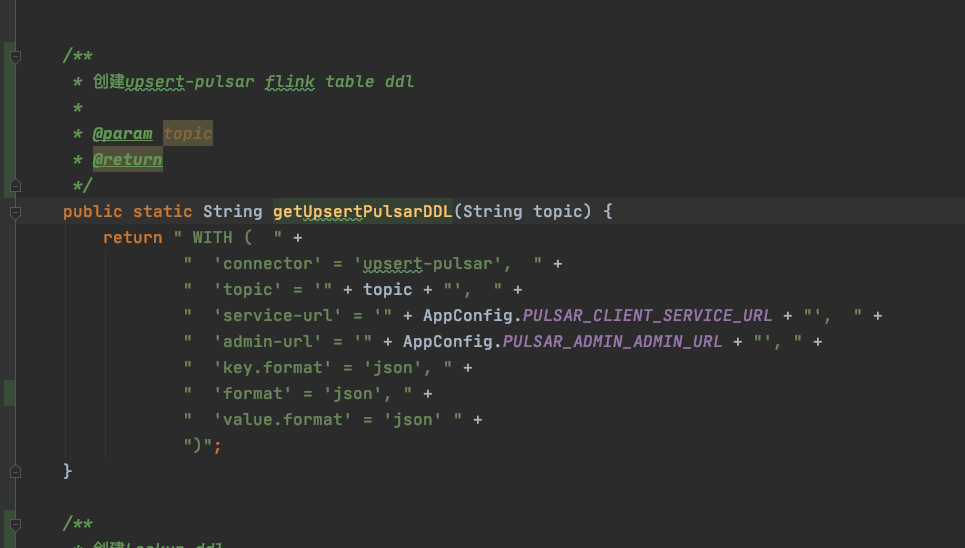

如果您无法解决这个问题,请考虑在 Flink 和 Avro 之间使用其他格式,如 JSON 或 Parquet。

希望这些步骤能帮助您解决问题。如果问题仍然存在,请提供更多上下文,以便我能够更好地帮助您。

Unsupported to derive Schema for type: TIMESTAMP_LTZ(3)这个错误是由于Flink在将TIMESTAMP_LTZ类型转换为Avro架构时不支持引起的。这是因为TIMESTAMP_LTZ类型包含带有时区偏移量的时间戳信息,而Avro架构中只支持UTC时间戳。

为了解决这个问题,您可以考虑以下两个方案:

使用TIMESTAMP_WITHOUT_TIME_ZONE类型 如果您使用的是Flink 1.12及以上版本,可以考虑使用TIMESTAMP_WITHOUT_TIME_ZONE类型代替TIMESTAMP_LTZ类型,以避免出现该问题。TIMESTAMP_WITHOUT_TIME_ZONE类型表示无时区偏移量的本地时间戳,与Avro架构中的UTC时间戳相似。

自定义Avro架构 如果您必须使用TIMESTAMP_LTZ类型,并且需要将其导出为Avro格式,那么可以尝试自定义Avro架构,以便支持TIMESTAMP_LTZ类型。具体来说,您可以在org.apache.flink.formats.avro.typeutils.AvroSchemaConverter#convertToSchema方法中添加对TIMESTAMP_LTZ类型的支持。

例如,您可以使用以下代码片段将TIMESTAMP_LTZ类型转换为Avro架构:

case TIMESTAMP_LTZ: // 将TIMESTAMP_LTZ转换为UTC时间戳 LogicalType innerType = ((TimestampLtzType) logicalType).getUnscaledTimestampType(); if (innerType instanceof TimestampType) { // 将TIMESTAMP转换为毫秒数 return LogicalTypes.timestampMillis().addToSchema(Schema.create(Schema.Type.LONG)); } else if (innerType instanceof TimeType) { // 将TIME转换为毫秒数 return LogicalTypes.timeMillis().addToSchema(Schema.create(Schema.Type.INT)); } else { throw new UnsupportedOperationException(String.format("Unsupported type: %s", logicalType)); } 在上述代码中,我们将TIMESTAMP_LTZ类型转换为UTC时间戳,并使用Avro的timestamp-millis或time-millis类型来表示。

需要注意的是,在自定义Avro架构时,需要确保实现的正确性和稳定性,并进行相应的测试和评估,以确保系统的稳定性和可靠性。同时,也需要了解Avro架构的相关知识和规范,以便灵活地进行选择和调整。

这个报错通常是由于 Flink 在从 TIMESTAMP_LTZ 类型的逻辑类型中推断 Avro Schema 时出现问题导致的。这个问题可能与 Avro 库的版本或 Flink 的版本有关。 一些可能的解决方法包括:

升级 Avro 库的版本,使用 Flink 官方文档中所推荐的版本。例如,在 Flink 1.12 中,推荐使用 Avro 1.10.0。

检查使用的 Flink 版本是否支持 TIMESTAMP_LTZ 类型,如果不支持,则需要升级到支持该类型的版本。

手动指定 Avro Schema,而不是让 Flink 推断它。可以使用 AvroOutputFormat 的 setSchema 方法来指定 Avro Schema。

如果以上方法都不起作用,建议检查代码中是否有其他可能导致该问题的原因,例如类型转换或序列化问题。

楼主你好,根据你的报错提示,可以知道,是因为你的flink不支持类型造成的,你可以转换一下类型,转换成flink支持的类型即可,这个问题比较常见和普遍,你可以试一下。

这个报错的原因是Flink的Schema Derivation功能暂不支持转换TIMESTAMP_LTZ(3)类型的数据为Avro schema。可能需要手动指定schema或使用其他的Schema Derivation方法来处理这个问题。你可以尝试使用AvroSchema或ProtobufSchema,或者使用createTableSource()函数中的withSchema()方法手动指定schema。

这个错误通常是因为 Flink 不支持 TIMESTAMP_LTZ(3) 类型的数据推导出 Schema,建议将数据类型转换成 Flink 支持的类型再进行操作。具体的解决方法可以尝试在 AvroSchemaConverter.convertToSchema() 方法中添加对该数据类型的处理逻辑,或者使用其他支持该数据类型的工具进行数据处理。

这个报错主要是因为 Flink 的 AvroSchemaConverter 不支持转换 TIMESTAMP_LTZ(3) 类型的数据。TIMESTAMP_LTZ(3) 是 Databricks 上的一个时间类型,它表示带有时区偏移量的时间戳。在 Flink 中,TIMESTAMP_LTZ(3) 会被映射为 TIMESTAMP WITH LOCAL TIME ZONE 类型,但是 AvroSchemaConverter 并不支持该数据类型的转换。

为了解决这个问题,你可以考虑以下几种方案:

尝试将 TIMESTAMP_LTZ(3) 类型转换为其他 Flink 支持的时间戳类型,例如 TIMESTAMP 或者 TIMESTAMP_WITH_TIME_ZONE。这样,AvroSchemaConverter 就可以对该类型的数据进行转换了。具体的转换方法可以参考 Flink 的官方文档或者社区论坛。

如果你一定需要使用 TIMESTAMP_LTZ(3) 类型,并且无法找到其他替代方案,那么可以考虑修改 AvroSchemaConverter 的源码,增加对该数据类型的转换支持。需要注意的是,这种方式需要深入了解 Flink 的内部实现和 AvroSchemaConverter 的工作原理。

这个错误通常是由于在Flink SQL中使用了不正确的数据类型或数据格式导致的。请确保正在使用正确的数据类型和数据格式,并且已正确配置了Flink SQL。

这个错误可能是由于在Flink SQL中使用了不正确的数据类型或数据格式导致的。请确保正在使用正确的数据类型和数据格式,并且已正确配置了Flink SQL。

如果仍然遇到此错误,请检查Flink版本和数据类型,并确保它们都是最新的。还可以尝试在Flink官方文档中查找有关数据类型和数据格式的更多信息。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。