Spark的SparkContext中执行了哪些子任务呢?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

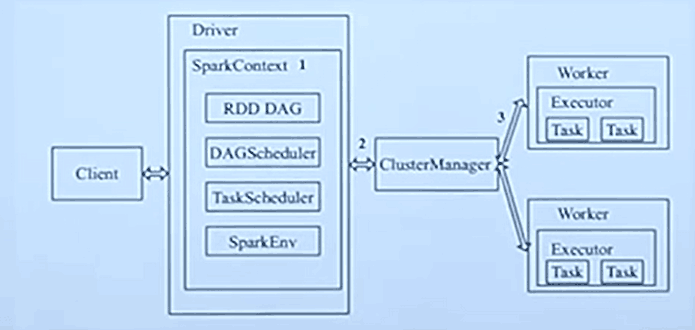

当客户端向Spark提交一个请求完成某个计算时D river首先创建了一个SparkContext, 此时SparkContext还会向CluserManager申请到计算结点Worker ,当得到相关的计算结点后, SparkContext的子任务如下:

1.首先为任务创建一个RDD DAG,即RDD的一个抽象数据集 而数据集的转换抽象的依赖关系就在此创建。

2.为DAG安排一个DAGScheduler,负责如何执行一个个DAG任务

3.创建TaskScheduler通过TaskScheduler来将任务交给结点具体的Excutor来完成。