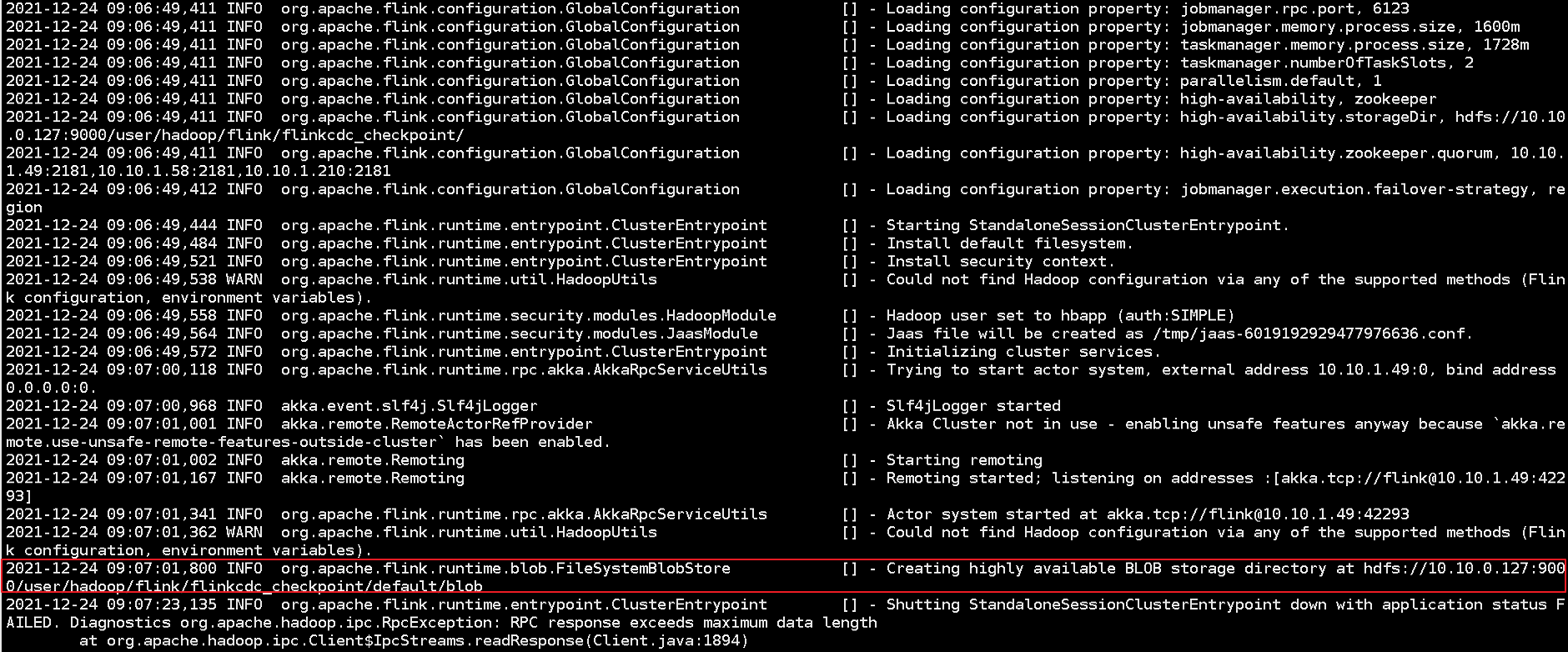

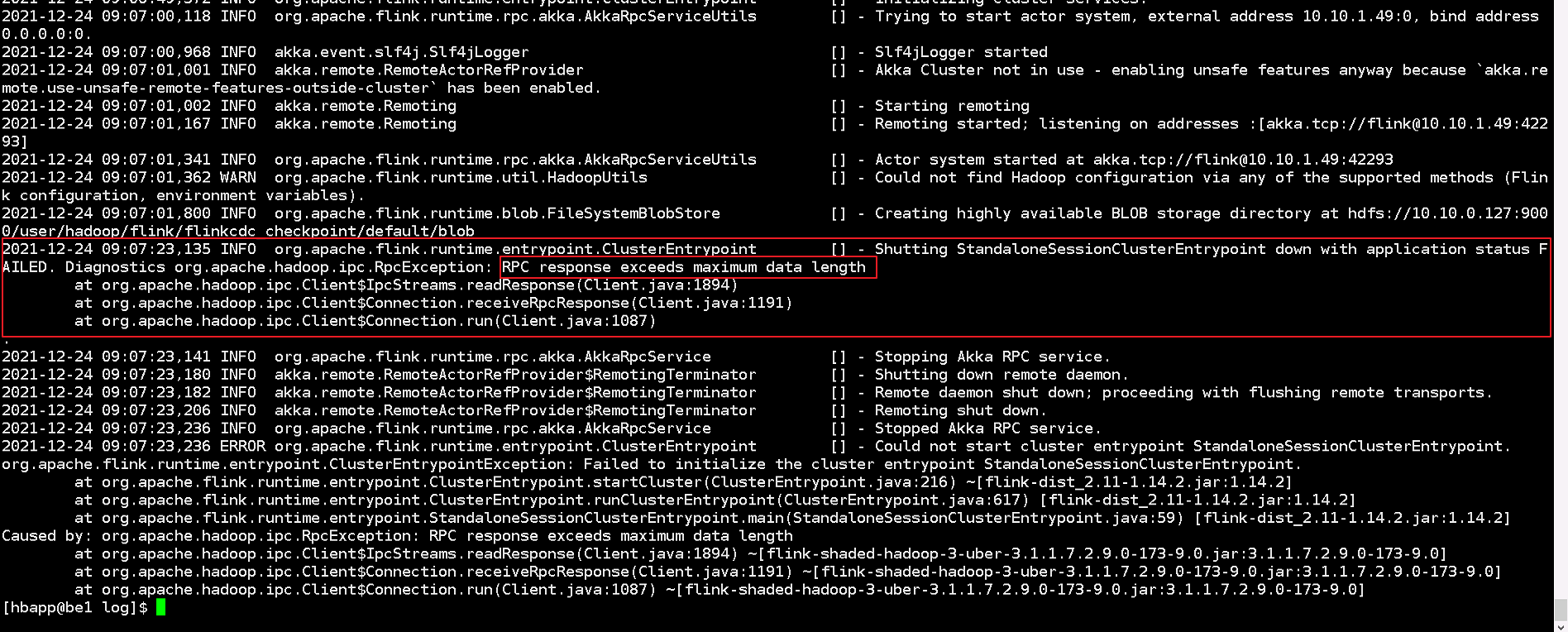

测试机需要配置Flink的HA,需要将checkpoint存放在hdfs上,发现Flink集群无法启动,出现了rpc 过长的错误,但是发现Flink在未启动成功jobmanage和taskmanage后,将checkpoint存放在了HDFS上,我并没有hadoop的权限,测试集群也没有hadoop相关的配置

请问有什么建议?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

根据您描述的情况,Flink集群在未完全启动成功的情况下,checkpoint意外地被写入了HDFS,并且您遇到的是rpc超时错误,同时提到没有Hadoop权限和相关配置。针对这一系列问题,以下是一些建议:

检查网络与RPC配置:

flink-conf.yaml中的网络配置项,如akka.ask.timeout是否设置得过短。适当增加该值以允许更长的rpc响应时间。访问权限验证:

Flink HA配置:

Checkpoint配置调整:

flink-conf.yaml中关于checkpoint的配置(如state.checkpoints.dir),并确保当配置指向HDFS时,路径是可写的且符合预期。由于您提到并未期望在无Hadoop配置下写入HDFS,检查是否有误配置导致此行为。环境一致性检查:

资源与依赖检查:

日志分析:

log/文件夹下,它们能提供失败的具体原因。通过上述步骤,您可以逐步定位并解决Flink集群无法启动以及checkpoint不当存放的问题。如果问题依旧,考虑收集详细的错误日志并与阿里云技术支持联系,获取进一步的帮助。您可以复制页面截图提供更多信息,我可以进一步帮您分析问题原因。