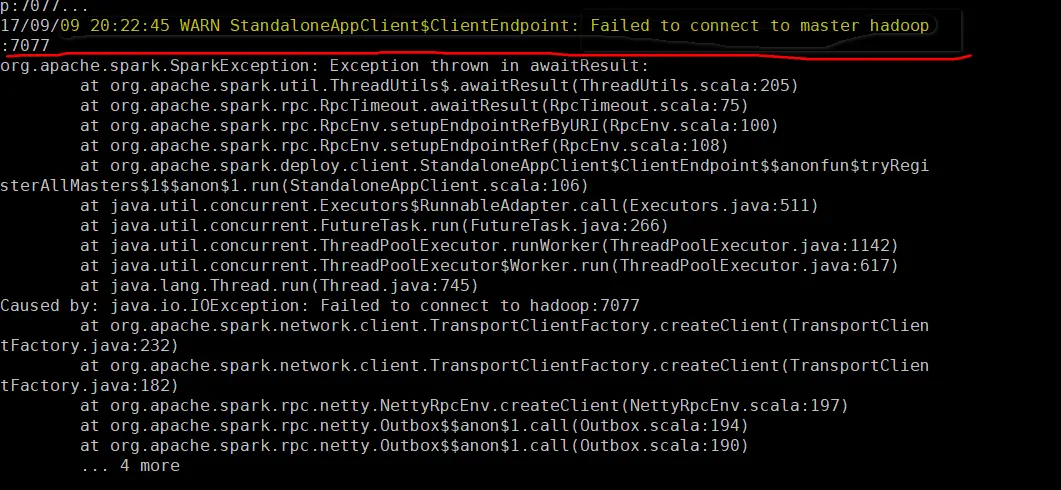

照着网上的那些教程,我已经把相关软件都安装了,能打开hadoop和spark的UI界面,并且能够用hadoop集群求出pi,但是用spark去求时,无论是启动spark-shell还是求Pi,都报错如下:

我已经调了好几天了,实在是没有办法了,跪求各位大神指教啊!!

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

没有办法连接到master,你看看hadoop这个主机名是否能正确解析,如果不能,自己在/etc/hosts里面手动添加上回复<aclass="referer"target="_blank">@GestureWei:hadoop主机是什么意思,我是小白,比较菜目前你的运行sparkshell或者sparksubmit连接的都是hadoop这个主机目前你的运行sparkshell或者sparksubmit连接的都是hadoop这个主机我的主机名是master,不是hadoop啊

前排坐等,spark-shell都启动不起,可能是环境哪里出了问题,重新找个教程装一次,注意下细节

顺带,楼主可以提供一下spark-submit提交脚本的命令

从异常上看,创建SparkContext连接的master节点是hadoop:7077,你要保证这个主机名hadoop能够正确被解析成ip地址,而且是运行了sparkstandalone的master服务