定义任务

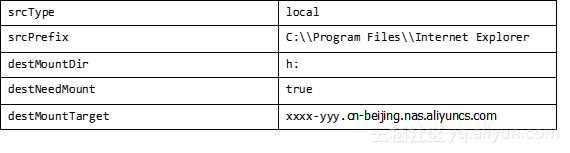

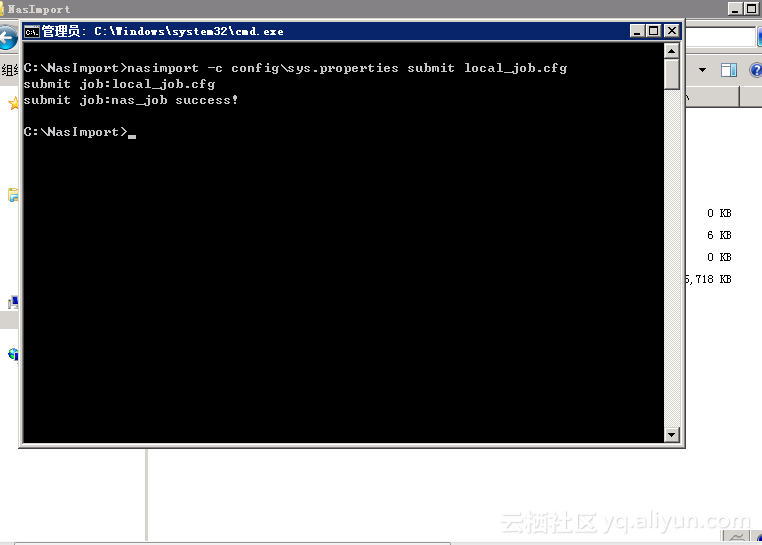

config\local_job.cfg是一个任务定义文件的模板,用户可以按照此模板来定义自己的任务。

备注:

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

基于您的描述,您似乎在操作一个数据迁移或同步任务,特别是涉及到从本地文件系统到阿里云NAS(Network Attached Storage)的文件复制。虽然您的示例直接提及了配置和提交任务的具体步骤,但并未直接关联到阿里云具体的产品服务。不过,我可以帮助您理解如何在阿里云环境下实现类似的数据同步功能,尤其是利用阿里云提供的服务和工具。

对于需要将本地数据同步至阿里云存储服务的需求,阿里云提供了多种工具和服务来简化这一过程,例如:

OSS Import/Export: 虽然直接针对NAS的导入导出服务可能与您的需求不完全匹配,但阿里云对象存储(OSS)提供了一种名为OSS Import/Export的服务,可以通过物理硬盘的方式批量上传大量数据到OSS。对于持续性的同步需求,可以考虑使用OSS的SDK或者CLI工具结合定时任务来实现。

Data Transmission Service (DTS): DTS主要服务于数据库的迁移和同步,如果您的需求涉及数据库同步,这是一个很好的选择。但对于文件系统的同步,DTS可能不是最直接的解决方案。

Hybrid Cloud Storage Gateway: 如果您希望实现本地存储与阿里云存储之间的无缝集成,包括NAS,可以考虑使用混合云存储网关。它能够为本地应用提供云存储访问能力,支持数据的实时同步、备份等。

CLI Tools and SDKs: 利用阿里云提供的CLI工具(如aliyuncli)或各种语言的SDK,您可以编写脚本或应用程序来自动化执行文件上传、下载或同步任务。这要求有一定的编程能力,但灵活性高,可以根据实际需求定制化处理逻辑。

假设您想采用更符合阿里云生态的方式来实现上述任务,这里是一个简化的方案:

选择合适的服务: 基于您的需求(如是否需要频繁更新、数据量大小、安全性要求等),选择最适合的服务,如OSS或考虑使用混合云存储网关连接到NAS。

配置源和目标: 使用所选服务的管理控制台或命令行工具配置数据源(本地文件系统路径)和目标(阿里云存储服务上的路径)。

编写迁移脚本或使用现有工具: 如果没有直接适用的自动化工具,可以编写简单的脚本来调用阿里云CLI或SDK进行文件上传。确保脚本能够处理错误、重试以及断点续传等功能。

设置定时任务: 如果需要定期执行此任务,可以利用操作系统自带的任务计划程序(如Windows的任务计划程序或Linux的cron)来定时运行您的脚本。

监控与管理: 利用阿里云平台提供的监控工具,确保任务按预期执行,并能及时发现并处理任何异常情况。

通过上述方法,您可以有效地将本地数据同步到阿里云存储服务中,同时保持任务的可管理性和自动化程度。