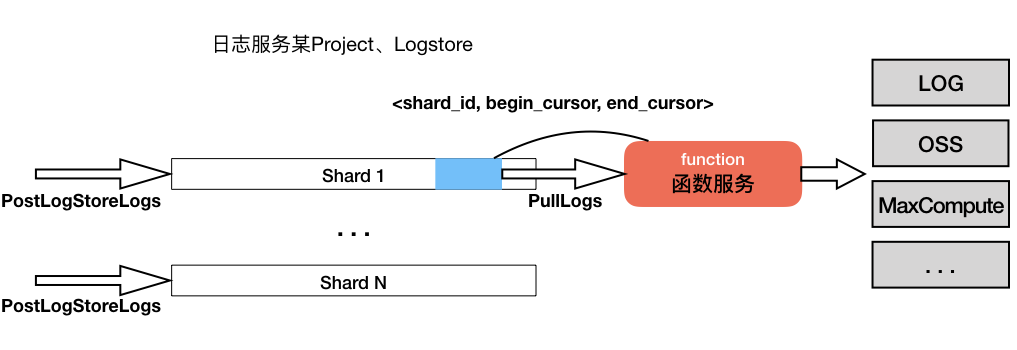

日志服务提供流式的全托管数据加工服务,您可以配置一个ETL Job,日志服务将定时生成ETL Task并触发函数执行:增量消费日志服务logstore的数据,在函数里完成自定义加工任务。用于数据加工的函数可以是日志服务提供的标准函数模板或者用户自定义函数。

基本概念

Project

日志服务Project名字。

ETL Job

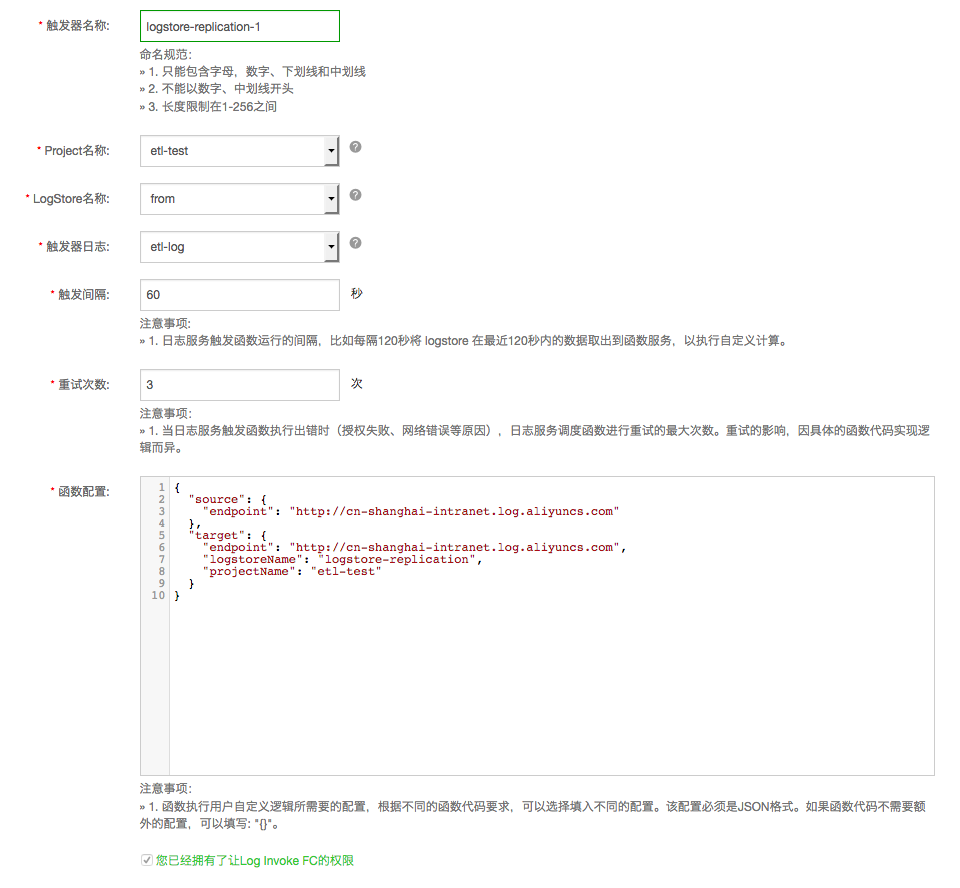

日志服务ETL Job名字,Job归属于Project,有如下配置:

| 配置项 | 取值 | 说明 |

| logstore | 当前project下的logstore | 数据加工的输入源,该配置不允许修改 |

| 触发间隔 | 60 ~ 600秒 | 日志服务每隔一定时间计算一次logstore的shard信息,当发现有新日志写入时,生成的\<shard_id, begin_cursor,="" end_cursor\="" style="box-sizing: border-box;">三元组信息作为函数event的一部分触发函数执行 |

| 最大重试次数 | 0 ~ 100次 | 当函数执行异常失败时,日志服务会定时重试该任务 |

| 触发器日志logstore | 当前project下的logstore | 日志服务将调度函数的一些关键点日志记录到该logstore以备查询,可以看到函数运行失败、数据处理行数等信息 |

| 函数运行日志logstore | 在函数服务控制台设置Service的日志输出,函数实现内的logger信息会记录到该logstore,方便定位具体的异常,参考。 |

| 函数名 | 函数说明 |

| logstore_replication | logstore间数据复制,README |

| ip_lookup | ip数据归属查找,README |

建议使用java8执行时函数,可以获得较好的数据处理效率。

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。