Pentaho DataIntegration(又称Kettle)是一款非常受欢迎的开源ETL工具软件。分析型数据库支持用户利用Kettle将外部数据源写入实时写入表中。

Kettle的数据输出程序并未为分析型数据库进行过优化,因此写入分析型数据库的速度并不是很快(通常不超过700rec/s),不是特别适合大批量数据的写入,但是对于本地文件上传、小数据表等的写入等场景是非常合适的。

我们以导入本地excel文件为例,首先在分析型数据库中建立对应结构的实时写入表。然后用户可在

http://community.pentaho.com/projects/data-integration/上下载kettle软件,安装运行后,新建一个转换。

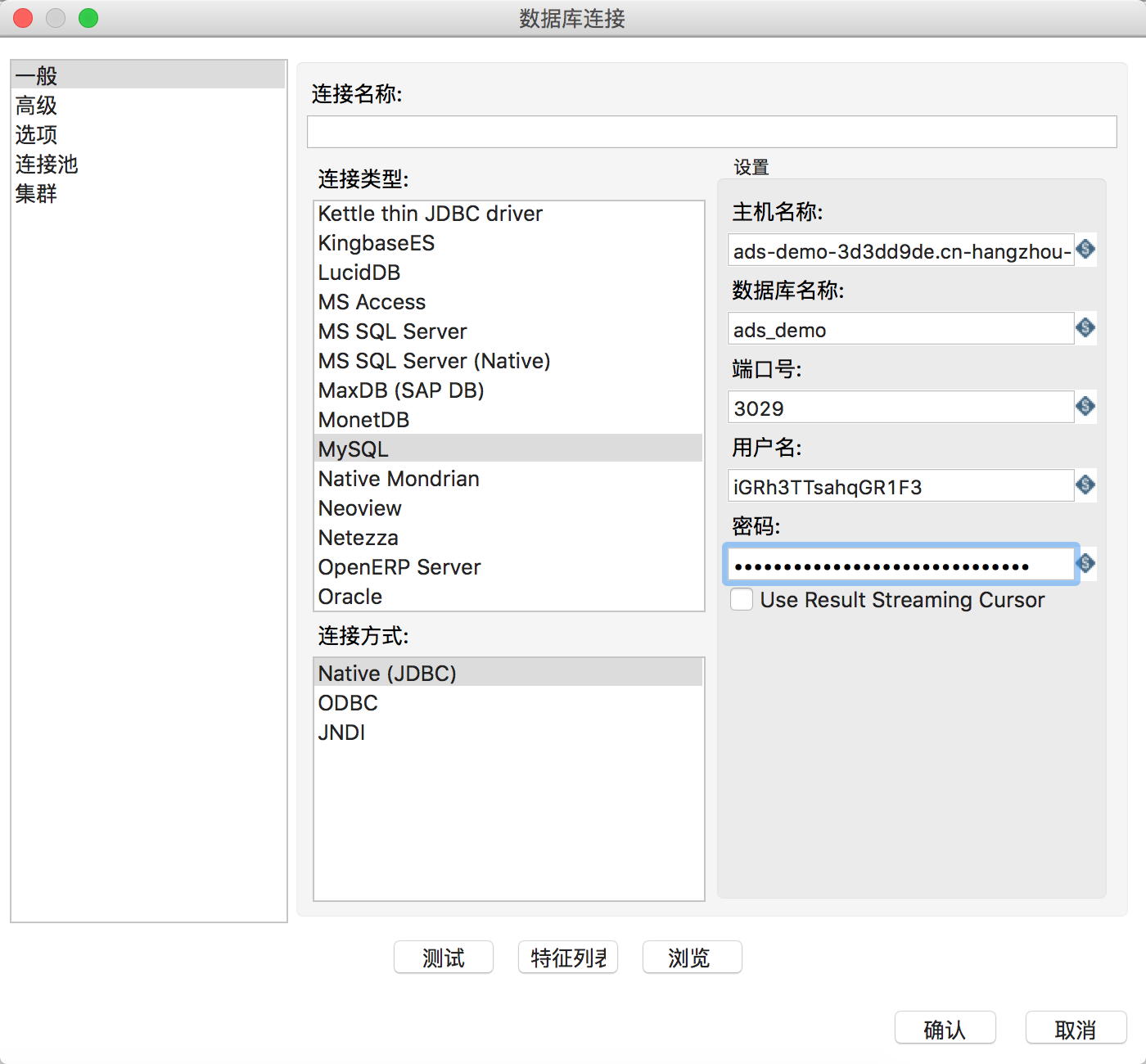

在该转换的DB连接中新建一项,连接类型选择MySQL,连接方式使用Native(JDBC)。主机名填写分析型数据库的连接域名,端口号填写链接端口号,用户名和密码填写accesskey信息,并去掉”Use Result Streaming Cursor”选项,如下图所示:

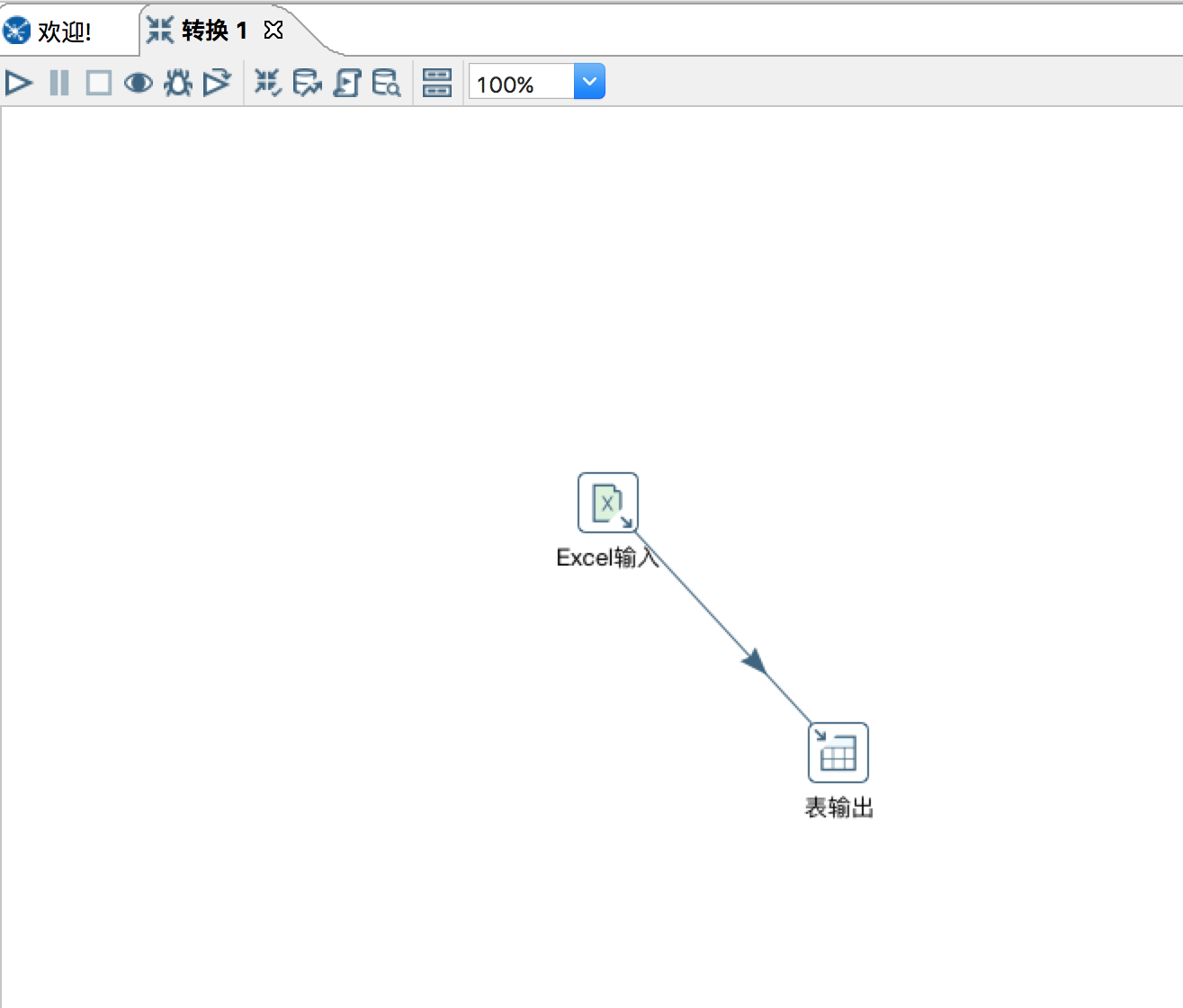

然后在kettle中,核心对象的“输入”中找到Excel输入拖拽到工作区,浏览并增加需要导入的Excel文件,根据实际需要设置工作表、内容、字段等选项卡,之后点击预览记录来查看输入的数据是否符合要求。

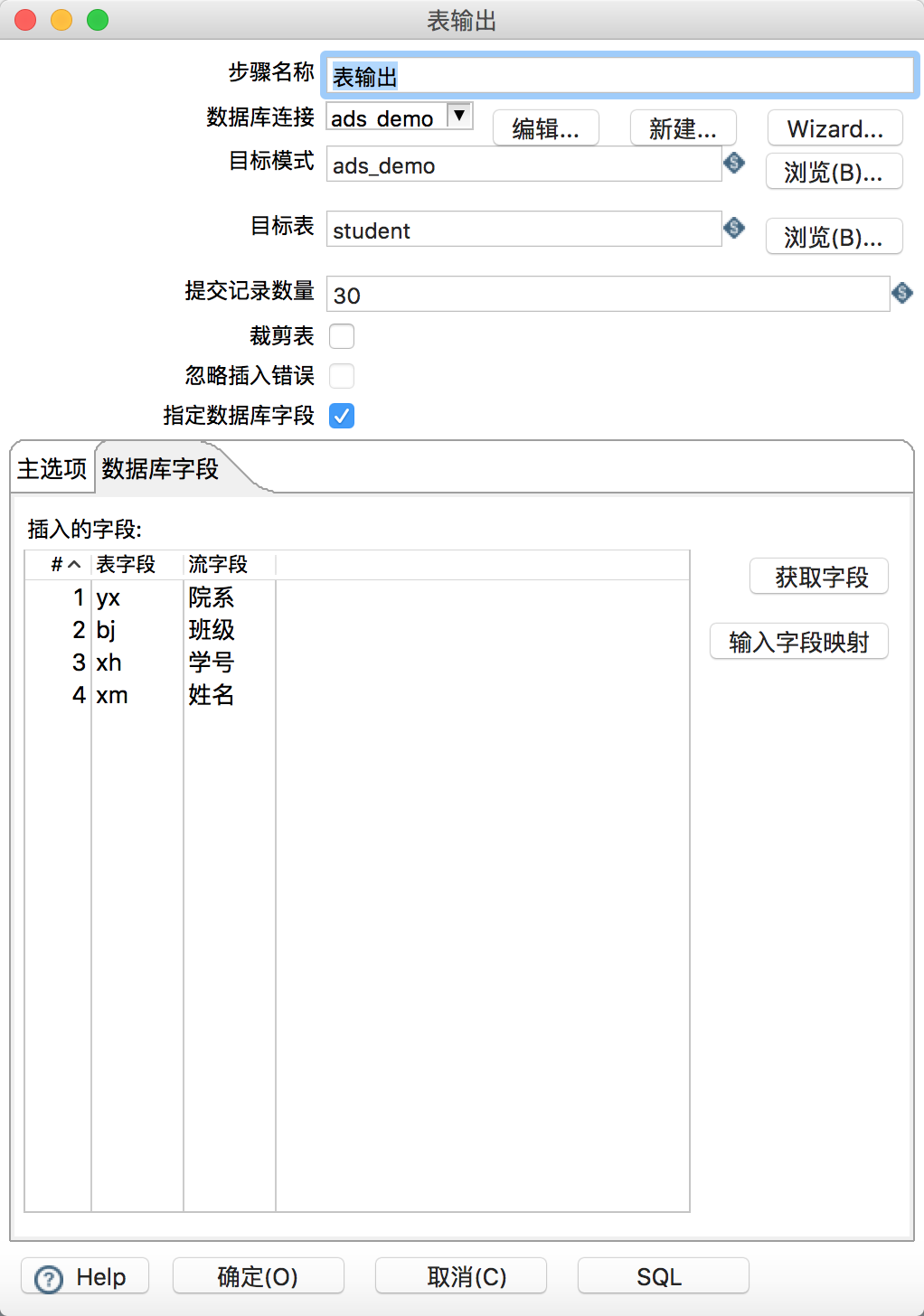

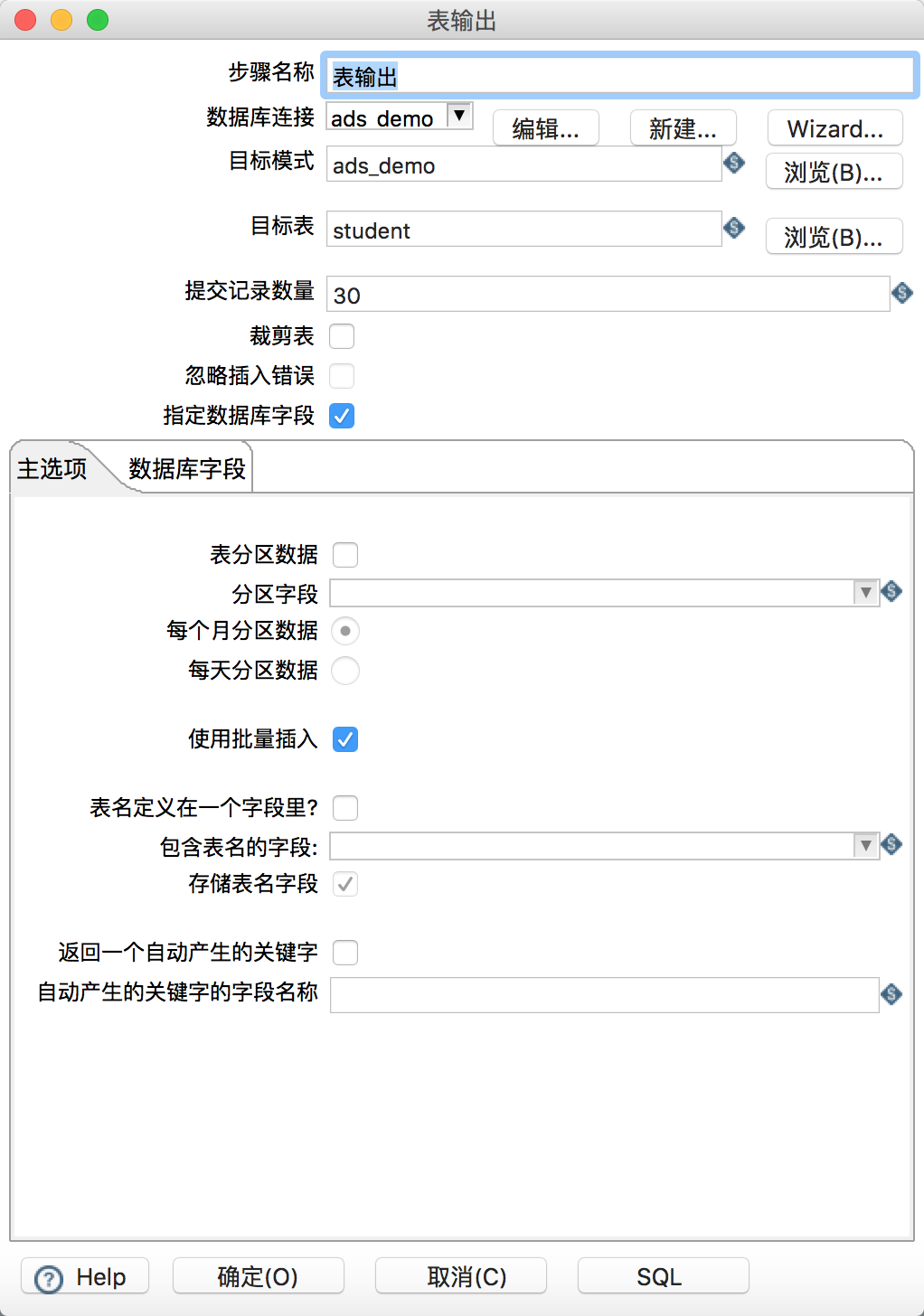

之后在核心对象的输出中找到表输出拖入工作区。新建一个从Excel输入指向表输出的连线。然后在表输出的属性中,手工填写目标模式(数据库名)、目标表名,暂不支持浏览功能。提交记录数量建议设置在30左右。选择“指定数据库字段”和“使用批量插入”,在数据库字段选项卡中点击获取字段和输入字段映射,映射excel文件的列与ads表的列名的映射关系,全部配置结束后如下:

之后便可单击白色三角箭头运行这个转换,观察运行日志和运行状态即可。

Kettle拥有非常强大的过滤、数据格式转换、清洗、抽取等功能,更多的使用详情请参考Kettle官方文档。

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。