dataworks这个分布式同步 如果数据源是MYSQL 原理是什么 根据主键进行任务拆分吗?

dataworks这个分布式同步 如果数据源是MYSQL 原理是什么 根据主键进行任务拆分吗?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

-

DataWorks 的分布式同步任务,当数据源是 MySQL 时,其原理主要是通过数据抽取、分发和加载的过程来实现数据的同步。在这个过程中,确实可能会根据主键或其他适当的列进行任务拆分,以实现数据的并行处理和同步。这样的拆分有助于提高数据同步的效率和速度。

具体来说,分布式同步任务可能会按照以下步骤进行:

数据抽取:首先,从 MySQL 数据源中抽取需要同步的数据。这通常是通过 SQL 查询语句来完成的,可以指定需要同步的表、条件等。

任务拆分:在数据抽取之后,DataWorks 可能会根据配置的策略对任务进行拆分。拆分的方式可能包括按照主键范围、数据量大小或其他适当的列进行。这样做的目的是将大任务拆分成多个小任务,以便在不同的节点上并行处理。

数据分发:拆分后的小任务被分发到不同的节点或计算资源上进行处理。这些节点可以是 DataWorks 提供的分布式计算资源,也可以是用户自定义的计算环境。

数据加载:在每个节点上,小任务会独立进行数据处理和同步。处理完成后,数据会被加载到目标系统中,这可以是另一个 MySQL 数据库,也可以是其他类型的数据存储系统。

结果合并:最后,各个节点上的处理结果需要进行合并,以确保数据的完整性和一致性。合并的方式可能包括去重、排序等操作。

分布式同步任务还涉及到数据的一致性、事务处理、错误处理等多个方面的问题,需要根据具体情况进行合理的配置和管理。

2024-03-03 19:20:13赞同 1 展开评论 -

面对过去,不要迷离;面对未来,不必彷徨;活在今天,你只要把自己完全展示给别人看。

DataWorks的分布式同步原理不完全是基于主键进行任务拆分,而是采用更为复杂的数据同步策略。

DataWorks的数据集成实时同步功能支持MySQL数据源,并且能够处理分库分表的场景。在面对大型工程中常见的多库多表结构时,DataWorks可以针对不同的表配置相应的同步任务。以下是DataWorks分布式同步的一些关键点:

- 数据源版本支持:DataWorks的实时同步功能目前支持配置MySQL数据源为RDS的5.x或8.x版本。

- 实时订阅机制:DataWorks通过实时订阅MySQL的变更日志来实现数据的实时同步,这种方式不需要对源数据库进行大量扫描,从而提高了效率。

- 附加列添加:在进行数据同步时,DataWorks会在同步的目标端添加5个附加列,这些列用于元数据管理、排序、去重等操作,以确保数据的准确性和一致性。

- 任务拆分策略:虽然主键是数据库中用于唯一标识记录的字段,但DataWorks在分布式同步时可能会采用更复杂的拆分策略,包括但不限于基于主键的拆分。这些策略可能涉及到数据的范围、更新频率、网络带宽等多种因素。

综上所述,DataWorks的分布式同步是一个复杂的过程,它不仅仅依赖于主键进行任务拆分,而是结合了多种技术和策略来确保数据同步的准确性和高效性。

2024-03-02 11:46:41赞同 展开评论 -

在DataWorks的分布式同步中,当数据源是MySQL时,其原理主要是基于数据分片和并行处理来提高数据同步的效率。这里并不是直接根据主键进行任务拆分,而是根据一定的策略将数据分成多个分片,每个分片可以由一个独立的任务或线程来处理。

数据分片的策略可以基于多种因素,包括但不限于:

主键或唯一键:在某些情况下,可以使用表的主键或唯一键来分片。例如,如果主键是一个自增的ID,那么可以将其范围划分为多个段,每个段由不同的任务处理。

哈希分片:使用哈希函数对记录的关键字段(如主键或某些业务字段)进行哈希计算,然后根据哈希值将数据分配到不同的分片中。

范围分片:根据某个字段的值范围将数据划分成多个分片。例如,对于日期字段,可以将不同日期的数据分配给不同的任务。

自定义分片策略:根据具体业务需求,用户可以自定义分片策略,比如基于业务逻辑或数据分布特点来划分数据。

在分布式同步过程中,DataWorks会根据配置的分片策略将MySQL中的数据拆分成多个分片,并为每个分片创建一个独立的同步任务。这些任务可以并行执行,从而加快数据同步的速度。每个任务会处理其分配到的数据分片,并将数据同步到目标数据库。

为了提高数据的一致性和避免重复同步,DataWorks通常会使用日志或检查点来跟踪已经同步过的数据,确保每个记录只被同步一次。

2024-03-02 11:05:42赞同 展开评论 -

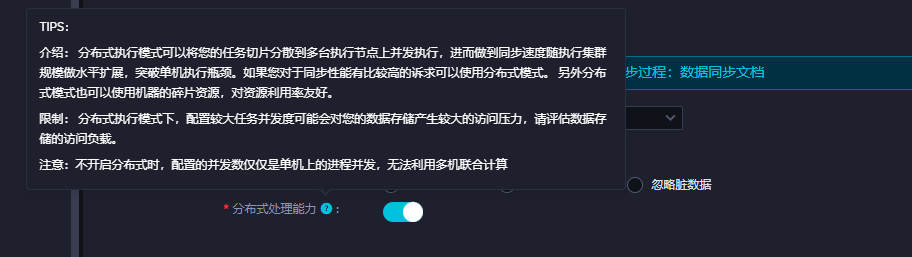

不希望任务单通道执行:配置切分键,任务并发数配置>=2 可以按照切分键切分sql多并发执行

开启分布式:在集成资源组有2台及以上的机器的时候 当并发数>=8可以开启分布式 从单机运行到多节点运行这些切分完的子任务 提速 ,此回答整理自钉群“DataWorks交流群(答疑@机器人)”2024-03-02 10:53:35赞同 展开评论

DataWorks基于MaxCompute/Hologres/EMR/CDP等大数据引擎,为数据仓库/数据湖/湖仓一体等解决方案提供统一的全链路大数据开发治理平台。