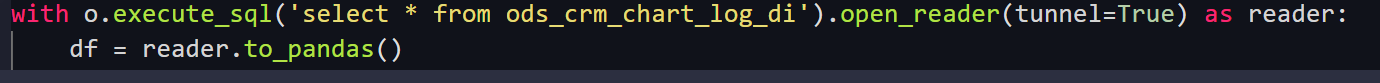

大数据计算MaxCompute一开始采取这种方式读数,但数据量太大时会报内存不够是为什么?

大数据计算MaxCompute一开始采取这种方式读数,数据小的时候不会报错,但数据量太大时会报内存不够是为什么?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在使用MaxCompute进行大数据计算时,当数据量较小时不会报错,但数据量增大时出现内存不足的问题,通常是由于以下几个原因导致的。以下是详细的原因分析及解决方案:

1. Executor内存不足

当数据量增大时,每个Executor需要处理的数据量也随之增加,可能导致内存不足。具体表现为java.lang.OutOfMemoryError异常。

解决方案:

-

调整Executor内存

设置参数spark.executor.memory以增加每个Executor的内存。通常建议与spark.executor.cores保持1:4的比例。例如,如果spark.executor.cores设置为1,则可以将spark.executor.memory设置为4 GB。 -

调整Executor堆外内存

如果日志中出现Cannot allocate memory或OOM Killer报错,可以通过增加spark.executor.memoryOverhead参数来扩展堆外内存。默认值为spark.executor.memory * 0.1,最小为384 MB。根据实际需求适当调大该值。

2. Driver内存不足

当Driver需要收集大量数据(如Collect操作)时,也可能出现内存不足的情况。

解决方案:

-

调整Driver内存

设置参数spark.driver.memory以增加Driver的内存大小。同样建议与spark.driver.cores保持1:4的比例。例如,如果spark.driver.cores为1,则可以将spark.driver.memory设置为4 GB。 -

调整Driver堆外内存

如果Driver日志中出现Cannot allocate memory报错,可以通过增加spark.driver.memoryOverhead参数来扩展堆外内存。默认值为spark.driver.memory * 0.1,最小为384 MB。

3. 数据倾斜问题

数据倾斜会导致某些Executor处理的数据量远大于其他Executor,从而引发内存不足。

解决方案:

-

增加Executor数量

调整参数spark.executor.instances以增加Executor的数量,从而分摊单个Executor的负载。 -

优化数据分布

如果数据倾斜严重,可以通过重分区(Repartition)或使用DISTRIBUTED MAPJOIN语法来优化数据分布。例如:SELECT /*+distmapjoin(t1)*/ request_datetime, host, URI, eagleeye_traceid FROM <viewtable> t0 LEFT JOIN (SELECT traceid, eleme_uid FROM <servicetable>) t1 ON t0.eagleeye_traceid = t1.traceid;这种方式可以有效缓解数据倾斜问题。

4. 外部表读取时内存占用过大

如果通过外部表读取OSS数据,且对象文件过多或未分区,可能导致内存占用过大,进而引发内存溢出。

解决方案:

-

减少单次读取的数据量

使用小数据量查询,避免一次性加载过多数据。 -

对对象文件进行分区

对OSS中的对象文件进行分区,以减少单次读取的内存占用。 -

调整Mapper和Reducer参数

通过以下参数控制每个Mapper和Reducer的处理数据量:set odps.sql.mapper.split.size=256; -- 调整每个Mapper读取数据的大小,单位为MB set odps.stage.reducer.num=100; -- 调整Reduce阶段的Worker数量这些参数可以帮助优化执行计划,避免单个任务处理过多数据。

5. UDF代码逻辑问题

如果使用了自定义UDF,且UDF代码逻辑复杂或处理时间过长,也可能导致内存不足。

解决方案:

-

优化UDF代码逻辑

检查并优化UDF代码,确保其处理效率满足需求。 -

调整UDF运行参数

通过以下参数提升UDF的运行性能:set odps.function.timeout=3600; -- 调整UDF运行超时时长,默认为1800秒 set odps.sql.udf.jvm.memory=4096; -- 调整Jvm内存大小这些参数可以帮助缓解UDF运行时的内存压力。

6. 磁盘空间不足

当本地磁盘空间不足时,也可能间接导致内存分配失败。

解决方案:

-

增加磁盘大小

调整参数spark.hadoop.odps.cupid.disk.driver.device_size以增加本地磁盘大小。默认值为20 GB,可根据实际需求调大该值。 -

增加Executor数量

如果单个Executor的Shuffle数据量过大,可以通过增加Executor数量来分摊负载。

总结

数据量增大时出现内存不足问题,通常与Executor、Driver、数据倾斜、外部表读取、UDF代码逻辑以及磁盘空间等因素相关。通过合理调整相关参数(如spark.executor.memory、spark.driver.memory、odps.sql.mapper.split.size等),优化数据分布和代码逻辑,可以有效解决内存不足问题。

如果您仍有疑问或需要进一步的帮助,请提供更多上下文信息以便更精准地解决问题。您可以复制页面截图提供更多信息,我可以进一步帮您分析问题原因。

MaxCompute(原ODPS)是一项面向分析的大数据计算服务,它以Serverless架构提供快速、全托管的在线数据仓库服务,消除传统数据平台在资源扩展性和弹性方面的限制,最小化用户运维投入,使您经济并高效的分析处理海量数据。