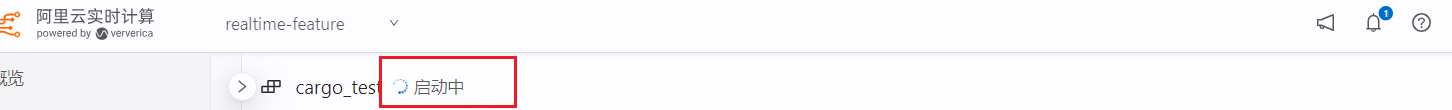

DataWorks中flink任务一直在启动中是怎么回事?

DataWorks中flink任务一直在启动中是怎么回事?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

-

全栈JAVA领域创作者

DataWorks中Flink任务无法正常停止可能是由于以下原因:

数据源问题:如果数据源没有正确关闭或者存在数据延迟,Flink任务会一直等待数据源返回结果,导致任务无法正常停止。

输出流问题:如果任务的输出流没有正确关闭,Flink任务会一直等待输出流关闭,导致任务无法正常停止。

JobManager问题:如果JobManager没有正确关闭,Flink任务会一直等待JobManager响应,导致任务无法正常停止。

节点问题:如果任务所在的节点出现问题,例如网络故障、机器故障等,Flink任务会一直处于启动状态。

为了解决这个问题,您可以尝试以下操作:检查数据源是否正确关闭:确保数据源在任务结束时正确关闭,例如使用ConnectionPool关闭连接。

检查输出流是否正确关闭:确保任务的输出流在任务结束时正确关闭,例如使用OutputStream关闭流。

检查JobManager是否正确关闭:确保JobManager在任务结束时正确关闭,例如使用JobManager.shutdown()方法关闭JobManager。

检查节点是否正确:确保任务所在的节点正确运行,例如检查网络连接、机器状态等。2023-08-09 15:33:02赞同 展开评论 -

北京阿里云ACE会长

可能的原因和解决方法:

任务配置错误:请确保您的任务配置正确无误,包括输入输出源的配置、任务逻辑、依赖关系等。检查任务配置并修正任何错误可能有助于解决启动问题。

资源不足:Flink任务可能需要足够的资源才能正常启动和运行。请检查您的任务所需的资源(例如CPU、内存)是否可用,并确保分配给任务的资源满足要求。

依赖项问题:如果您的任务依赖于其他组件或服务,例如数据库或消息队列,确保这些依赖项正常运行并且与任务能够正常通信。检查依赖项的连接和配置是否正确。

网络问题:检查网络连接是否正常,确保Flink任务能够与所需的外部资源正常通信。网络问题可能导致任务一直处于启动中的状态。

日志和错误信息:查看任务的日志和错误信息,以获取更多关于任务启动失败的详细信息。日志和错误信息可能提供有关问题的线索,有助于定位和解决启动问题。

2023-08-09 12:32:52赞同 展开评论 -

当DataWorks中的Flink任务一直处于启动中的状态时,可能有以下几个原因:

1、资源不足:Flink任务需要分配足够的资源才能正常启动和执行。可能是集群中的TaskManager资源不足,导致任务无法分配到足够的资源。可以尝试增加集群的资源配置或调整任务的资源需求。

2、依赖问题:Flink任务可能有一些依赖的外部组件或服务无法正常访问或启动,导致任务无法启动。可以检查任务的依赖是否正常并排除故障。

3、网络问题:Flink任务在启动过程中需要和集群中的各个节点进行通信,如果网络连接存在问题,任务可能无法正常启动。可以检查网络连接是否正常并确保集群节点之间能够相互通信。

4、日志检查:可以通过查看Flink任务的日志来了解任务启动过程中是否有任何异常或错误信息。日志中可能包含有关任务启动失败的详细信息,以帮助定位问题。

2023-08-09 07:53:55赞同 展开评论

DataWorks基于MaxCompute/Hologres/EMR/CDP等大数据引擎,为数据仓库/数据湖/湖仓一体等解决方案提供统一的全链路大数据开发治理平台。