在机器学习PAI中想将AkSinkStreamOp写入Ceph,有代码样例吗?

在机器学习PAI中想将AkSinkStreamOp写入Ceph,有代码样例吗?需要python样例,我看了下官网只有java针对hdfs的模板.

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

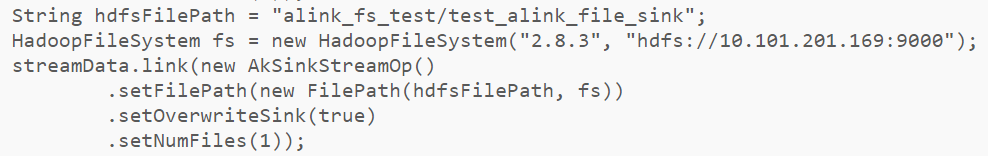

在机器学习PAI中,目前官方文档主要提供了针对HDFS的Java模板代码,而对于将AkSinkStreamOp写入Ceph的Python样例并未直接提供。不过,根据现有知识库中的内容和PyAlink脚本的相关说明,我们可以通过配置OSS路径的方式间接实现类似功能。以下是基于PyAlink脚本的Python代码示例,展示如何将数据写入Ceph存储。

1. 配置Ceph存储路径

Ceph通常通过S3协议进行访问,因此可以将其映射为OSS路径格式(如oss://bucket-name/path/to/data)。确保您已正确配置Ceph的访问凭证(AccessKey和SecretKey),并将其设置到环境变量或代码中。

2. Python代码示例

以下代码展示了如何使用AkSinkStreamOp将数据写入Ceph存储:

from pyalink.alink import *

# 初始化环境

useLocalEnv(1)

# 创建输入数据流

data = [

["a1", "11L", 2.2],

["a1", "12L", 2.0],

["a2", "11L", 2.0],

["a2", "12L", 2.0],

["a3", "12L", 2.0],

]

schema = "user string, item string, rating double"

input_data = BatchOperator.fromDataframe(data, schema)

# 配置Ceph存储路径

ceph_path = "oss://your-bucket-name/path/to/output.ak" # 替换为实际Ceph路径

endpoint = "http://your-ceph-endpoint" # 替换为实际Ceph S3 endpoint

access_key = "your-access-key" # 替换为实际AccessKey

secret_key = "your-secret-key" # 替换为实际SecretKey

# 写出数据到Ceph

output_sink = AkSinkBatchOp() \

.setFilePath(ceph_path) \

.setOverwriteSink(True) \

.setAccessKeyId(access_key) \

.setAccessKeySecret(secret_key) \

.setEndpoint(endpoint)

input_data.link(output_sink)

BatchOperator.execute()

3. 参数说明

ceph_path: Ceph存储的目标路径,需以oss://开头。endpoint: Ceph的S3兼容接口地址。access_key和secret_key: 访问Ceph所需的认证信息。setOverwriteSink(True): 如果目标文件已存在,则覆盖写入。

4. 注意事项

- 依赖安装: 确保已安装

pyalink库,并正确配置了Ceph的访问权限。 - 网络连通性: 确保运行代码的环境能够访问Ceph存储服务。

- 性能优化: 对于大规模数据写入,建议调整线程数(

numThreads)以提升性能。

5. 参考资料

上述代码基于PyAlink脚本组件的OSS写入方式进行了适配。如果您需要进一步优化或扩展功能,可以参考PAI平台的其他相关文档,例如OSS Pytorch Connector的实现逻辑。

如果仍有疑问,请提供更多具体需求,我们将为您进一步解答!

人工智能平台 PAI(Platform for AI,原机器学习平台PAI)是面向开发者和企业的机器学习/深度学习工程平台,提供包含数据标注、模型构建、模型训练、模型部署、推理优化在内的AI开发全链路服务,内置140+种优化算法,具备丰富的行业场景插件,为用户提供低门槛、高性能的云原生AI工程化能力。