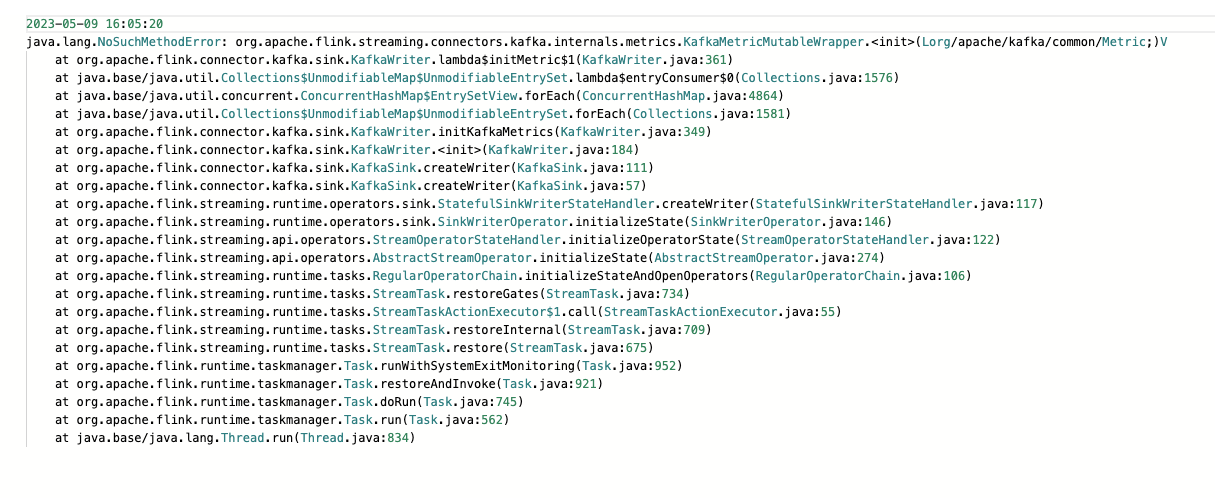

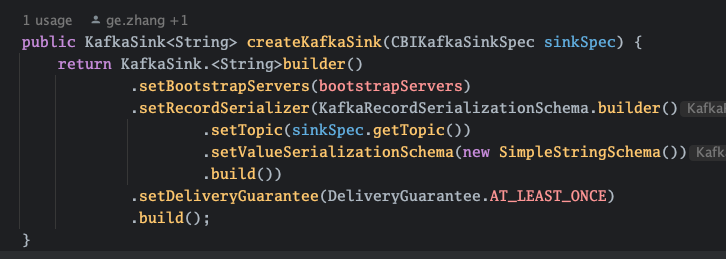

能请教一个问题吗?我往flink提交job的时候报错?

能请教一个问题吗?我往flink提交job的时候报错 spring boot形式,flink 1.17

spring boot形式,flink 1.17 有人碰到过吗?

有人碰到过吗?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

根据您提供的问题描述,您在提交Flink作业时遇到了与Spring Boot相关的报错。以下是可能的原因分析及解决方案:

1. 报错原因分析

根据知识库中的信息,以下可能是导致问题的原因:

1.1 Bean定义冲突

如果您的Spring Boot应用中存在重复的Bean定义(例如MyInput),可能会导致类似以下错误:

A bean with that name has already been defined and overriding is disabled

这通常是因为Spring Boot默认禁用了Bean覆盖功能,而您的代码中可能存在多个同名的Bean定义。

1.2 依赖冲突

Flink作业提交失败也可能是由于依赖冲突引起的。例如,Flink或Hadoop相关类的版本不一致可能导致以下异常:

java.lang.AbstractMethodError, java.lang.ClassNotFoundException, java.lang.NoSuchMethodError

这类问题通常出现在自定义函数或Connector开发中,尤其是当POM文件中的依赖版本与Flink运行环境不匹配时。

1.3 Flink版本兼容性

您提到使用的是Flink 1.17版本。如果您的Spring Boot应用中引入了与Flink 1.17不兼容的第三方库(如Connector或其他依赖),也可能导致作业提交失败。

2. 解决方案

2.1 检查并解决Bean定义冲突

-

启用Bean覆盖:如果您明确需要覆盖某些Bean定义,可以在

application.properties或application.yml中添加以下配置:spring.main.allow-bean-definition-overriding=true注意:启用此选项需谨慎,因为它可能导致意料之外的覆盖行为,仅在明确需要时使用。

-

审查Bean定义:检查您的Spring Boot应用中是否存在重复的Bean定义,并确保每个Bean名称唯一。

2.2 排查依赖冲突

-

检查POM文件:确保POM文件中Flink相关依赖的版本与运行环境一致。例如,Flink 1.17对应的依赖应为:

<dependency> <groupId>org.apache.flink</groupId> <artifactId>flink-streaming-java_2.12</artifactId> <version>1.17.0</version> <scope>provided</scope> </dependency>说明:Flink运行环境中已包含核心依赖,因此这些依赖的

scope应设置为provided。 -

使用Shade插件打包:对于第三方依赖,建议使用Apache Maven Shade Plugin进行打包,以避免依赖冲突。示例配置如下:

<plugin> <groupId>org.apache.maven.plugins</groupId> <artifactId>maven-shade-plugin</artifactId> <version>3.2.4</version> <executions> <execution> <phase>package</phase> <goals> <goal>shade</goal> </goals> </execution> </executions> </plugin>

2.3 确保Flink与Spring Boot兼容

- 升级Spring Boot版本:确保您的Spring Boot版本与Flink 1.17兼容。建议使用Spring Boot 2.6.x或更高版本。

- 检查Connector版本:如果您使用了MySQL或其他Connector,请确保其版本与Flink 1.17兼容。例如,MySQL Connector的版本应为

1.15-vvr-6.0.7或更高。

2.4 调整本地调试配置

如果问题仅在本地调试时出现,可以尝试以下绕行方案: - 将flink.version改为1.19.0。 - 删除flink-connector-base依赖。 - 添加兼容的Kafka Connector依赖(如1.17-vvr-8.0.4-1版本)。

3. 其他排查建议

- 查看日志:检查

jobmanager.log和taskmanager.log,定位具体的错误原因。例如,搜索关键字ERROR或Exception。 - 网络连通性:确保上下游服务与Flink工作空间之间的网络连通。如果跨VPC访问,请参考如何访问跨VPC的其他服务。

- 资源配额:确认Flink工作空间的资源配额是否充足。例如,检查是否有足够的内存或CPU资源。

4. 总结

通过以上步骤,您可以逐步排查并解决Flink作业提交失败的问题。如果问题仍未解决,请提供更详细的错误日志,以便进一步分析。

希望以上内容对您有所帮助!您可以复制页面截图提供更多信息,我可以进一步帮您分析问题原因。