性能问题分析遇到的问题

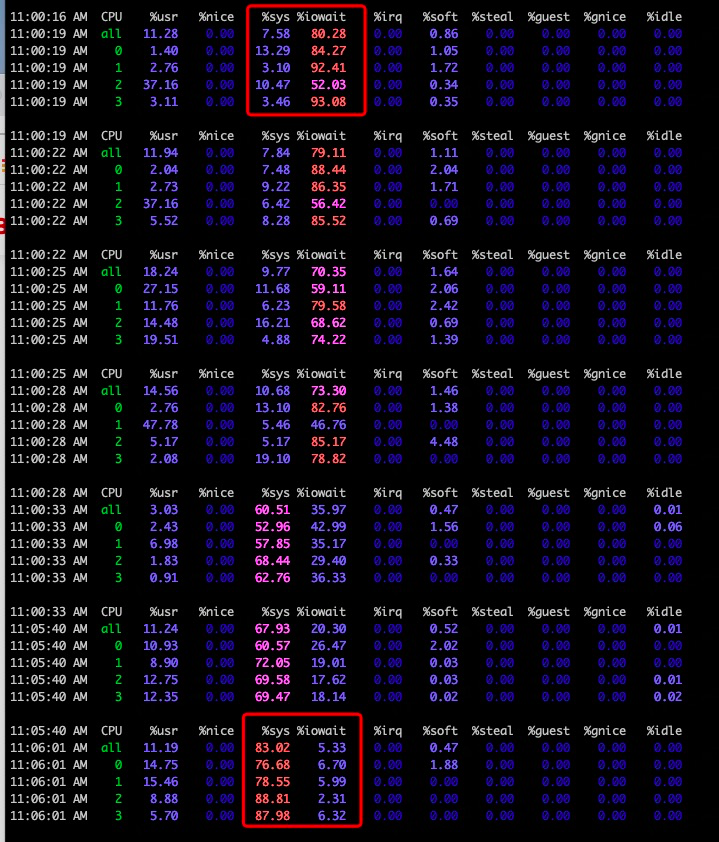

通过mpstat 查看CPU监控

开始是由于iowait(磁盘读)造成系统压力,负载升高 但是到了后面压力为什么变成了内核态的呢

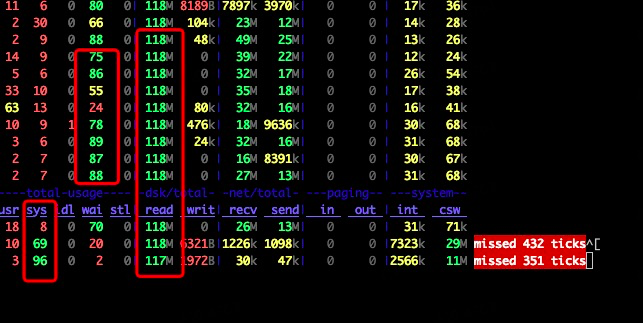

dstat监控,磁盘读速度比较高,而且同样是wait压力过大

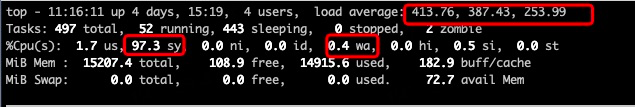

top监控,为什么是内核态CPU使用过高,而不是wait过高呢

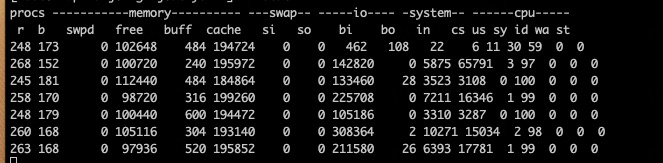

vmstat监控,有过多进程竞争CPU,但上下文切换算搞吗

望各位大佬解答下

展开

收起

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

阿里云 AI 助理回答

在分析您提到的系统监控指标时,我们可以从几个角度来理解这些变化:

-

mpstat与iowait:

mpstat显示的iowait高通常意味着CPU在等待I/O操作完成上花费了较多时间。这可能是因为磁盘读写速度慢、请求过多或队列深度大导致的。

-

dstat与磁盘读速度:

- 如果

dstat显示磁盘读速度较高且伴随高iowait,这进一步证实了系统正面临磁盘I/O瓶颈。大量的磁盘读取操作会占用资源,导致CPU等待数据返回,从而表现为iowait高。

- 如果

-

top与内核态CPU使用率:

- 当你观察到

top中内核态(kernel mode, 或称system CPU usage)的CPU使用率升高,这通常意味着系统正在执行内核任务,如处理中断、执行设备驱动程序代码、进行进程调度等。如果I/O操作频繁,内核需要更多时间来管理这些操作,因此内核态CPU使用率会上升。此外,如果应用程序进行了大量系统调用(如文件操作、网络通信),也会增加内核态CPU使用。

- 当你观察到

-

vmstat与上下文切换:

vmstat中的上下文切换次数(cs列)高,表明进程之间或线程之间的切换频繁。这可能是由于多个进程竞争CPU资源,导致操作系统频繁地在它们之间切换执行环境。虽然上下文切换是正常现象,但如果数量过高,会消耗额外的CPU周期,降低整体效率。结合您提到的“有过多进程竞争CPU”,这可能是导致系统响应变慢的一个因素。

总结来说,您的系统最初可能因为磁盘I/O瓶颈(iowait高)而承受压力,随着I/O操作持续,内核需要处理更多的I/O相关任务和上下文切换,导致内核态CPU使用率上升。同时,进程间的激烈竞争通过高上下文切换体现,进一步影响了系统性能。解决这类问题通常需要优化磁盘I/O性能(比如升级硬件、调整RAID配置、优化文件系统设置)、减少不必要的系统调用、优化应用程序逻辑以减少进程间竞争等措施。在阿里云上,还可以考虑使用更高级别的存储服务(如ESSD云盘)来提升I/O性能,或者利用弹性伸缩、容器服务等技术来更好地管理资源分配和负载均衡。

有帮助

无帮助

AI 助理回答生成答案可能存在不准确,仅供参考

相关问答