本期,我们继续来对阿里天池——淘宝用户购物行为进行分析,本期的重点是找出数据集中购买商品种类最多的用户及计算复购率(即:同一用户在不同时间购买同样的商品2次以上)。一、用户购买最多商品品类分析

我们先筛选出所有买商品的用户信息:

buy_max=df1.filter(pl.col('行为类型')=='buy')buy_max

通过group_by来聚合一下用户,并找到对商品ID栏中每个聚合进行唯一性检查。

#看看哪个用户买的商品种类最多?grouped_buy_max=buy_max.group_by('用户ID').agg(pl.col("商品ID").n_unique().alias("unique_values"))grouped_buy_max.sort(by="unique_values",descending=False)

看看用户ID为702034的购买者在这段时间都进行了些啥操作?

purchase_max_item=df1.filter(pl.col('用户ID')==702034)purchase_max_item

进行了203次操作,画个饼图看一下?

p_type=purchase_max_item.group_by('行为类型').len()p_type

#分析一下这位ID为702034的朋友的行为比例 import matplotlib.pyplot as pltplt.figure()plt.pie(p_type['len'], labels=p_type['行为类型'], autopct='%1.1f%%')plt.legend(p_type['行为类型'], loc="best")plt.show()

通过饼图看,这位ID为702034的朋友实在是一位豪爽的买家,pv次数只占所有操作的23.6%,72.9%都是购买,可以说是看了就买,都不带比较的,呵呵呵呵,两个字:豪横 二、商品复购分析寻找数据集中,同一用户在不同时间购买同样的商品2次以上。同样先进行一下行为类型的筛选:

rebuy=df1.filter(pl.col('行为类型')=='buy')rebuy

对用户ID进行聚合,找到每个用户买商品的次数:

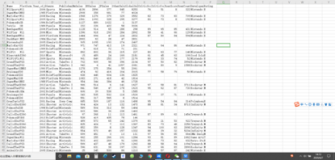

grouped_buy=rebuy.group_by('用户ID').agg(pl.col("商品ID").value_counts())grouped_buy

呃呃,商品ID这一栏中筛出来是list叠加struct类型,这怎么弄?有办法,用explode来拆一下,详见探索Pandas中的explode功能。

exploded_df =grouped_buy.explode('商品ID')exploded_df

继续拆分,用map_elements(Pandas中用apply)。

# 使用lambda表达式结合map_elements方法来展开商品ID列为两列df_with_split_columns = exploded_df.with_columns( pl.col("商品ID").map_elements(lambda x: x['商品ID']).alias("First_ProductID"), pl.col("商品ID").map_elements(lambda x: x['count']).alias("Count_ProductID")) df_with_split_columns

筛选出Count_ProductID中大于等于2的商品ID。

#选出Count_ProductID>=2的列,这些商品是用户复购的。df_with_split_columns.filter(pl.col('Count_ProductID')>=2)

复购率计算:

#计算复购率rebuy_rate=74123/1823954*100rebuy_rate

计算结果:4.06%。看来大部分用户还是选择一次购买一件商品,买完就结束,只有4.06%的商品被用户多次购买。

三、结语

好了,我们使用Polars对阿里天池——淘宝用户购物行为进行了分析,其中包括了:数据读取、时间戳的转换、用户行为总览、相关操作比例分析、数据清洗、用户行为变化趋势分析、复购率等等。通过Polars的数据分析,我们对整个数据集有了深入的了解。

Polars与Pandas相比,最大的优势在于大存储数据的处理。阿里天池中大部分数据分析都是基于截取其中500万行数据进行的,我们使用Polars就可以不用太纠结内存不够的问题,这就是Polars最大的优势,也是我们持续要学习Polars的一个非常重要的原因。