【论文原文】:Knowledge Distillation with the Reused Teacher Classifier

获取地址:https://ieeexplore.ieee.org/stamp/stamp.jsp?tp=&arnumber=9878899

博主关键词: 知识蒸馏,图像分类,重复使用

推荐相关论文:

-无

摘要:

知识蒸馏旨在将一个强大而繁琐的教师模型压缩成一个轻量级的学生模型,而不会牺牲太多的表现。为此,在过去几年中人们提出了各种方法,通常使用精心设计的知识表示,这反过来又增加了模型开发和解释的难度。相比之下,我们凭经验表明,简单的知识蒸馏技术足以显着缩小师生绩效差距。我们直接从预训练教师模型中重用判别分类器进行学生推理,并通过与单一l2损失的特征对齐来训练学生编码器。通过这种方式,学生模型能够实现与教师模型完全相同的性能,前提是他们提取的特征完全对齐。开发了一个额外的投影仪来帮助学生编码器与教师分类器匹配,这使得我们的技术适用于各种教师和学生架构。广泛的实验表明,由于增加了投影仪,我们的技术以适度的压缩比成本实现了最先进的结果。

关键词 :知识蒸馏,图像分类,重复使用。

简介:

给定一个具有大量参数的强大的教师模型,知识蒸馏(KD)的目标是帮助另一个参数化较少的学生模型获得与较大的教师模型[4,24]相似的泛化能力。实现这一目标的一个简单方法是通过给定相同的输入[2,24]来对齐它们的对数或类预测。由于KD技术的概念简单性和实用性,它在目标检测[8]、语义分割[32]和transfomer[45]的训练等各种应用中都取得了巨大的成功。

原版 KD 的一个局限性是,原始教师模型和蒸馏学生 模型之间的性能差距仍然很大。为了克服这个缺点,在过去的几年中人们提出了许多方法[19],[48]。他们中的大多数受益于利用预先训练的教师模型的额外监督,特别是中间层[1],[6],[39],[44],[46],[50],[53]。除了对齐普通的中间特征[6],[39],[50]之外,现有的工作通常都是基于精心设计的知识表示,如模拟空间注意映射[53]、两两相似性模式[36,37,46]或最大化教师和学生特征[1,44,55]之间的互信息。尽管我们确实看到这些方法在学生表现方面的不断改进,但在实践中,无论是有效的表示还是确保其成功的优化超参数都不容易实现。此外,转移知识的多样性阻碍了对学生表现最终改善的统一和明确的解释。

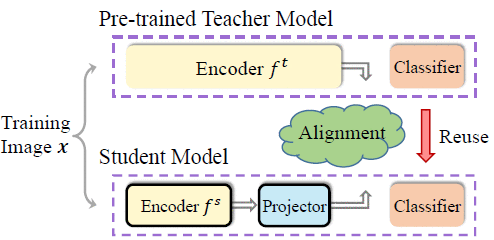

Fig. 1. An overview of our proposed SimKD.

在本文中,我们提出了一种简单的知识蒸馏技术,并证明它可以显著弥合教师和学生模型之间的性能差距,而无需复杂的知识表示。我们提出的“SimKD”技术如图1所示。我们认为,教师模型强大的类别预测能力不仅归功于这些表达特征,而且同样重要的是,判别性分类器。基于这个稍后会得到经验支持的论点,我们通过分类器前一层的特征对齐来训练学生模型,并直接复制教师分类器进行学生推理。这样,如果我们能够将学生的特征与教师模型的特征完美地对齐,他们的表现差距就会消失。也就是说,仅特征对齐误差就说明了学生推理的准确性,这使得我们的知识转移更容易理解。根据我们的实验结果,单一l2损失的特征对齐已经非常有效。如此简单的损失使我们不必像以前的工作那样仔细调整超参数,以平衡多重损失的影响[1],[6],[24],[39],[44],[46],[50],[53]。

由于从教师和学生模型中提取的特征的维度通常彼此不同,因此在学生特征编码器后添加一个投影仪来弥补这种维度不匹配。这种投影仪在师生压缩中,它的剪枝比成本通常小于3%,但它使我们的技术适用于任意的模型架构。在少数情况下,在添加的投影仪和重用的教师分类器的参数数小于原始学生分类器的情况下,甚至可以扩大剪枝率(见图7)。我们在标准基准数据集上进行了广泛的实验,并观察到我们的SimKD始终优于所有比较的最先进的方法。我们还表明,我们的简单技术可以很好地推广到不同的场景,如多教师知识蒸馏和无数据知识蒸馏。