Spark SQL CLI配置

SparkSQL可以兼容Hive以便SparkSQL支持Hive表访问、UDF(用户自定义函数)以及Hive查询语言(HiveQL/HQL)。

若要使用SparkSQLCLI的方式访问操作Hive表数据,需要对SparkSQL进行如下所示的环境配置(Spark集群已搭建好),将SparkSQL连接到一个部署好的Hive上

- 将hive-site.xml复制到/home/hadoop/app/spark/conf/目录下,所有节点都执行(路径根据自己的输入)

cd /home/hadoop/app/hive/conf/cp hive-site.xml /home/hadoop/app/spark/conf/

发送给其他两个节点scp hive-site.xml hadoop@slave1:/home/hadoop/app/spark/conf/scp hive-site.xml hadoop@slave2:/home/hadoop/app/spark/conf/ - 在/home/hadoop/app/spark/conf/spark-env.sh文件中配置MySQL驱动。

将MySQL驱动复制到所有节点的spark安装包的jars目录下,并在/home/Hadoop/app/spark/conf/spark-env.sh末尾添加:export SPARK_CLASSPATH=/home/hadoop/app/spark/jars/mysl-connector-java-5.1.32.jar启动 MySQL 服务

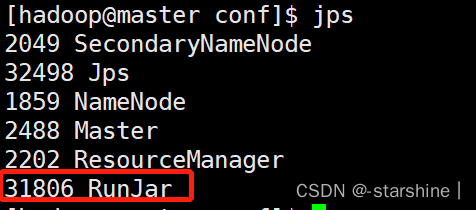

- 启动 Hive的metastore 服务:hive--service metastore &

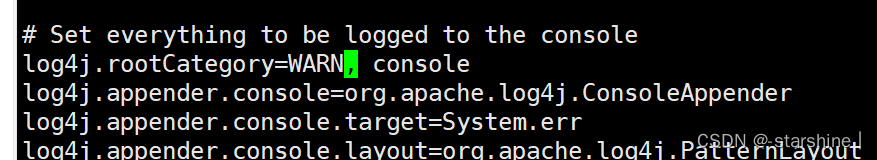

- 修改日志级别:进入/home/hadoop/app/spark/conf,

cp log4j.properties.template log4j.properties,修改文件

==log4jproperties==中==log4jrootCategory==的值,修改后==log4jrootCategory=WARN,console==

- 重新启动Spark集群:进入/home/hadoop/app/spark/sbin/目录,执行

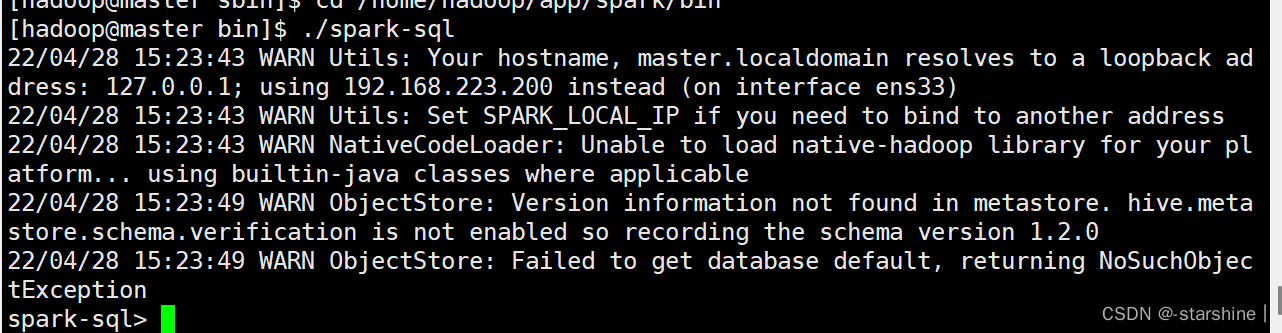

./stop-all.sh,再执行./start-all.sh - 启动spark-sql:进入/home/hadoop/app/spark/bin目录,执行

./spark-sql开启Spark SQL CLI