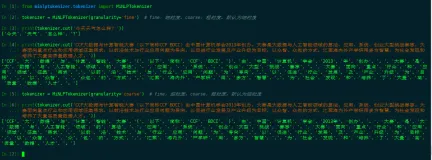

from nltk.corpus import brown

from nltk.tag import UnigramTagger, BigramTagger, TrigramTagger

# 从布朗语料库中获取文本数据,切分成句子

sentences = brown.tagged_sents(categories='news')

# 将4000个句子用作训练,623个句子用作测试

train = sentences[:4000]

test = sentences[4000:]

# 创建回退标注器

unigram = UnigramTagger(train)

bigram = BigramTagger(train, backoff=unigram)

trigram = TrigramTagger(train, backoff=bigram)

# 查看准确率

print(trigram.evaluate(test))NLTK词性标注

2023-01-11

86

版权

版权声明:

本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《

阿里云开发者社区用户服务协议》和

《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写

侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

简介:

本文实现基于NLTK的布朗语料库词性标注任务。

目录

相关文章

|

5月前

|

机器学习/深度学习

自然语言处理

Java

|

8月前

|

数据采集

自然语言处理

Serverless

使用Gensim库进行情感分析

【4月更文挑战第21天】使用Gensim进行情感分析,首先安装Gensim库(`pip install gensim`),然后导入所需模块,包括Word2Vec和KeyedVectors。对数据进行预处理,如分词和去除停用词。训练Word2Vec模型并保存,或加载预训练模型。最后,定义函数计算句子情感分数,并应用到文档上。代码示例展示了基本流程,实际应用中可按需调整。

99

10

10

|

机器学习/深度学习

自然语言处理

|

自然语言处理

Python

【NLP Tool -- NLTK】NLTK进行英文情感分析、分词、分句、词性标注(附代码)

NLP自然语言处理之NLTK工具的使用,进行英文情感分析、分词、分句、词性标注(附代码)

1107

0

0

|

自然语言处理

算法

Python

|

机器学习/深度学习

自然语言处理

Python

|

自然语言处理

算法

Python

情感分析-SnowNLP

SnowNLP是一个python写的类库,可以方便的处理中文文本内容,是受到了TextBlob的启发而写的,由于现在大部分的自然语言处理库基本都是针对英文的,于是写了一个方便处理中文的类库,并且和TextBlob不同的是,这里没有用NLTK,所有的算法都是自己实现的,并且自带了一些训练好的字典。

387

0

0

|

自然语言处理

Python

NLP之情感分析:基于python编程(jieba库)实现中文文本情感分析(得到的是情感评分)

NLP之情感分析:基于python编程(jieba库)实现中文文本情感分析(得到的是情感评分)

757

0

1

热门文章

最新文章

1

指数退避(Exponential backoff)在网络请求中的应用

2

流批一体的近实时数仓的思考与设计

3

【实战】锐捷AC+AP配置WLAN基本服务系列

4

丰富、连接、待集成—MaxCompute 生态再出发

5

为什么说流处理即未来?

6

Nginx报错403 forbidden几个解决方法

7

securecrt克隆会话与sshd 的 MaxSessions

8

Win7系统DIY工具 v 1.0

9

js 正则 数值验证

10

linux下java 调用 c jni 实现 HelloWorld

1

《docker高级篇(大厂进阶):1.Docker复杂安装详说》包括:安装mysql主从复制、安装redis集群

34

2

新版灵码AI程序员体验简评

48

3

【SpringFramework】Spring IoC-基于注解的实现

33

4

「Mac畅玩鸿蒙与硬件49」UI互动应用篇26 - 数字填色游戏

37

5

《基因测序新视界:人工智能的关键赋能》

38

6

《智启工业新篇:人工智能驱动的故障预测性维护》

30

7

《驯服“过拟合”之兽:守护人工智能算法的精准与稳健》

27

8

《特征工程:自动化浪潮下的坚守与变革》

26

9

《智破光影迷宫:人工智能图像识别的进阶挑战》

19

10

Qwen for Tugraph:自然语言至图查询语言翻译大模型微调最佳实践

46